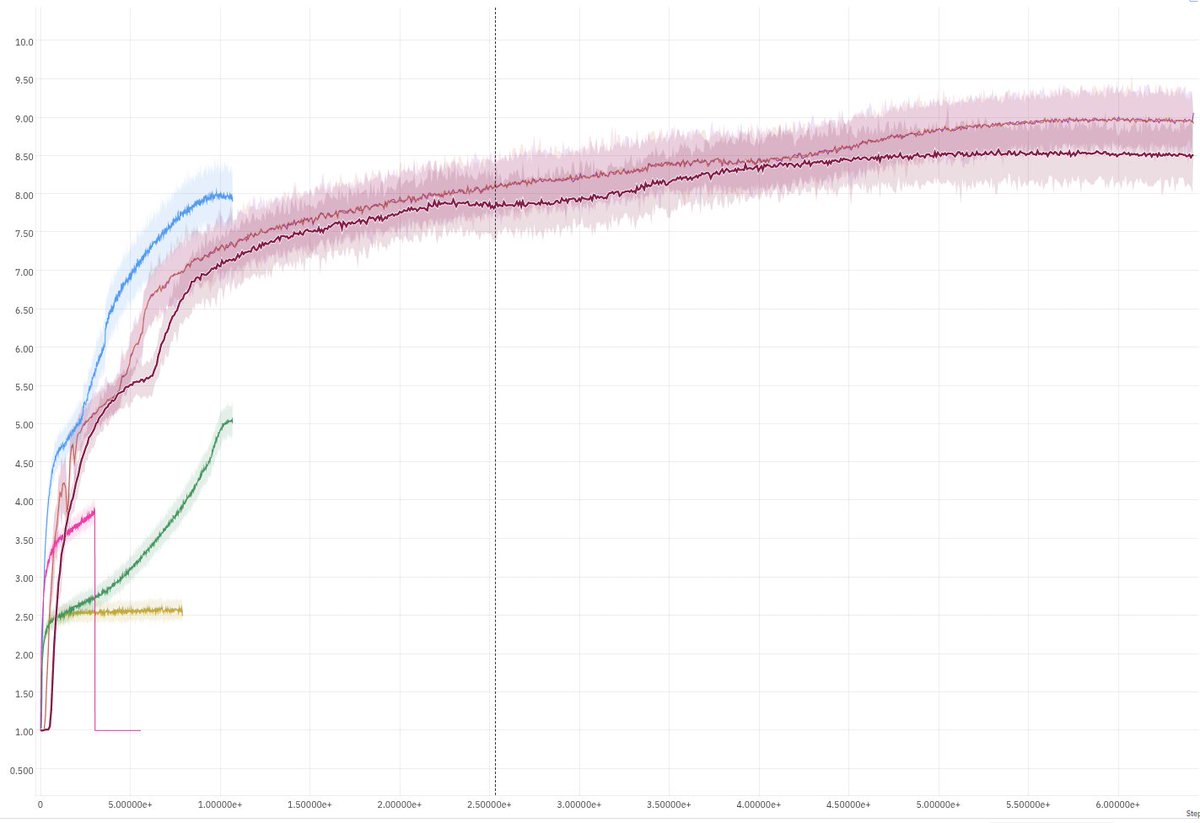

Obtivemos resultados de última geração (SOTA) incontestáveis no Neural MMO 3, nossa tarefa de aprendizado por reforço (RL) mais difícil, com 650 bilhões de etapas de treinamento (mais de 1 petabyte de observações por execução). O desempenho foi otimizado em termos de número de falhas (flops) e parâmetros. Qual é o problema? Para que isso seja útil, estou competindo com o cuDNN LSTM em termos de desempenho. E essa rede requer vários kernels.

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.