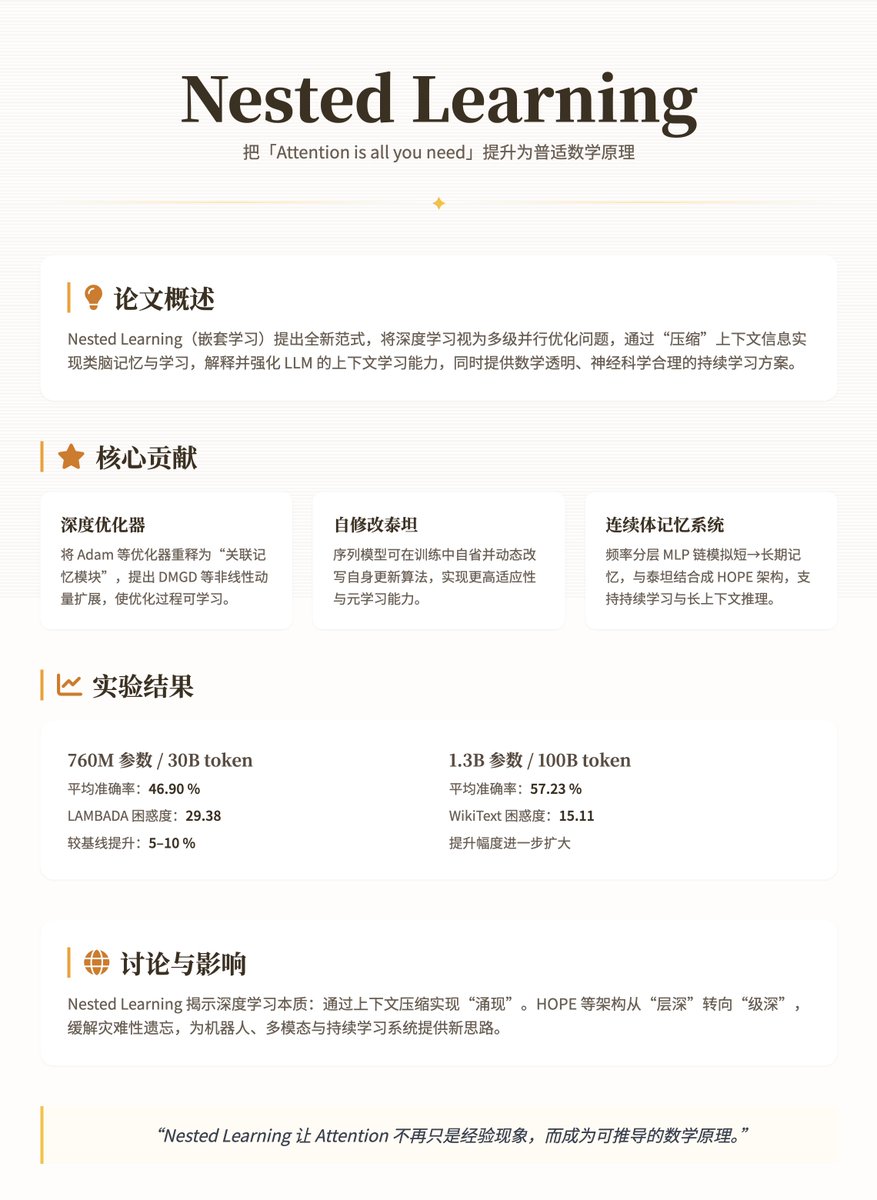

O mais recente artigo do Google Research, "Aprendizado Aninhado", baseia-se no Transformer, elevando o slogan "Atenção é tudo o que você precisa" de um fenômeno empírico para um princípio matemático mais profundo e universal. Este artigo propõe um novo paradigma de Aprendizado Aninhado para reexaminar e aprimorar modelos de aprendizado profundo, particularmente os Modelos de Aprendizado de Camadas (LLMs). O argumento central é que o aprendizado profundo tradicional não se limita a empilhar camadas, mas sim a "comprimir" informações contextuais por meio de problemas de otimização aninhados e multiníveis, alcançando assim um mecanismo de memória e aprendizado semelhante ao do cérebro. Isso não apenas explica as capacidades de "aprendizado contextual" dos LLMs, mas também fornece uma solução matematicamente transparente e neurocientificamente sólida para superar seus problemas de estática e esquecimento. Os principais conceitos e contribuições deste artigo modelam redes neurais como problemas de otimização paralela aninhados e multiníveis, com cada nível correspondendo a um "fluxo de contexto" diferente e frequências de atualização variando de alta a baixa (por exemplo, memória de curto prazo rápida para consolidação de longo prazo lenta). Isso se inspira nos processos de consolidação da memória em neurofisiologia: o cérebro processa informações por meio da consolidação sináptica online (ajuste em tempo real) e da consolidação do sistema offline (armazenamento de longo prazo). O aprendizado profundo tradicional é frequentemente considerado uma "ilusão" — aparenta ter uma arquitetura profunda, mas na verdade depende de otimizações aninhadas implícitas para comprimir gradientes ou sinais de atenção. As principais contribuições deste artigo incluem três aspectos: 1. Otimizadores Profundos: Estes reinterpretam otimizadores (como Adam ou SGD baseado em momentum) como "módulos de memória associados" que "lembram" informações históricas minimizando perdas de compressão de gradiente (como regressão ℓ₂). Os autores estendem esses otimizadores introduzindo, por exemplo, o Deep Momentum Gradient Descent (DMGD), usando MLPs multicamadas para lidar com momentum não linear ou adicionando pré-condicionadores para aprimorar a expressividade. Isso torna o processo de otimização mais semelhante a um submódulo aprendível do que a uma regra fixa. 2. Titãs Automodificáveis: Um tipo de modelo de sequência que pode modificar dinamicamente seu próprio algoritmo de atualização (similar à meta-aprendizagem). Isso permite que o agente faça uma "introspecção" e ajuste as atualizações de parâmetros durante o treinamento, alcançando maior adaptabilidade. 3. Sistema de Memória Contínua (CMS): Uma cadeia MLP com camadas de frequência, onde cada camada é atualizada em ciclos diferentes (por exemplo, a cada C passos), simulando o espectro contínuo da memória de curto prazo à de longo prazo. A combinação do CMS com o Titan automodificável forma a arquitetura HOPE — um modelo de linguagem eficiente que suporta aprendizado contínuo e raciocínio de longo contexto. Essas contribuições são rigorosamente definidas por meio de fórmulas matemáticas (como o objetivo de otimização da memória associativa min_M ˜L(M(K); V), ou atualização de momento m_{t+1} = α m_t - η ∇L), garantindo transparência e escalabilidade. Métodos e detalhes técnicos O núcleo da Normalização (NL) reside nas atualizações em múltiplas escalas temporais: o modelo é decomposto em camadas lineares ou mecanismos de atenção, cada um com seu próprio fluxo de gradiente dedicado. Por exemplo: • O treinamento simples de MLP pode ser visto como uma otimização de estágio único, usando sinais de surpresa local (LSS, discrepância entre a saída e o alvo) para direcionar o gradiente descendente. O mecanismo de atenção linear é composto por duas etapas: a camada interna atualiza a memória por meio da similaridade do produto escalar, e a camada externa otimiza a matriz de projeção. • O otimizador, como o momentum, é expandido para memória chave-valor: a chave é o gradiente histórico e o valor é o pré-condicionador P_i, alcançando uma compressão mais robusta. A arquitetura HOPE integra um CMS (cadeia MLP multinível: y_t = MLP^{(f_k)}(...MLP^{(f_1)}(x_t)...)) e um mecanismo de automodificação, suportando computação paralela e evitando a complexidade quadrática do Transformer. Durante o treinamento, as camadas internas são atualizadas rapidamente para capturar padrões imediatos, enquanto as camadas externas integram lentamente o conhecimento de longo prazo para mitigar o esquecimento catastrófico. Os autores testaram modelos com 340 milhões a 1,3 bilhão de parâmetros em tarefas de modelagem de linguagem (WikiText, LAMBADA) e raciocínio de senso comum (PIQA, HellaSwag, etc.), usando dados pré-treinados com 30 bilhões a 100 bilhões de tokens. As linhas de base incluíram Transformer++, RetNet, DeltaNet e Titans. Os resultados mostram que o HOPE supera significativamente os demais em perplexidade e acurácia. • Com 760 milhões de parâmetros/30 bilhões de configurações de token, o HOPE alcançou uma precisão média de 46,90% e uma perplexidade LAMBADA de 29,38, superando a linha de base em aproximadamente 5 a 10%. • Com 1,3 bilhão de parâmetros/100 bilhões de tokens, a precisão média é de 57,23% e a perplexidade do WikiText é de 15,11, mostrando uma melhoria mais significativa. Discussão e impacto O paradigma NL revela a essência do aprendizado profundo: alcançar capacidades "emergentes" por meio da compressão de contexto, como o aprendizado com poucos exemplos em LLMs. No entanto, também expõe limitações — os modelos são suscetíveis a mudanças de distribuição após a implantação estática. Inovações como o HOPE atenuam esse problema por meio de aninhamento multinível, inspirando arquiteturas futuras a migrarem da "profundidade de camada" para a "profundidade de nível", com aplicações potenciais em robótica ou sistemas multimodais. Endereço do papel

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.