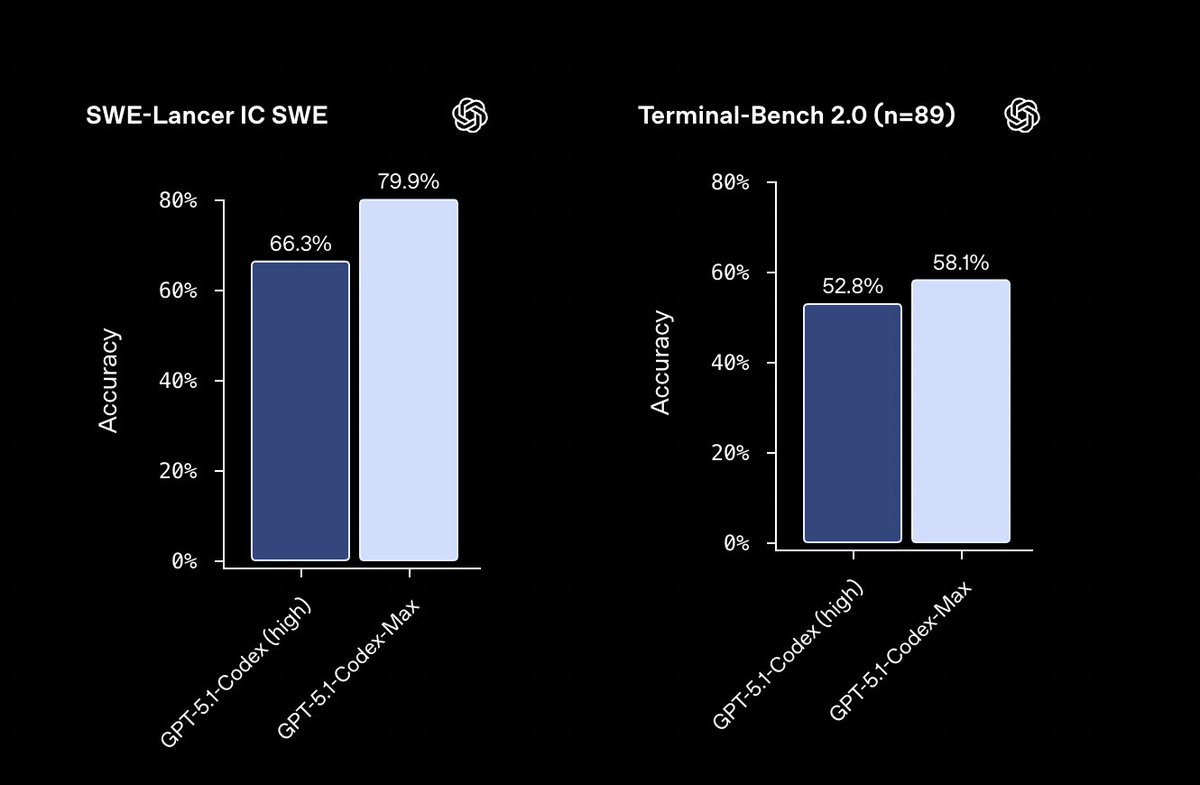

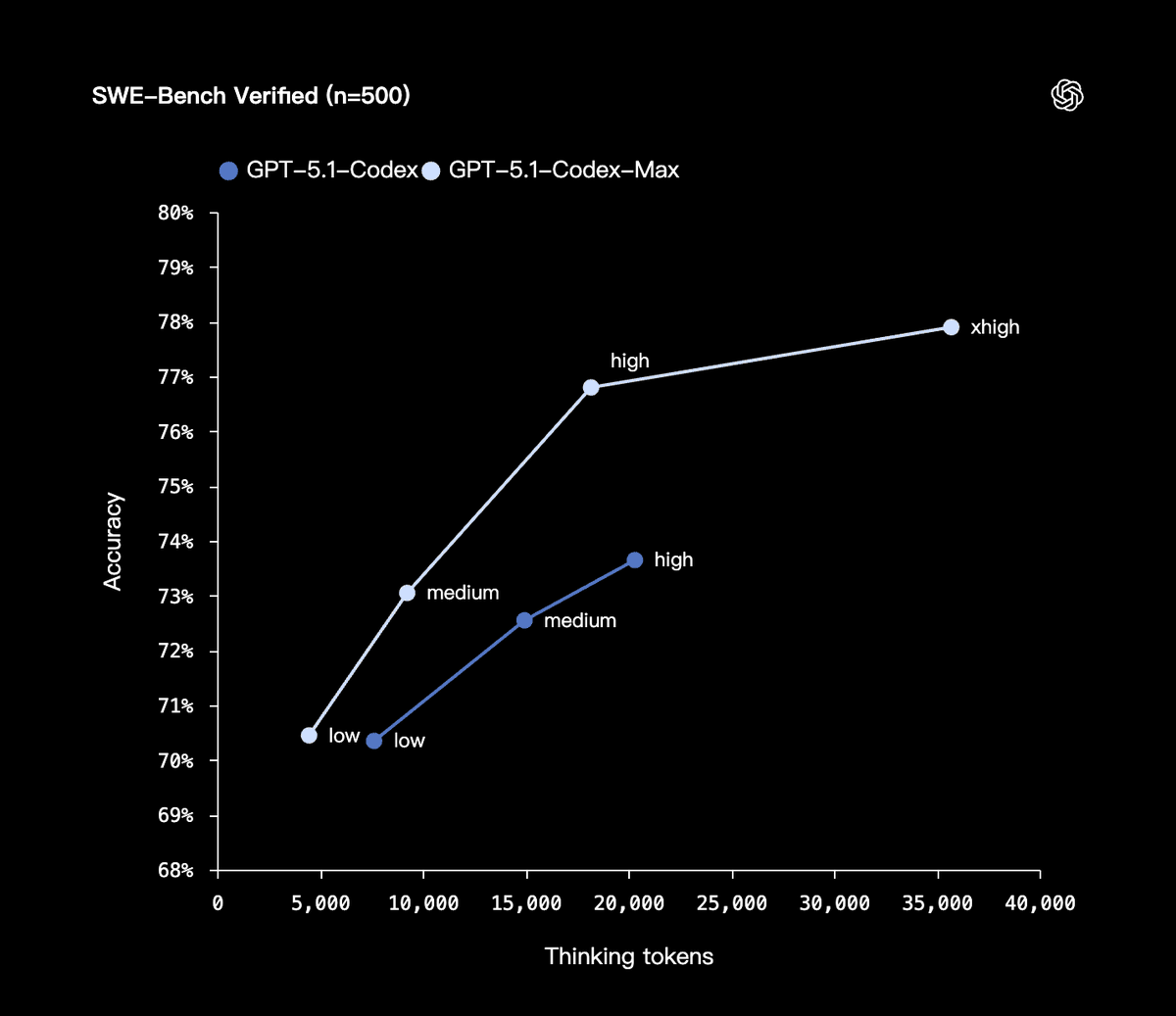

A OpenAI lançou seu novo modelo de código, GPT-5.1-Codex-Max, projetado para lidar com bases de código extremamente grandes e longos ciclos de desenvolvimento, tornando-o mais rápido e eficiente em termos de tokens, concluindo dezenas de horas de trabalho de uma só vez. A taxa de verificação do SWE-bench atingiu 77,9%, 4% superior à da geração anterior; Pensar em tokens permite economizar 30% em comparação com outros tokens da mesma qualidade. O Codex-Max consegue compreender tarefas complexas e planejá-las, executá-las e revisá-las iterativamente de forma autônoma. Ele emprega um novo mecanismo de compressão que pode simplificar o contexto de milhões de tokens e criar espaço para novas escritas, garantindo iteração contínua por 24 horas sem perda de informações. Internamente, o sistema reconstruiu de forma independente todo o repositório do Codex CLI, num ciclo de 24 horas, testando falhas, corrigindo-as e executando-as novamente antes de finalmente entregar a versão final. O GPT-5.1-Codex-Max substituirá o GPT-5.1-Codex e se tornará o modelo padrão na interface do Codex. #openai #GPTCodexMax

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.