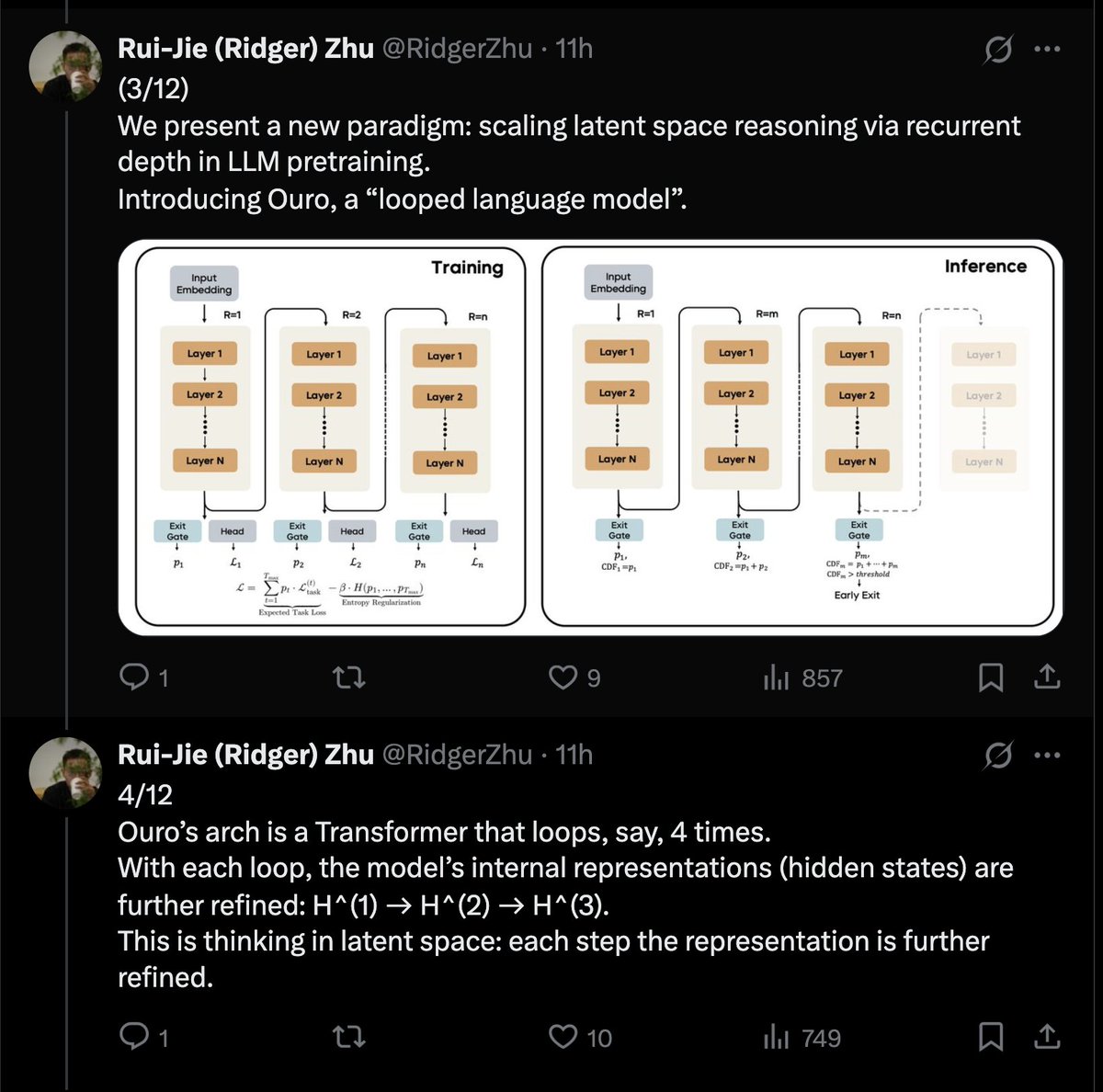

Seed realiza um Transformer em loop latente. É um método bastante maduro; o modelo pode ser encerrado em 2 iterações para tokens simples. Você não economizará poder computacional dessa forma, mas *obterá* melhores resultados com base no seu orçamento de dados. Espero que vejamos uma demonstração de eficácia (MoE) significativa mostrando o quão escalável isso é.

Carregando detalhes do thread

Buscando os tweets originais no X para montar uma leitura limpa.

Isso normalmente leva apenas alguns segundos.