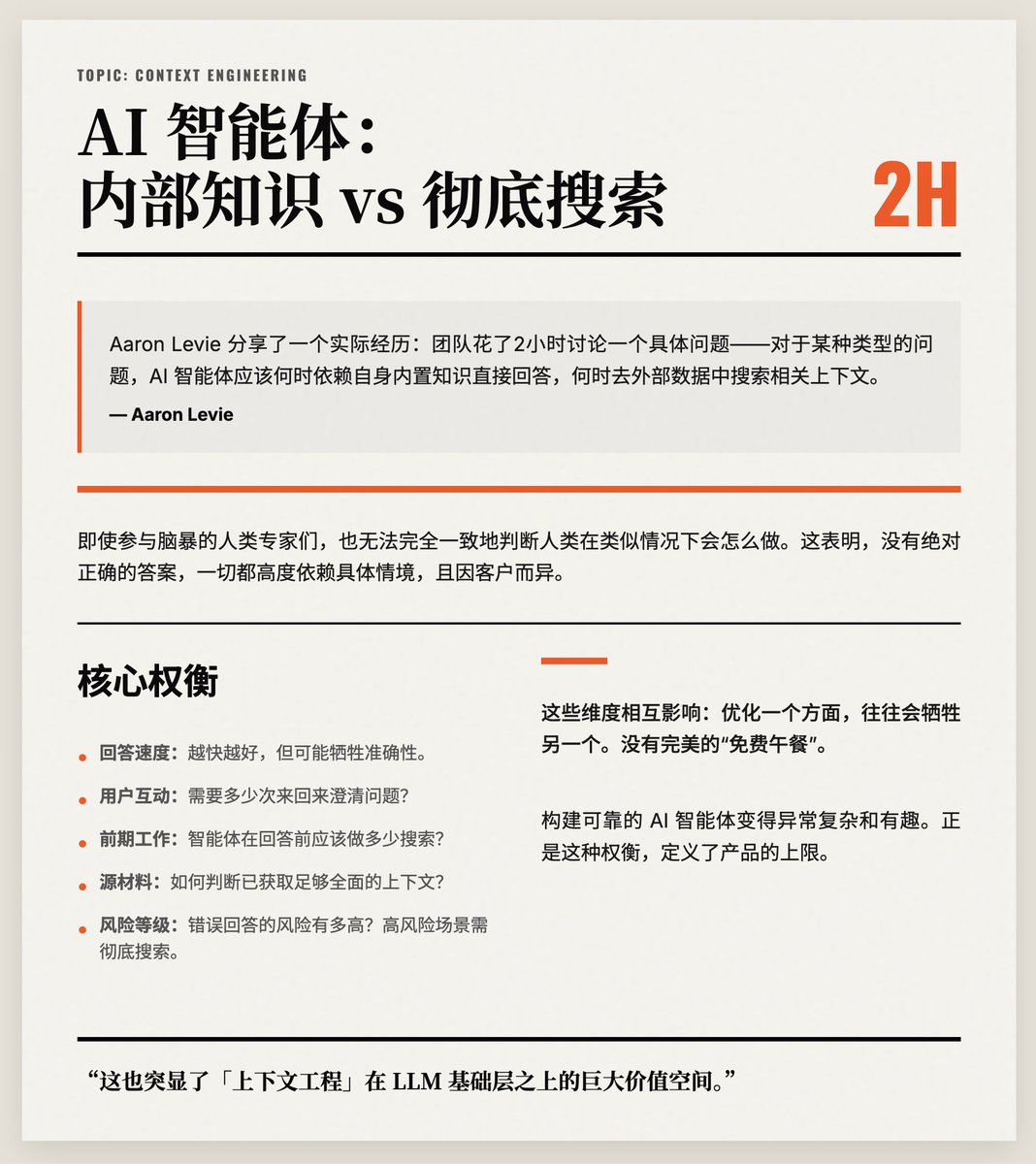

두 가지 사례를 중심으로 두 시간 동안 토론이 진행되었습니다. 인공지능 에이전트는 내부 지식에 의존해야 할까요, 아니면 철저한 탐색을 수행해야 할까요? 정답은 없으며, 바로 이 점 때문에 "컨텍스트 엔지니어링"이 인공지능 모델 위에 가장 가치 있는 레이어가 될 수 있습니다! 아론 레비는 실제 사례를 하나 소개했습니다. 그의 팀은 특정 문제, 즉 AI 에이전트가 특정 유형의 질문에 답할 때 언제 내장된 지식을 활용해야 하고 언제 외부 데이터에서 관련 맥락을 찾아야 하는지에 대해 두 시간 동안 토론했습니다. 그들은 수백 가지 테스트 케이스 중 단 두 가지만 논의했습니다. 브레인스토밍에 참여한 인간 전문가들조차도 비슷한 상황에서 인간이 어떻게 행동할지에 대해 의견 일치를 보지 못했습니다. 이는 절대적으로 옳은 답은 없으며, 모든 것이 상황에 따라 크게 달라지고 고객마다 다르다는 것을 보여줍니다. 레비의 핵심 주장은 컨텍스트 엔지니어링이 본질적으로 많은 절충점을 수반한다는 것입니다. 컨텍스트 엔지니어링은 다음과 같은 여러 차원을 동시에 고려해야 합니다. • 에이전트의 응답 속도(빠를수록 좋지만 정확도가 떨어질 수 있음); 사용자가 질문을 명확히 하기 위해 얼마나 많은 상호 작용이 필요할까요? • 상담원은 응답하기 전에 (데이터 검색과 같은) 사전 작업을 어느 정도 수행해야 할까요? 충분히 포괄적인 자료를 확보했는지 여부를 판단하는 방법; • 오답 발생 위험은 얼마나 됩니까? (위험도가 높은 경우, 철저한 검색이 권장됩니다.) 이러한 요소들은 서로 연결되어 있어, 한 측면을 최적화하면 다른 측면이 희생되는 경우가 많습니다. 완벽한 "공짜 점심"은 없습니다. 이러한 점 때문에 신뢰할 수 있는 AI 에이전트를 구축하는 것은 매우 복잡하면서도 흥미로운 작업입니다. 마지막으로 그는 이것이 LLM 기반 위에 구축된 "컨텍스트 엔지니어링"의 엄청난 가치를 강조한다고 역설했습니다. 이러한 절충점을 적절히 처리하는 것이 제품의 핵심 가치와 사용자 경험을 직접적으로 결정합니다.

스레드를 불러오는 중

깔끔한 읽기 화면을 위해 X에서 원본 트윗을 가져오고 있어요.

보통 몇 초면 완료되니 잠시만 기다려 주세요.