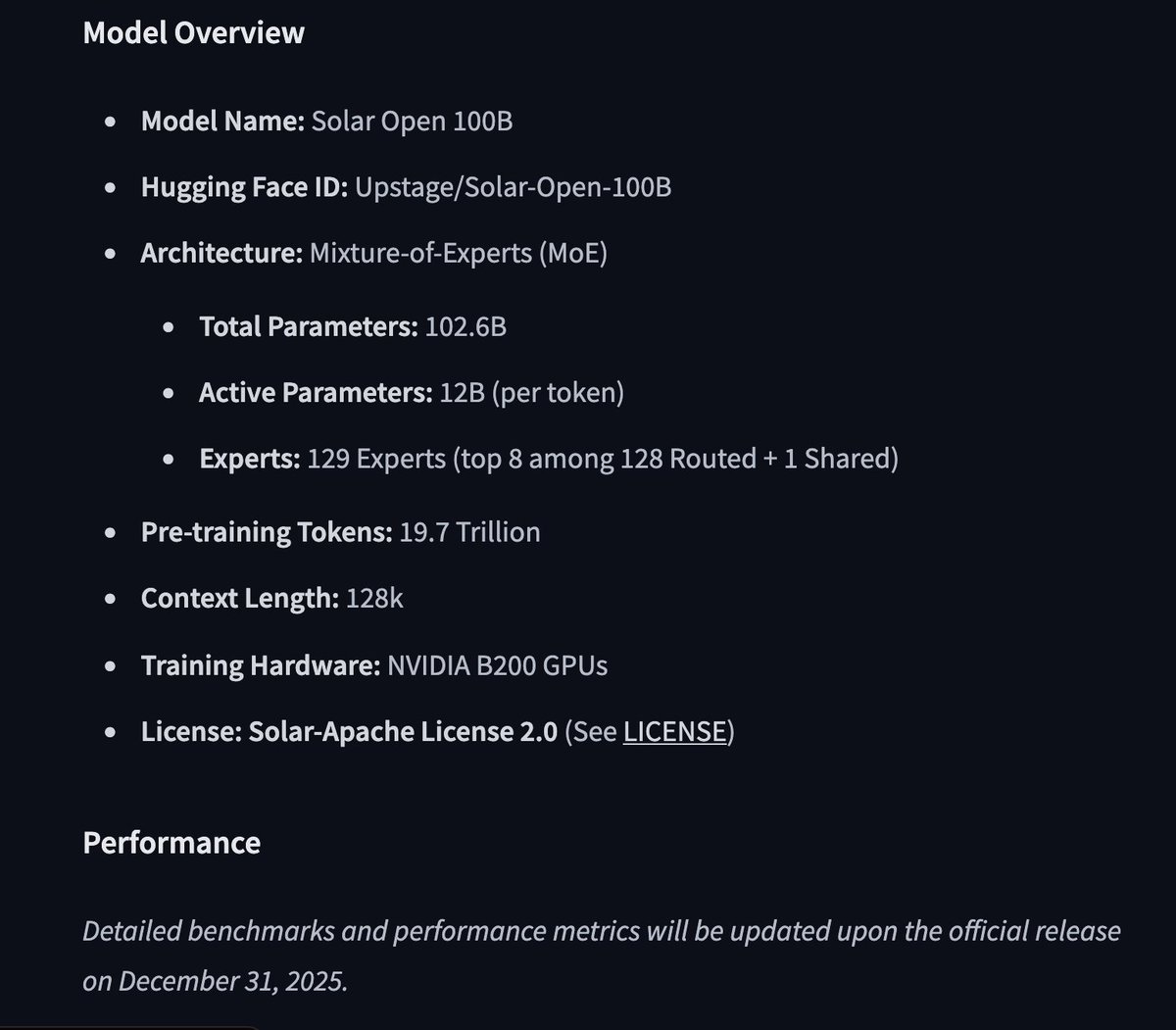

한국(업스테이지)은 블랙웰 플랫폼에서 "엔터프라이즈급"이라고 주장하는 1000억 등급의 교육부(MoE) 데이터베이스를 사전 학습시켰습니다. 이전에 큰 반향을 일으켰던 태양계 모델은 10.7B였는데, 이는 Mistral-7B를 심도 있게 확장한 흥미로운 실험으로 Mixtral 8x7B에 필적하는 모델이었습니다.

솔직히 말해서 DS-MoE가 어디에나 보이는 게 좀 지겹네요. Whale은 이 모든 것을 다시 한번 완전히 새롭게 만들어야 합니다. 구글 논문을 읽고, 활용 가능한 아이디어의 핵심을 파악하고, 거기에 자신만의 아이디어를 더하면, 앞으로 2년 동안 모두가 "아, 당연하지"라고 말할 겁니다.