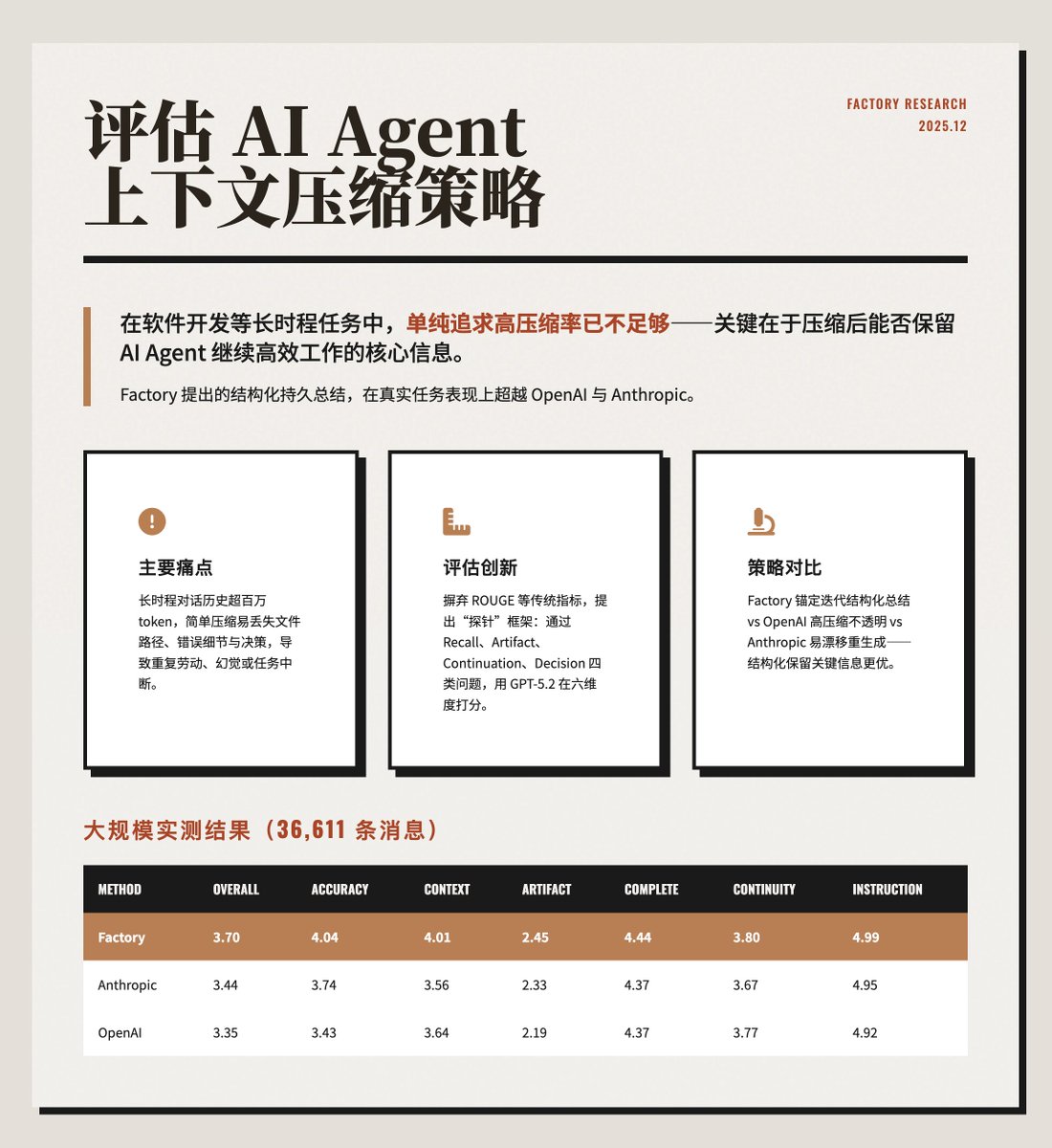

AI 에이전트의 컨텍스트 압축 전략을 평가합니다. 소프트웨어 개발과 같이 연속성이 요구되는 작업에서는 단순히 높은 컨텍스트 압축률만을 추구하는 것으로는 충분하지 않습니다. 더욱 중요한 것은 AI 에이전트가 효과적으로 계속 작동하기 위해 핵심 정보를 압축 과factory.ai/news/evaluatin…I(@FactoryAI)가 제안한 구조화된 요약 방식은 실제 작업에서 OpenAI와 Anthropic보다 우수한 성능을 보여줍니다. https://t.co/ZsCDxoVO3Q 주요 문제점 AI 에이전트가 장시간 실행될 경우, 방대한 양의 대화 기록(100만 개 이상의 토큰)을 생성하여 모델의 컨텍스트 윈도우 한계를 초과하게 됩니다. 단순 압축 방식으로는 파일 경로 변경, 오류 메시지, 이전 결정과 같은 중요한 세부 정보가 손실될 수 있으며, 이로 인해 AI 에이전트가 반복적인 작업을 수행하거나, 오류를 범하거나, 작업이 중단되는 문제가 발생할 수 있습니다. 본 논문에서는 효율적이고 지속적인 작동을 위해서는 "압축당 토큰 감소량"이 아닌 "작업당 토큰 소비량"을 최적화하는 것이 중요하다고 강조합니다. 본 논문에서 제안하는 평가 방법은 텍스트 유사성만을 측정하고 압축된 컨텍스트가 실제 작업의 지속을 지원하는지 여부를 평가할 수 없는 기존 지표(예: ROUGE 또는 임베딩 유사성)를 혁신합니다. 프로브 기반 평가 프레임워크를 제안합니다. • 압축 후, AI 에이전트에게 구체적인 질문을 하여 기억력을 테스트하십시오. • 프로브는 회상, 아티팩트, 연속성, 결정의 네 가지 범주로 분류됩니다. • GPT-5.2를 LLM 평가 도구로 사용하고 정확성, 상황 인식, 공작물 추적, 무결성, 연속성 및 지침 준수의 6가지 차원에서 0~5점 만점으로 평가합니다. 세 가지 압축 전략 비교: 팩토리 방식: "고정형 반복 요약"을 사용하여 의도, 문서 수정 사항, 결정 사항 및 다음 단계를 포함하는 구조화되고 영구적인 요약을 유지합니다. 새로운 콘텐츠는 매번 새로 생성되는 것이 아니라 점진적으로 병합됩니다. • OpenAI: `/responses/compact` 인터페이스를 사용하여 가장 높은 압축률(99.3%)을 달성하지만, 요약 정보가 불투명하고 파일 경로와 같이 엔트로피가 낮은 콘텐츠를 종종 버립니다. • Anthropic: 상세하고 구조화된 요약(분석, 문서, 작업 등 포함)을 생성하지만, 압축할 때마다 완전히 새로 생성되므로 요약 내용이 달라질 수 있습니다. 이 예시와 결과는 401 오류 디버깅의 특정 사례를 통해 이를 보여줍니다. Factory는 압축 후에도 오류 세부 정보와 근본 원인을 정확하게 기억하는 반면, OpenAI와 Anthropic은 일부 기술적 세부 정보를 손실합니다. 아래 이미지는 실제 운영 데이터(36,611개 메시지)를 사용한 대규모 테스트 결과를 보여줍니다. Factory는 정확성과 문맥 인식 측면에서 앞서 나갑니다. OpenAI는 가장 높은 압축률을 자랑하지만, 품질이 가장 낮아 정보 손실로 인해 검색 비용이 추가로 발생할 수 있습니다. 핵심 요점: 극단적인 압축보다는 구조를 우선시하라. 명확하게 구분된 요약은 핵심 정보를 더 잘 보존한다. 압축률만이 유일한 평가 기준은 아닙니다. 높은 압축률은 작업 효율성을 희생시킬 수 있으며, 총 토큰 소비량이 더 중요합니다. • 공작물 추적은 어려운 과제입니다. 모든 방법이 이 부분에서 낮은 점수를 기록하여 추가적인 인덱싱 메커니즘이 필요합니다. • 프로브 평가는 더욱 신뢰할 수 있습니다. 기존 자연어 처리(NLP) 측정 방식보다 실제 사용성을 더 잘 반영합니다.

스레드를 불러오는 중

깔끔한 읽기 화면을 위해 X에서 원본 트윗을 가져오고 있어요.

보통 몇 초면 완료되니 잠시만 기다려 주세요.