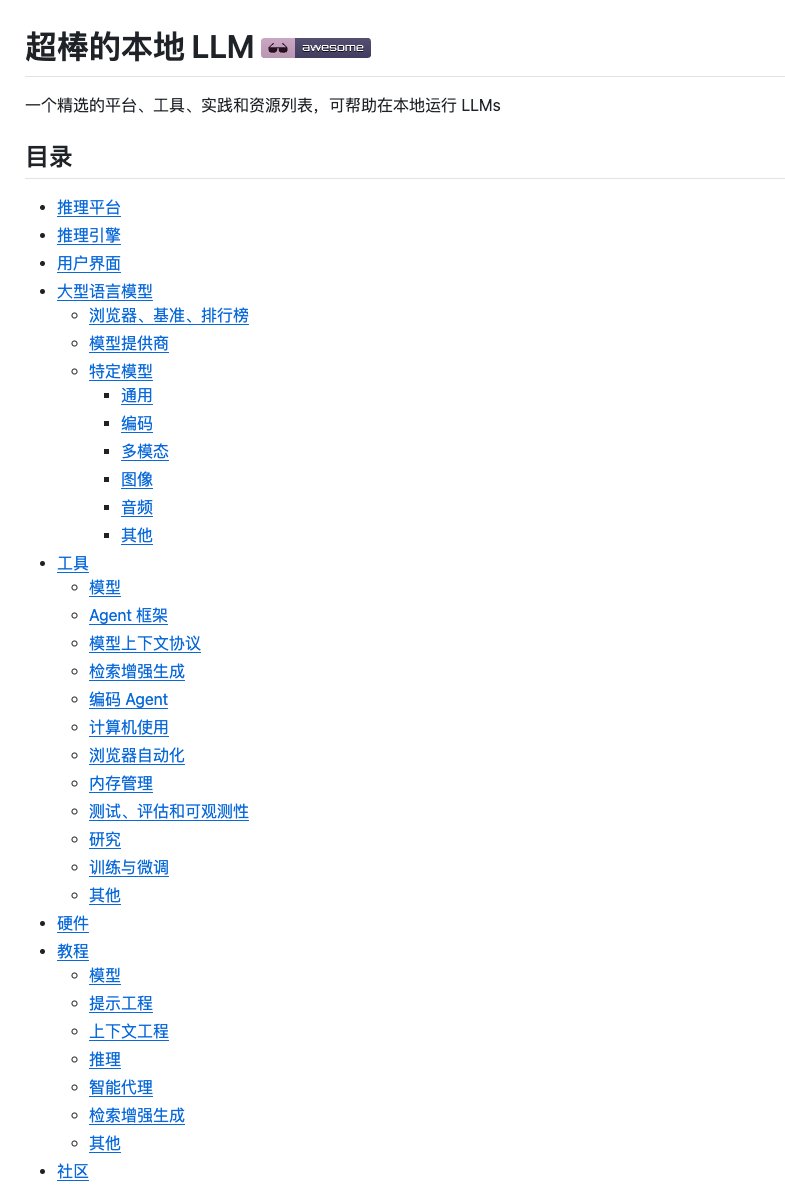

대규모 모델을 로컬 환경에 배포하는 것은 수많은 도구와 튜토리얼 때문에 막막할 수 있습니다. Ollam이 있는가 하면 vLLM도 있고, 온갖 종류의 미세 조정 프레임워크도 있습니다. 믿을 만한 솔루션을 찾는 것은 정말 어려운 일입니다. GitHub에서 대규모 모델을 로컬에서 실행하는 방법에 대한 "백과사전"과 같은 Awesome local LLM 프로젝트를 우연히 발견했습니다. 이 프로젝트는 내용이 포괄적일 뿐만 아니라 분류 논리도 매우 명확하여 기술 스택을 빠르게 이해하는 데 도움이 되었습니다. 이 책은 추론 플랫폼, 추론 엔진, 사용자 인터페이스, 대규모 언어 모델, 개발 도구 등 12개 이상의 범주를 다루며, 하드웨어 선택 조언과 실용적인 튜토리얼도 포함합니다. GitHub: https://t.co/9OJw4ll84L 각 프로젝트에는 GitHub 스타 수와 간단한 설명이 표시되어 있어 인기도와 목적을 쉽게 파악할 수 있습니다. 또한 YouTube 튜토리얼 및 하드웨어 리뷰와 같은 학습 자료도 포함되어 있습니다. 로컬 대규모 모델 환경을 구축하거나 특정 기능을 갖춘 오픈 소스 도구를 찾고 있다면, 이 모음집을 나중에 참고할 수 있도록 저장해 두는 것이 좋습니다.

스레드를 불러오는 중

깔끔한 읽기 화면을 위해 X에서 원본 트윗을 가져오고 있어요.

보통 몇 초면 완료되니 잠시만 기다려 주세요.