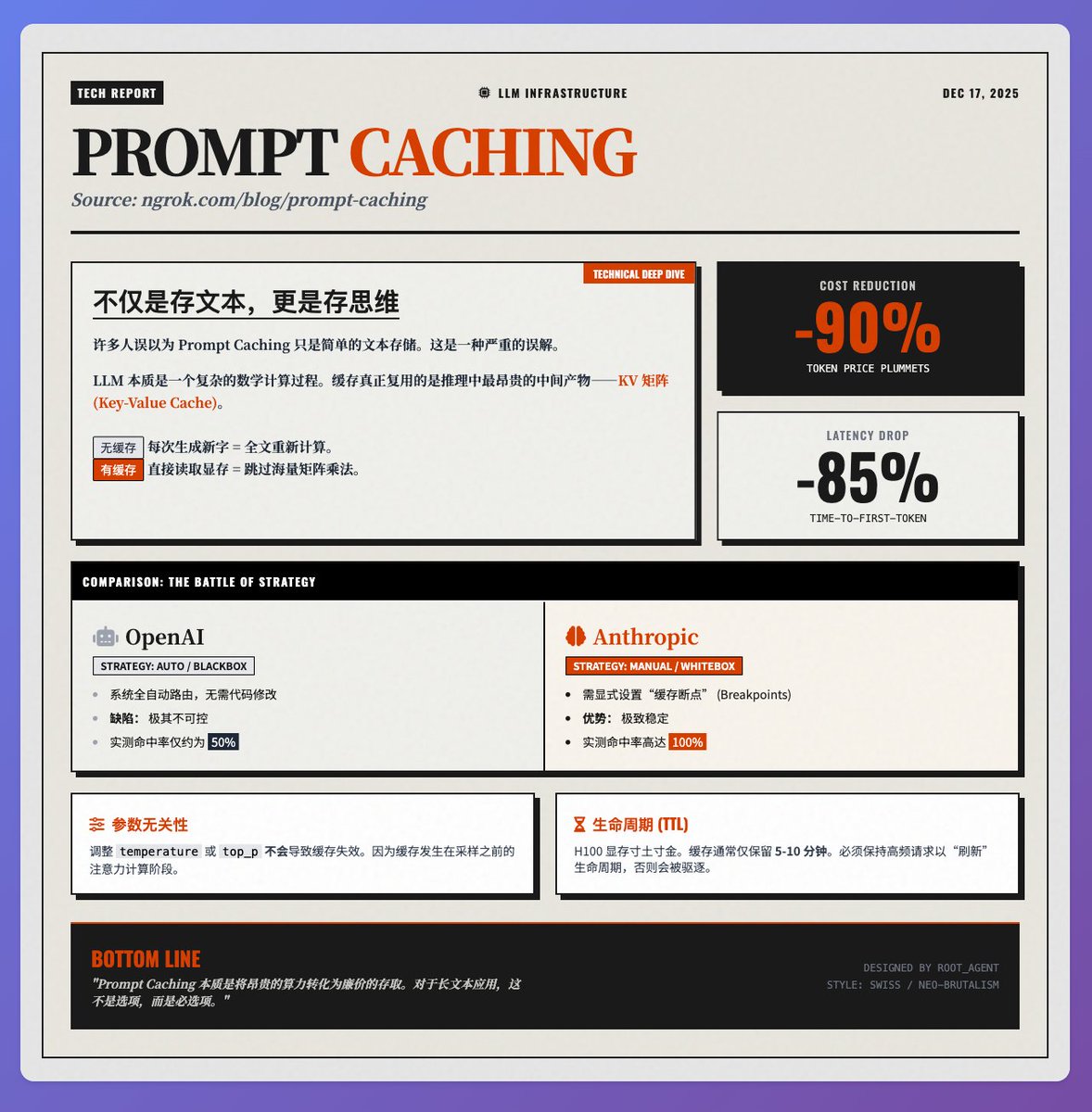

비용 90% 절감, 지연 시간 85% 감소: 프롬프트 캐싱 기술의 원리에 대한 심층 분석 @ngrokHQ 팀의 @samwhoo 님의 프롬프트 캐싱 관련 기술 블로그에서 Sam은 이 기술이 LLM 애플리케이션의 비용 절감 및 효율성 향상을 위한 "킬러 앱"으로 자리 잡게 된 과정을 기본 원리부터 실제 벤더 테스트까지 명확하게 보여줍니다. 핵심 원칙: 캐시되는 것은 "텍스트"가 아니라 "사고방식"이다. 많은 사람들이 프롬프트 캐싱이 단순히 입력 텍스트를 저장하는 것이라고 잘못 생각합니다. 실제로는 모델 추론 과정에서 가장 비용이 많이 드는 중간 산물인 K(키) 및 V(값) 행렬(즉, KV 캐시)을 재사용합니다. LLM은 각 토큰을 처리할 때 어텐션 메커니즘을 통해 문맥과의 관계를 계산해야 합니다. • 캐싱을 사용하지 않을 경우: 새 문자가 생성될 때마다 모델은 전체 텍스트의 K/V 행렬을 다시 계산해야 하므로 컴퓨팅 성능이 크게 낭비됩니다. • 캐싱 사용 시: 번거로운 행렬 곱셈 과정을 생략하고 이전에 계산된 행렬을 비디오 메모리에서 직접 읽어옵니다. 이러한 이유로 두 가지 이점을 제공합니다. 토큰 수수료를 약 90% 절감하고 긴 텍스트 시나리오에서 첫 단어 인식 지연 시간을 85% 줄여줍니다. 벤더 테스트: OpenAI와 Anthropic의 전략 차이 실제 배포 환경에서 이 두 주요 벤더의 전략은 극명하게 다르며, 이는 시스템 안정성에 직접적인 영향을 미칩니다. 1. OpenAI (완전 자동화 블랙박스): 이 시스템은 개발자가 코드를 수정할 필요 없이 캐시에 맞춰 요청을 자동으로 라우팅하려고 시도합니다. 하지만 이로 인해 예측 불가능성이 발생할 수 있습니다. 실제 테스트에서 캐시 적중률은 50% 안팎으로 불안정한 모습을 보였습니다. 2. 인류학적(수동 화이트 박스): 개발자는 "캐시된 중단점"을 명시적으로 설정할 수 있습니다. 이는 개발 진입 장벽을 높이지만, 적절한 설정으로 실제 테스트 환경에서는 100%에 가까운 성공률을 보입니다. 극도의 안정성이 요구되는 프로덕션 환경에서는 Anthropic이 현재 훨씬 더 뛰어난 성능을 발휘합니다. 개발자가 주의해야 할 기술적 세부 사항: 매개변수 독립성: 온도 또는 top_p와 같은 샘플링 매개변수를 조정해도 캐시가 무효화되지 않습니다. 이는 샘플링 전 어텐션 계산 단계에서 캐싱이 발생하기 때문이며, 이는 애플리케이션 디버깅에 상당한 유연성을 제공합니다. • 수명: H100 메모리의 높은 가격 때문에 캐시는 일반적으로 5~10분 동안만 유지됩니다. 장시간 재사용하려면 캐시 수명을 "갱신"하기 위해 높은 빈도로 요청을 보내야 합니다. 요약하다 프롬프트 캐싱의 핵심은 값비싼 "컴퓨팅 리소스"를 상대적으로 저렴한 "저장소 검색"으로 변환하는 것입니다. RAG(Real-Assisted Guided Grammar), 장문 문서 분석 또는 다중 턴 대화형 애플리케이션의 경우, 이는 비용 절감은 물론 사용자 경험을 크게 향상시키는 핵심 기술입니다. 원문 참조

스레드를 불러오는 중

깔끔한 읽기 화면을 위해 X에서 원본 트윗을 가져오고 있어요.

보통 몇 초면 완료되니 잠시만 기다려 주세요.