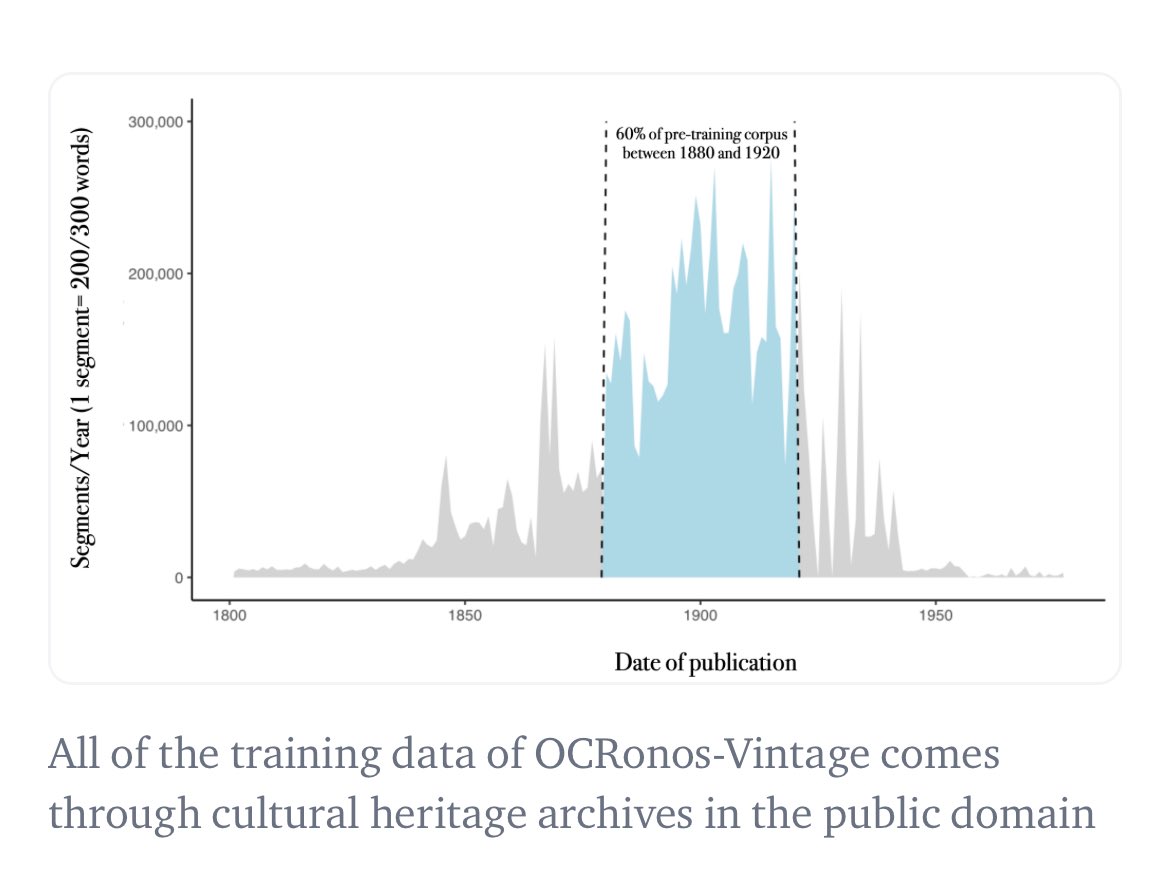

사실 저는 최초의 역사적 LLM(로지스틱 회귀 모델)을 훈련시켰다고 생각합니다. 저희 OCR 교정 모델인 Ocronos는 1950년 이전 데이터를 기반으로 완벽하게 사전 학습되어 기본 모델 모드에서 사용할 수 있었습니다. 주로 Chronicle America의 신문 자료를 활용했습니다.

역사적 맥락에 기반한 세대 모델의 예시입니다 (이 모델은 트럼프가 누군지 전혀 모르고 20세기 초반에 머물러 있습니다). 이 모델이 HF에서 여전히 인기가 있다는 것을 알게 되었습니다. https://t.co/1ye5VEGerd

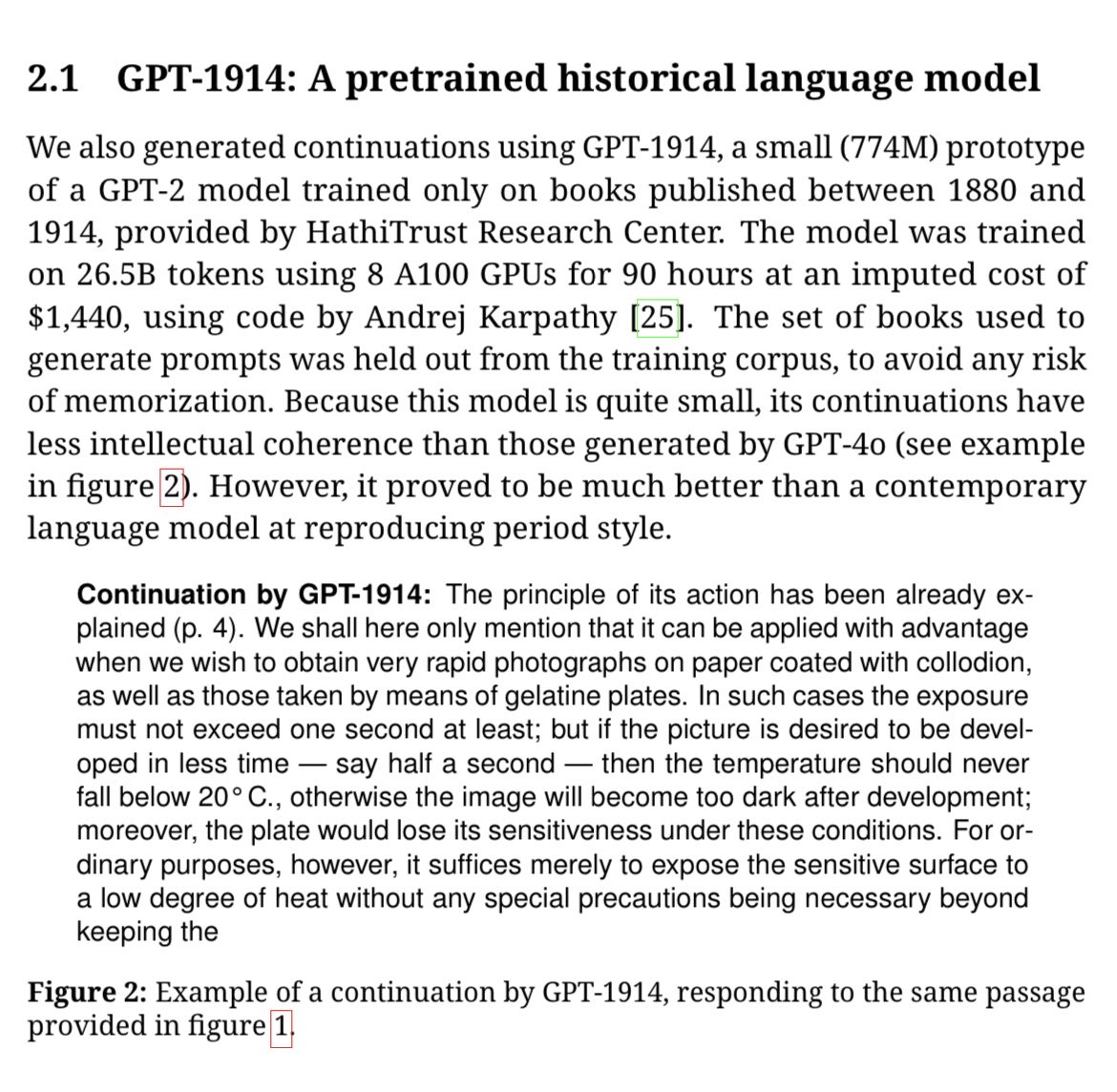

테드 언더우드 외 연구진은 GPT-1914라는 모델을 훈련시켰는데, 이는 현재까지 가장 큰 규모의 모델일 가능성이 높습니다(거의 8억 개의 데이터셋). https://t.co/wSA1WCmz2D