제가 좀 더 자세히 설명해 드리겠습니다. 많은 사람들이 이 주장의 지나치게 극단적인 버전을 믿고 있는 것 같습니다. 하지만 기본적으로는 옳은 다른 버전의 주장도 많이 있다고 생각합니다.

참이지만 알려지지 않은 명제 P에 대한 "지식을 생성한다"는 것은 무엇을 의미할까요? 제 생각에는 LLM(논리적 논리 모델)에서 참이고 P를 함축하는 "인수" A를 도출하는 맥락 명제 C가 존재하는 것을 의미합니다. 만약 이것이 가능하다면, 그것은 P에 대한 지식을 생성한 것입니다.

그러니까, 인용된 주장의 가장 명백하게 틀린 버전은 그런 일이 일어날 수 없다는 것입니다. 분명히 가능하고, 대부분 아주 사소한 방식으로 항상 일어나고 있습니다. 내 앱의 특정 기능을 구현하는 코드를 알 수 없습니다. LLM에 문의하면 코드가 나옵니다. 짜잔, 새로운 지식을 얻게 된 거죠.

자, 그럼 본격적인 분석을 시작해 볼까요? 우선 가장 기본적인 점부터 말씀드리겠습니다. LLM이 "알고 있는" 것은 단기적으로는 고정적입니다. 세션 사이에는 모든 것을 잊어버립니다. A를 도출했다고 해서 자동으로 P를 "알게" 되는 것은 아닙니다. 이는 사람들과는 조금 다르게 느껴질 수 있습니다.

유클리드가 I.46, 즉 정사각형을 작도할 수 있다는 것을 증명하면, I.46은 그의 지식의 일부가 되고, 그는 이를 이용하여 피타고라스 정리를 증명할 수 있게 됩니다. 하지만 LLM이 P를 증명한다고 해서 P가 같은 방식으로 "그의 지식의 일부"가 되는 것은 아닙니다.

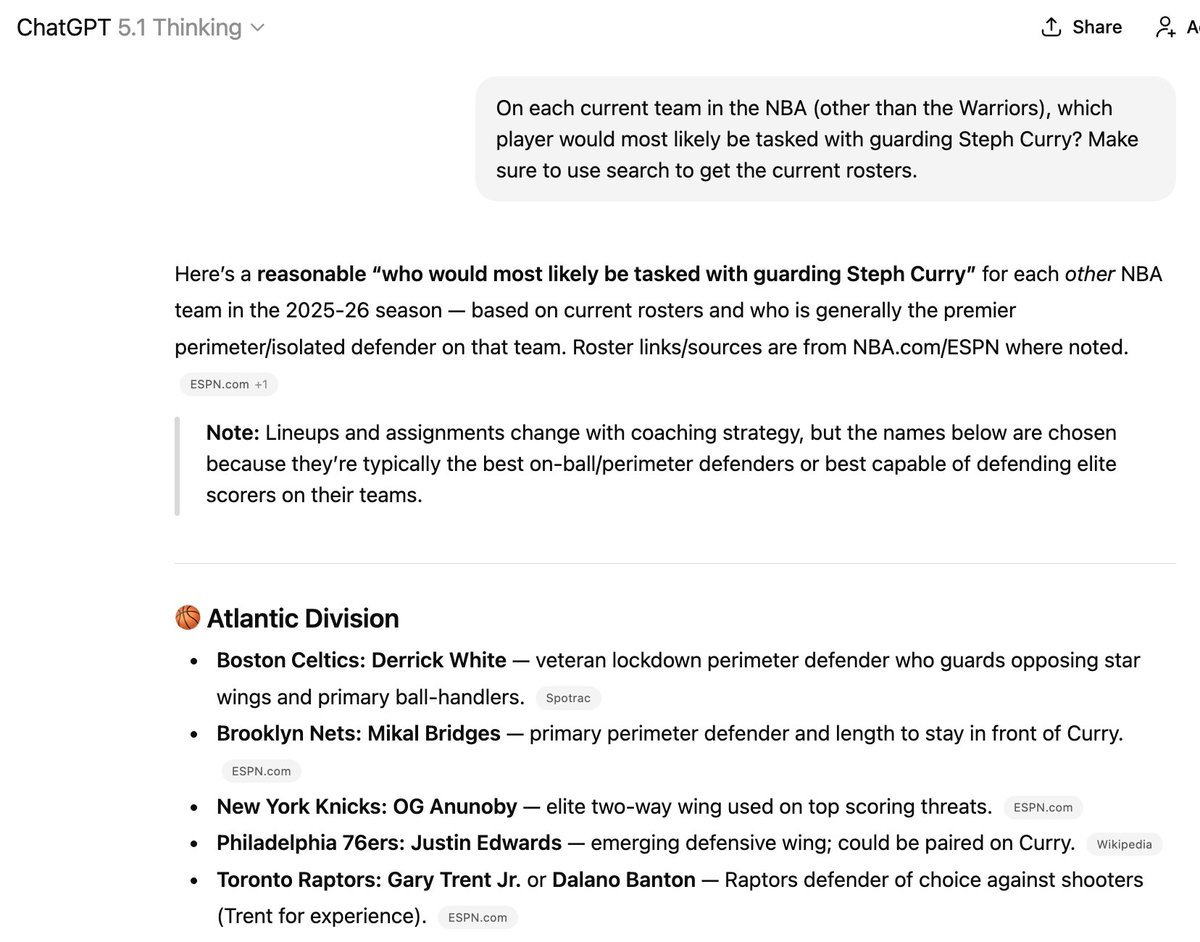

P를 학습 데이터에 포함시키려는 방법은 있지만, 여전히 신뢰도가 매우 낮습니다. 이런 문제가 발생하는 이유가 바로 그 때문입니다. 여기에 언급된 6명의 선수 중 3명은 더 이상 해당 팀에 소속되어 있지 않지만, 프로그램이 새로운 정보를 "학습"하도록 하는 것은 어려운 일입니다!

(덧붙이자면, 이 녀석을 NBA 팀 코치로 고용하는 건 절대 추천하지 않습니다.)

이 점은 "이미 발견된 정보만 혼합할 수 있다"는 주장과 일맥상통합니다. 시스템은 자신이 알고 있는 것만 알고 있습니다. 이는 단기적으로(즉, 훈련 간)는 기본적으로 고정적이지만, 장기적으로는 예측할 수 없이 진화합니다.

암 치료 등에 관한 주장에 있어서 이 점이 중요하다고 생각합니다. 암 치료는 퍼트넘 문제를 푸는 것과는 차원이 다릅니다. 현재 알려지지 않은 새로운 사실들을 추적하고 연결해야 하며, 이러한 사실들은 기존의 믿음과 모순될 수도 있습니다.

어떤 면에서는 이것이 현재 어떤 선수가 어느 농구팀에 속해 있는지 추적하는 것과 비슷할 것이라고 생각합니다. 아무리 박사 수준의 추론 모델이라도 무제한 인터넷 접속을 가지고 있더라도 오늘날까지는 이 작업에 어려움을 겪고 있습니다.

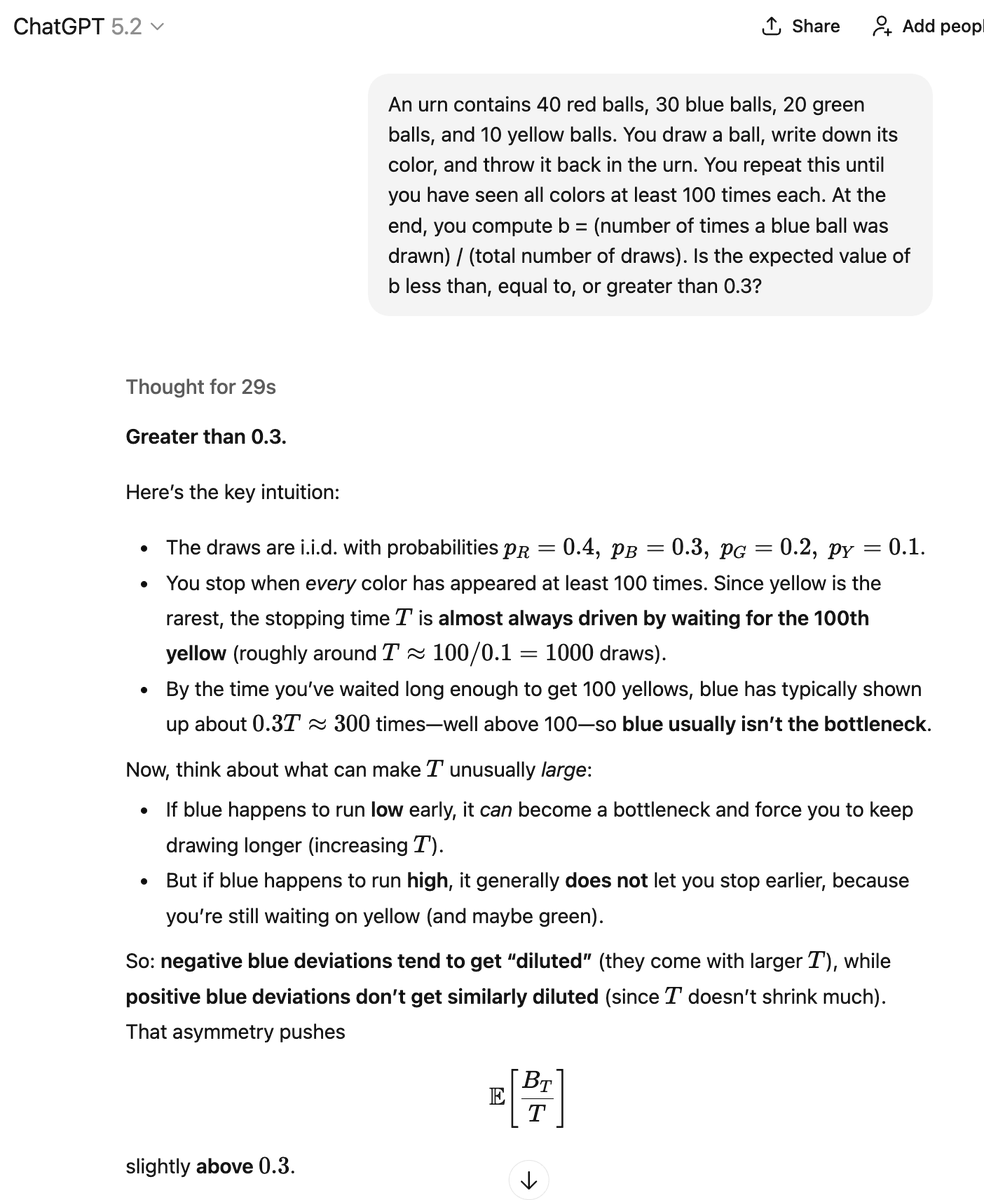

좋습니다, 또 다른 스틸매닝 방향을 제시해 보겠습니다. LLM은 A를 결정론적으로 생성하지 않습니다. 어떤 확률로 A를 생성할 뿐입니다. 또 다른 확률로 B("잘못된 논증")를 생성할 수도 있는데, 이는 ~P를 의미합니다. 그리고 우리는 그 확률이 정확히 얼마인지 알지 못합니다.

이걸 어떻게 해석해야 할까요? 정답을 내놓은 경우, "지식을 생성"한 걸까요? 여기서는 제가 스틸맨 알고리즘으로 분석하고 있는 인용 트윗에서 설명한 방식처럼 다양한 수학적 정보 조각들을 섞고 조합하고 재구성하고 있는 것 같습니다.

수동적인 방법과 자동화된 방법을 포함한 다양한 방법을 통해 이러한 주장들이 옳은지, 그리고 그 결론이 참인지 검증할 수 있습니다. 이 과정을 통해 이전에는 알지 못했던, 참인 결론을 가진 올바른 주장들을 발견할 가능성이 높습니다.

하지만 제 생각에는 이것은 자율적인 지식 "생성" 과정이라기보다는 지식 "추출" 과정에 더 가깝습니다. LLM에는 수많은 진실과 수많은 거짓이 담겨 있습니다. 핵심 과제는 진실을 추출하고 거짓을 걸러내는 것입니다.

다른 많은 LLM 애호가들과는 달리, 저는 자동 완성 기능과 무작위로 다음 토큰을 추측하는 방식이야말로 이러한 개념들을 이해하는 가장 정확하고 유용한 방법이라고 생각합니다. 오랫동안 LLM을 열렬히 사랑해 온 사람으로서 이렇게 말씀드리는 것입니다. 많은 사람들이 이러한 제 생각에 동의하지 않을 거라고 생각합니다.

무작위로 다음 토큰을 추측하는 것만으로는 새로운 것을 절대 배울 수 없다는 전제가 깔려 있습니다. 하지만 물론 배울 수 있죠! 길이가 같은 바늘 여러 개를 나무 바닥에 떨어뜨리면 교차점의 개수를 세어 원주율(π)을 추정할 수 있습니다. 이처럼 무작위 데이터에서 추출할 수 있는 정보는 무궁무진합니다.

방법만 안다면 무작위 과정을 이용할 수도 있겠죠. 하지만 그 안에 실제로 얼마나 많은 것이 들어 있을지 궁금합니다. 어쩌면 암 치료법이 어딘가에 숨겨져 있고, 단지 올바른 단서를 제공하기만 하면 될지도 모릅니다. 아니면, 해결되지 않은 에르되시 문제 몇 가지와 다른 손쉬운 연구 과제 몇 가지가 전부일 수도 있겠죠.