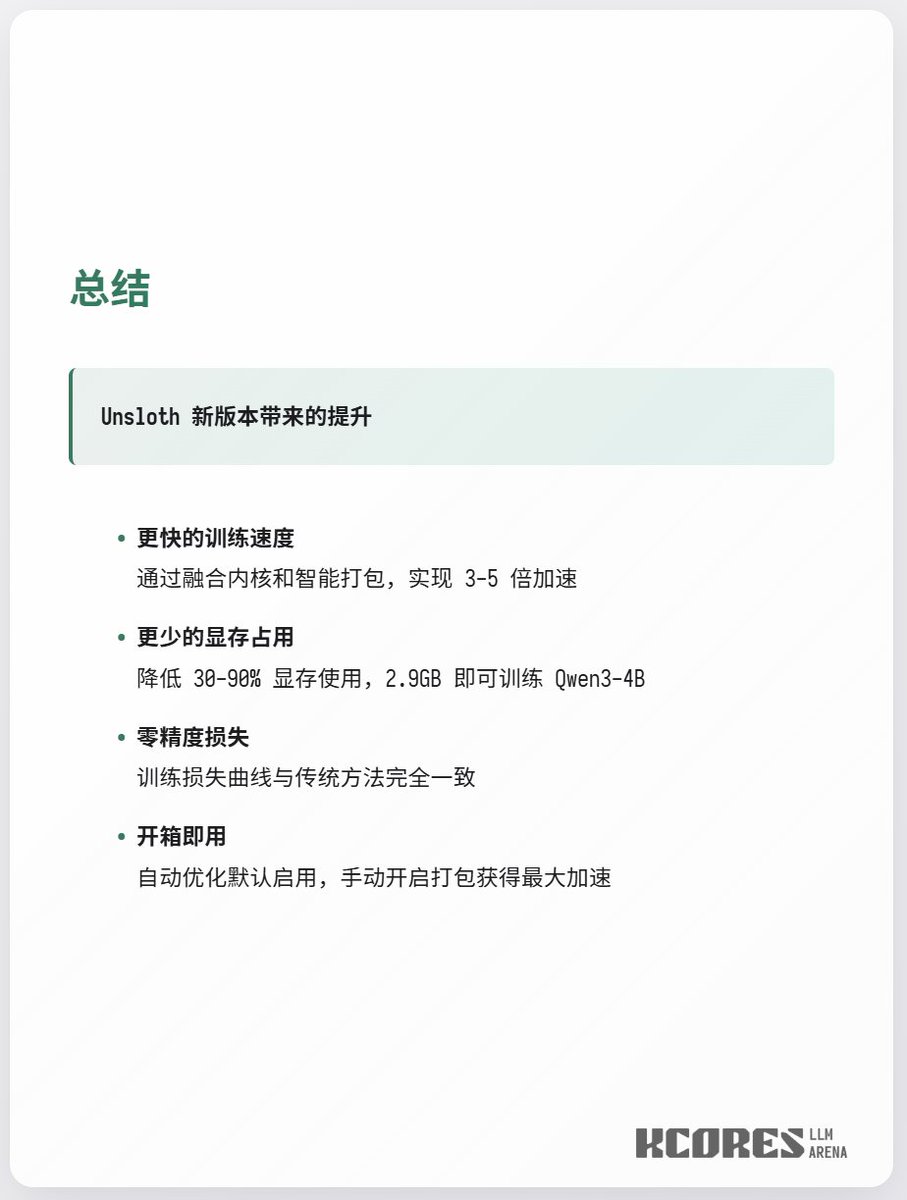

Unsloth가 또다시 3GB의 VRAM으로 Qwen3-4b를 훈련시키고 있습니다. 최근 Unsloth 업데이트는 상당한 개선을 가져왔습니다. 간단히 말해, Q와 K 연산에 필요했던 두 개의 Triton 커널이 하나로 통합되었고, 가변 길이 RoPE를 지원하게 되었습니다. 이를 통해 GPU 메모리 사용량을 크게 줄이고 계산 속도를 향상시킬 수 있습니다 (원래 Q와 K 연산에는 두 개의 Triton 커널이 필요했지만, 이제 하나로 통합되었습니다). 결과적으로 긴 컨텍스트 학습에서 2.3배의 속도 향상을 달성했습니다. 또한, 기존의 int32 인덱스는 50만 개의 매우 큰 컨텍스트를 사용하여 학습할 때 CUDA 경계 초과 오류를 발생시켰기 때문에 int64 인덱스를 지원합니다. 따라서 경계 초과 오류를 방지하고 더 큰 컨텍스트를 지원할 수 있도록 더 높은 정밀도를 사용했습니다.

구현 세부 정보 / 1

구현 세부 사항 / 2

사용 방법