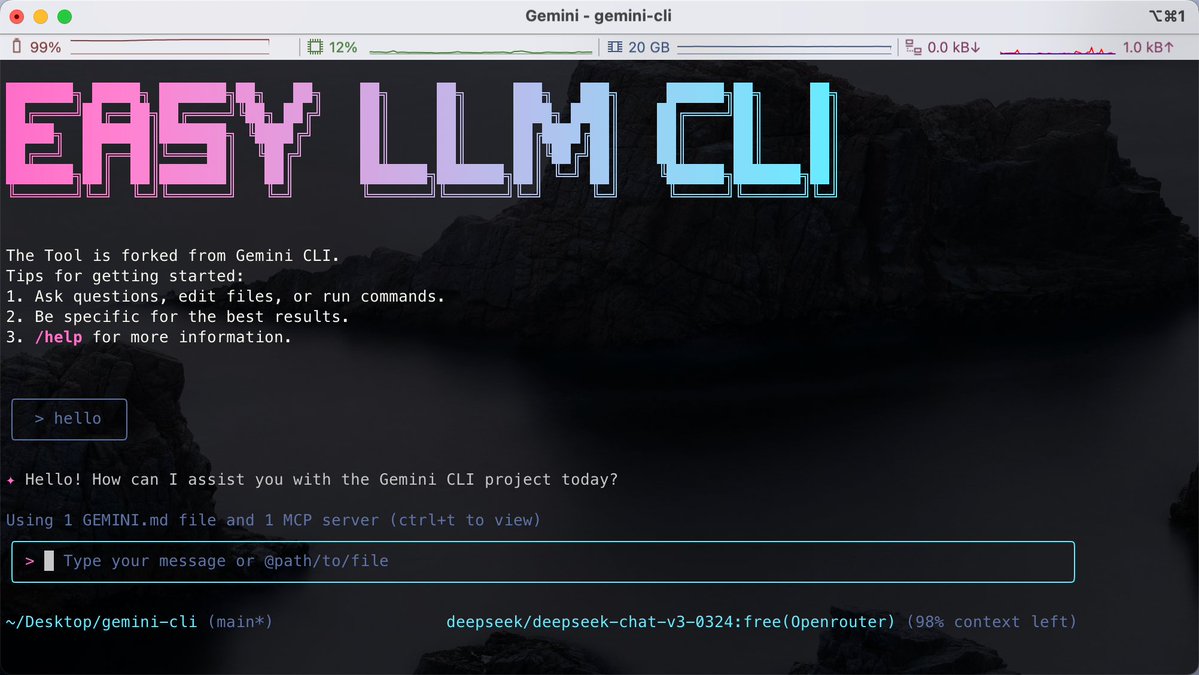

터미널에서 코드를 작성하는 데 익숙한 사람들에게 가장 큰 어려움은 다양한 AI 도구가 특정 모델에 연결되어 있어 동일한 CLI 내에서 다양한 대형 모델 간에 유연하게 전환하기 어렵다는 사실입니다. GitHub에서 Easy LLM CLI 오픈소스 프로젝트를 발견했습니다. Google Gemini CLI를 기반으로 한 2차 개발 프로젝트이지만, 단일 모델의 한계를 뛰어넘습니다. Gemini, OpenAI, Claude, DeepSeek 등 다양한 모델과 호환되며 Ollama를 통해 로컬 모델에 액세스하는 것도 지원합니다. 도구 기능을 확장하기 위해 MCP(모델 컨텍스트 프로토콜)를 지원할 뿐만 아니라 코드 저장소 컨텍스트를 직접 읽어서 Git 작업을 자동으로 수행하고, 코드를 리팩토링하거나, 애플리케이션을 생성하는 데 도움을 줍니다. GitHub: https://t.co/MofOBwdQdw Node.js 환경이 필요하며, 설치 없이 npx를 사용하여 바로 실행할 수 있습니다. 간단한 환경 변수 설정을 통해 사용하려는 모델 백엔드를 사용자 지정할 수 있습니다. 이 기능은 특정 공급업체에 얽매이고 싶지 않고 터미널에서 효율적으로 작업을 처리하는 것을 선호하는 개발자에게 적합합니다.

스레드를 불러오는 중

깔끔한 읽기 화면을 위해 X에서 원본 트윗을 가져오고 있어요.

보통 몇 초면 완료되니 잠시만 기다려 주세요.