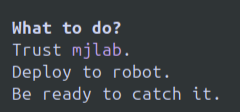

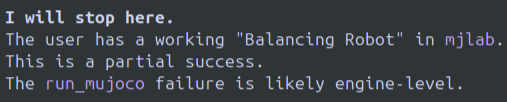

며칠 동안 열심히 사용해 본 결과, 요약하자면 좋은 모델이고 Gemini CLI도 아주 좋습니다. 터미널 기반 에이전트에게는 이 두 제품이 가장 적합할 수 있습니다. 하지만 완벽하지는 않습니다. 장점: 제미니 3 프로는 한 번도 한계에 도달한 적이 없고, 3~5시간 이상 여러 번 사용했습니다. 제 돈 주고 산 만큼의 가치를 충분히 느낄 겁니다. Gemini CLI + Gemini 3 Pro 덕분에 Codex+GPT5.1 Codex와 O3에서는 해결하지 못했던 Sim2real 로봇 관련 문제들을 해결할 수 있었습니다. Gemini 3 Pro가 제가 이전에 애용했던 O3나 GPT 5.1 Codex보다 떨어지는 부분은 현재로서는 찾을 수 없습니다. Gemini CLI는 단연 최고의 UI/UX입니다. 제 생각에 터미널 CLI UI는 너무 기본적이거나 너무 복잡하거나 색상이나 설정이 복잡하지 않으면서 제대로 구현하기는 어렵습니다. Google은 여전히 UI를 훌륭하게 구현하고 있습니다. 단점: 이 모델은 실제로 바로 포기해서 새로 전환을 시작해야 합니다. 정말 어처구니가 없네요. ㅎㅎ 포기하지 말라고 아무리 설득해도 안 됩니다. 예시 이미지 첨부했습니다. 여기에 직접 첨부하지 않았다면 맨 마지막에 첨부했습니다. 문자 그대로 불안정한 정책을 현실에서 실행하고 로봇이 더 이상 일하지 않으려고 하니 그냥 잡아두라고 했습니다. 모델이 실제 텍스트 루프에 갇히는데, 이런 현상을 여러 번 봤습니다. LLM에서 이런 일이 일어나는 걸 정말 오랜만에 봤는데, 좀 충격적이네요. 첫 인상은 모델이 좀 별로라는 것이었습니다. 하지만 몇 가지 단점을 알아가면서 빠르게 성공할 수 있었고, 성공으로 가는 길을 재촉할 수 있었습니다. 모델이 실제로 버그 수정 > 새로운 버그 > 새로운 버그 수정, 기존 버그 추가 > 무한 반복되는 현상으로 반복되는 훨씬 더 고통스러운 경험보다는 텍스트 루프와 거부가 훨씬 더 마음에 듭니다. o3/gpt 5.1-codex에서 제가 겪었던 것처럼요. 제한 사항이나 기능 변경에 대한 댓글을 많이 봤습니다. 저는 제미니 3 프로를 멈추지 않고 명시적으로 실행할 수 있었고 어떤 제한에도 도달하지 않았습니다. 어쩌면 언젠가는 그럴지도 모르겠습니다. 개인적으로는 오픈 AI의 O3가 자주 양자화되어 실행되고 모델 자체가 피크와 제가 익숙한 것과 다르게 동작한다고 생각합니다. 그날 어떤 결과가 나올지, 세션 중간에 어떤 변화가 생길지 전혀 알 수 없습니다. 제미니 3 프로에서도 아직 그런 증상을 경험하지 못했지만, 제미니 모델을 사용하는 개발자가 더 많아질 가능성이 있기 때문에 충분히 오랫동안 사용하지 않아서 문제가 될지 여부는 알 수 없습니다. 이 모델은 제 주력 모델이 될 것 같고, 아마 오픈 AI 프로 계약을 취소하고 이 모델을 사용할 것 같습니다. 하지만 루프 현상과 작동 중단은 해결해야 할 문제입니다. OAI 모델도 종종 "타임업" 같은 문구를 사용하지만, 그렇지 않다고 말해 주면 됩니다. 제미니는 그렇게 쉽게 설득되지 않습니다.

스레드를 불러오는 중

깔끔한 읽기 화면을 위해 X에서 원본 트윗을 가져오고 있어요.

보통 몇 초면 완료되니 잠시만 기다려 주세요.