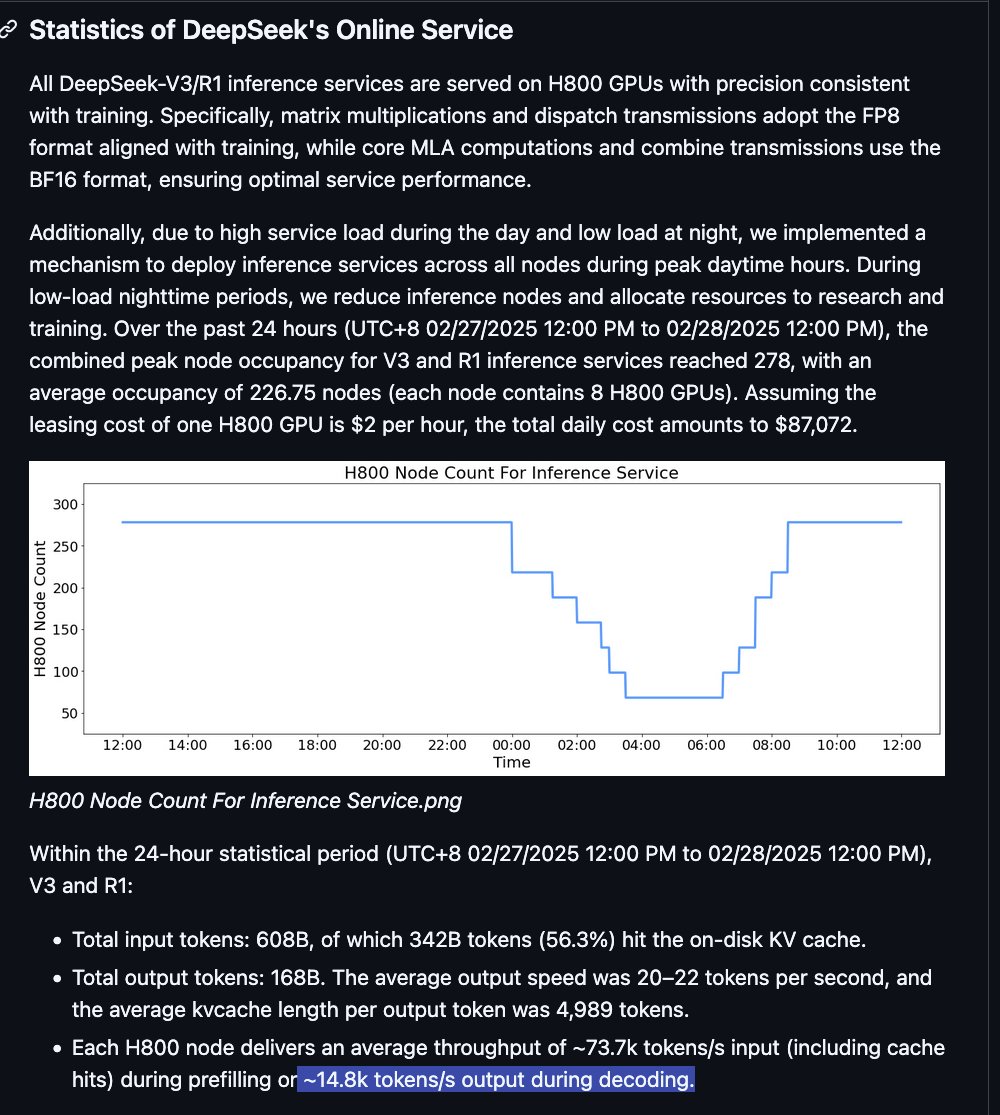

이 두 문제는 같은 문제입니다. DeepSeek은 평균 배치 크기가 약 90인 V3를 제공했습니다. Kimi-Turbo처럼 V3.2를 훨씬 더 빠르게 제공할 수 있었을 겁니다. 다만 비용이 조금 더 들겠죠. 시간도 돈이기 때문에, 이 방식이 DeepSeek의 경쟁력을 *더* 높일 수 있을 것 같습니다. 그래도 OpenAI보다 훨씬 저렴할 테니까요.

하지만 그들은 원하지 않습니다. 사실 그들은 API 호스팅과 수익화에 별로 관심이 없습니다. 그것은 그들이 해야 할 일이 아니라고 생각합니다.