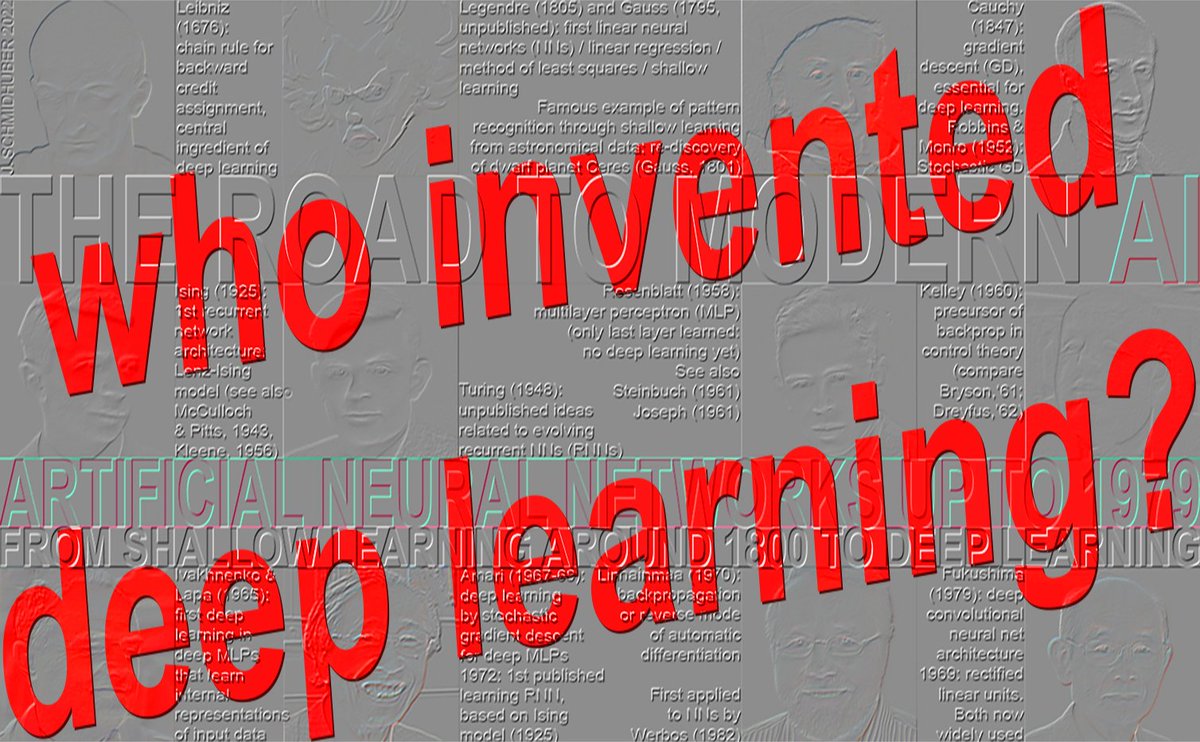

딥 러닝을 발명한 사람은 누구인가요? https:/people.idsia.ch/~juergen/who-i… 1965년: 최초의 딥러닝(Ivakhnenko & Lapa, 1971년까지 8개 계층) 1967-68: 확률적 경사 하강법을 이용한 엔드투엔드 딥 러닝(Amari, 5개 레이어) 1970: NN에 대한 역전파(Linnainmaa, 1970)(Werbos, 1982): 5개 이상의 레이어가 거의 없음(1980년대) 1991-93: 심층 NN을 위한 비지도 사전 학습(Schmidhuber 등, 100개 이상의 레이어) 1991-2015: 심층 잔여 학습(Hochreiter 등, 100개 이상의 레이어) 1996-: 그래디언트 없는 딥러닝(100개 이상의 레이어) ★ 1965년: 최초의 딥러닝(Ivakhnenko & Lapa, 1971년까지 8개 계층) 딥 피드포워드 네트워크 아키텍처에서 성공적인 학습은 1965년 우크라이나(당시 소련)에서 시작되었는데, 당시 알렉세이 이바크넨코와 발렌틴 라파가 여러 개의 은닉층(현재 인기 있는 곱셈 게이트를 이미 포함)을 가진 딥 다층 퍼셉트론(MLP) 또는 피드포워드 NN(FNN)을 위한 최초의 일반적인 작동 학습 알고리즘을 도입했습니다.[DEEP1-2][DL1-2][DLH][WHO5]. 1971년 논문[DEEP2]에서는 8개 층으로 구성된 딥 러닝 네트워크를 설명했는데, 이는 새로운 천년기에도 여전히 인기가 있었던 그들의 인용 빈도가 높은 방법을 통해 학습되었습니다[DL2]. 입력 벡터와 그에 대응하는 목표 출력 벡터로 구성된 학습 세트가 주어지면, 각 계층은 점진적으로 성장하고 회귀 분석을 통해 학습됩니다. 미세 조정 단계에서는 별도의 검증 세트[DEEP2][DLH]를 사용하여 정규화를 통해 불필요한 은닉 유닛을 제거합니다. 이를 통해 신경망을 단순화하고 보이지 않는 테스트 데이터에 대한 일반화를 향상시킵니다. 계층의 개수와 계층당 유닛의 개수는 문제에 따라 학습됩니다. 이는 원래의 2계층 가우스-르장드르 신경망(1795-1805)[DLH]을 강력하게 일반화한 것입니다. 즉, 이바크넨코와 동료들은 1980년대에 "연결주의"라는 용어가 널리 알려지기 20년 전부터 적응형 은닉층에 연결주의를 적용했습니다. 이후의 심층 신경망처럼, 그의 신경망은 입력 데이터에 대한 계층적이고 분산된 내부 표현을 생성하는 법을 학습했습니다. 그는 이를 심층 학습 신경망이라고 부르지는 않았지만, 실제로는 심층 학습 신경망이었습니다. 이바크넨코의 선구적인 연구는 튜링상을 수상한 연구자들에 의해 반복적으로 표절되었습니다[DLP][NOB]. 예를 들어, 이바크넨코의 1971년 계층별 학습[DEEP2]의 심도는 35년 후 발표된 힌튼과 벤지오의 2006년 계층별 학습[UN4][UN5]의 심도와 유사했지만, 원래 연구[NOB]와는 비교도 되지 않았습니다. 당시에는 컴퓨팅 비용이 수백만 배 더 비쌌습니다. 마찬가지로, 르쿤 외 연구[LEC89]는 이바크넨코의 심층 신경망 가지치기에 대한 원래 연구를 언급하지 않고 신경망 가지치기 기법을 발표했습니다. 심지어 훨씬 나중에 발표된 딥러닝 "조사"[DL3][DL3a]에서도 수상자들은 딥러닝의 기원을 언급하지 않았습니다[DLP][NOB]. Ivakhnenko와 Lapa는 또한 생물학적으로 불가능한 역방향 패스를 사용하지 않고도 지역적으로 이용 가능한 정보만을 사용하여 은닉 단위에 대한 적절한 가중치를 학습할 수 있음을 보였습니다[BP4]. 60년 후, Hinton은 이 업적을 자신의 업적으로 돌렸습니다[NOB25a]. 이바크넨코의 신경망은 딥러닝이 없는 더 이전의 다층 피드포워드 신경망과 어떻게 비교됩니까? 1958년 프랭크 로젠블랫은 다층 퍼셉트론(MLP)을 연구했습니다[R58]. 그의 MLP는 무작위 가중치를 갖는 비학습형 첫 번째 층과 적응형 출력 층을 가지고 있었습니다. 이는 마지막 층만 학습했기 때문에 아직 딥러닝이 아니었습니다[DL1]. MLP는 1961년 칼 슈타인부흐[ST61-95]와 로저 데이비드 조셉[R61]에 의해서도 논의되었습니다. 올리버 셀프리지의 다층 판데모니엄[SE59](1959)도 참조하십시오. 1962년, 로젠블랫 등은 조셉이 1961년에 은닉 유닛을 학습시키는 것에 대한 예비 아이디어[R61]를 바탕으로 은닉층을 가진 MLP의 "역전파 오류"[R62]에 대해 기술하기도 했습니다. 하지만 조셉과 로젠블랫은 딥러닝 MLP를 위한 실제 딥러닝 알고리즘을 개발하지 못했습니다. 현재 역전파라고 불리는 것은 상당히 다르며 1970년에 Seppo Linnainmaa가 처음 발표했습니다[BP1-4]. 1960년대 중반 소련에서 딥 러닝이 등장한 이유는 무엇일까요? 당시 소련은 여러 주요 과학 기술 분야를 선도하고 있었는데, 특히 우주 분야에서 두드러졌습니다. 최초의 인공위성(1957년), 최초의 인공위성 천체(1959년), 최초의 우주인(1961년), 최초의 여성 우주인(1962년), 최초의 로봇 천체 착륙(1965년), 최초의 로봇 외계 행성 착륙(1970년) 등이 그 예입니다. 또한 소련은 세계 최대 규모의 폭탄(1961년)을 터뜨렸고, 수많은 저명한 수학자들을 배출했으며, 수십 년 후에야 그 중요성을 드러낼 블루 스카이 수학 연구에 충분한 자금을 지원했습니다. 위에 언급된 다른 섹션(1967년, 1970년, 1991-93년, 1991-2015년, 1996년)은 [WHO5]: 누가 딥러닝을 발명했을까? 기술 노트 IDSIA-16-25, IDSIA, 2025년 11월에서 다루고 있습니다. 선택된 참고문헌([WHO5]에 추가 참고문헌이 많음 - 위 링크 참조): [BP1] S. Linnainmaa. 알고리즘의 누적 반올림 오차를 국소 반올림 오차의 테일러 전개로 표현. 석사 논문(핀란드어), 헬싱키 대학교, 1970. 6-7장과 58-60쪽의 FORTRAN 코드를 참조하십시오. 또한 BIT 16, 146-160, 1976을 참조하십시오. 링크. 자동 미분의 역모드라고도 하는 "현대" 역전파에 관한 최초의 논문. [BP4] J. Schmidhuber (2014). 역전파 알고리즘을 발명한 사람은 누구입니까? [BPA] HJ Kelley. 최적 비행 경로의 경사 이론. ARS 저널, 제30권, 제10호, 947-954쪽, 1960. 현대 역전파의 선구자 [BP1-4]. [DEEP1] Ivakhnenko, AG 및 Lapa, VG (1965). 사이버네틱 예측 장치. CCM Information Corporation. 여러 계층을 가진 최초의 딥러닝 학습기로 내부 표현을 학습함. [DEEP1a] 이바크넨코, 알렉세이 그리고레비치. 데이터 처리의 군집법; 확률적 근사법의 경쟁자. 소련 자동 제어 13(1968): 43-55. [DEEP2] Ivakhnenko, AG (1971). 복잡계의 다항식 이론. IEEE 시스템, 인간 및 사이버네틱스 저널, (4):364-378. [DL1] J. Schmidhuber, 2015. 신경망에서의 딥러닝: 개요. Neural Networks, 61, 85-117. 1988년 창간된 Neural Networks 저널에서 최초로 최우수 논문상을 수상했습니다. [DL2] J. Schmidhuber, 2015. 딥러닝. Scholarpedia, 10(11):32832. [DL3] Y. LeCun, Y. Bengio, G. Hinton (2015). 딥러닝. Nature 521, 436-444. 딥러닝의 선구적 연구들을 언급하지 않는 딥러닝 "개요" [DLP][NOB]. [DL3a] Y. Bengio, Y. LeCun, G. Hinton (2021). 튜링 강연: AI를 위한 딥러닝. ACM 커뮤니케이션, 2021년 7월. 딥러닝의 선구적인 업적을 언급하지 않는 또 다른 딥러닝 "조사" [DLP][NOB]. [DLH] J. Schmidhuber. 현대 AI 및 딥러닝의 주석이 달린 역사. 기술 보고서 IDSIA-22-22, IDSIA, 스위스 루가노, 2022. 사전 인쇄본 arXiv:2212.11279. [DLP] J. Schmidhuber. 튜링상 수상자 3명이 개발자의 공로를 인정하지 않은 주요 방법과 아이디어를 어떻게 재발행했는지. 기술 보고서 IDSIA-23-23, 스위스 AI 연구소 IDSIA, 2023. [GD'] C. Lemarechal. 코시와 기울기 방법. Doc Math Extra, 251-254쪽, 2012. [GD''] J. 하다마르. Memoire sur le Probleme d'analyse는 Vequlibre des Plaques Elastiques Encastrees와 관련되어 있습니다. 회고록은 1908년 33일 프랑스 과학 연구소(Academie des Sciences de l'Institut de France)에서 파 다이버 사반트 이방인을 제시합니다. [GDa] YZ Tsypkin (1966). 적응, 훈련 및 자기 조직화 자동 제어 시스템, Avtomatika I Telemekhanika, 27, 23-61. 비선형 시스템을 위한 경사 하강법 기반 온라인 학습에 관하여. [GDb] YZ Tsypkin (1971). 자동 시스템에서의 적응과 학습, Academic Press, 1971. 비선형 시스템을 위한 경사 하강 기반 온라인 학습에 관하여. [GD1] SI Amari (1967). 적응 패턴 분류기 이론, IEEE Trans, EC-16, 279-307 (일본어판은 1965년 출판). 다층 신경망 학습을 위해 확률적 경사 하강법[STO51-52]을 사용한 최초의 논문으로 추정된다(현재 자동 미분의 역모드 또는 역전파법[BP1]으로 알려진 특정 경사 하강법을 명시하지 않음). [GD2] SI Amari (1968). 정보 이론 - 정보의 기하학적 이론, 쿄리츠 출판, 1968 (일본어, 119-120쪽 참조). 비선형적으로 분리 가능한 패턴 클래스를 분류하기 위해 내부 표현을 학습하는 5층 네트워크(2개의 수정 가능한 계층 포함)에 대한 컴퓨터 시뮬레이션 결과를 담고 있습니다. [GD2a] S. Saito (1967). 일본 규슈대학교 대학원 공학연구과 석사 학위 논문. 다층 퍼셉트론을 위한 Amari의 1967년 확률적 경사하강법 구현 [GD1]. (S. Amari, 개인 서신, 2021.) [NOB] J. Schmidhuber. 표절에 대한 노벨상. 기술 보고서 IDSIA-24-24(2024년 12월 7일, 2025년 10월 업데이트). [NOB25a] G. Hinton. 노벨 강연: 볼츠만 머신. Rev. Mod. Phys. 97, 030502, 2025년 8월 25일. 이 강연에서 제기된 여러 문제점 중 하나는 다음과 같습니다. "볼츠만 머신은 더 이상 사용되지 않지만 역사적으로 중요한 의미를 지녔습니다. [...] 1980년대에 볼츠만 머신은 생물학적으로 불가능한 역방향 패스 없이도 국소적으로 이용 가능한 정보만을 사용하여 은닉 뉴런에 적합한 가중치를 학습할 수 있음을 보여주었습니다." Hinton은 또한 20년 전인 1960년대에 이를 입증한 Ivakhnenko의 사례를 언급하지 않았습니다. [DEEP1-2] [WHO5] J. Schmidhuber (AI 블로그, 2025). 딥러닝을 발명한 사람은 누구인가? 기술 노트 IDSIA-16-25, IDSIA, 2025년 11월. 위 링크 참조.

스레드를 불러오는 중

깔끔한 읽기 화면을 위해 X에서 원본 트윗을 가져오고 있어요.

보통 몇 초면 완료되니 잠시만 기다려 주세요.