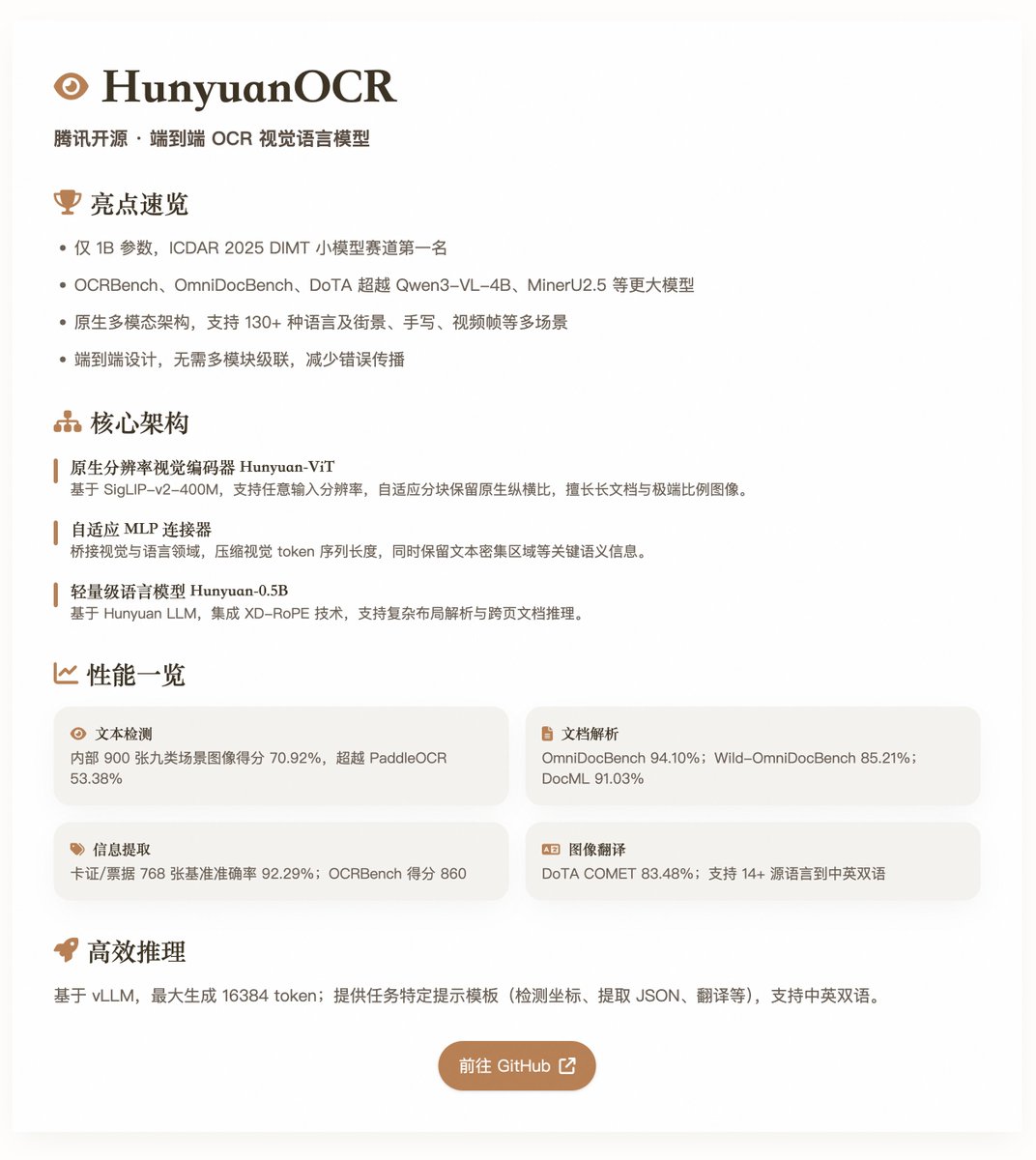

HunyuanOCR: Tencent의 오픈소스 엔드투엔드 OCR 시각 언어 모델 매개변수 크기가 1B에 불과한 HunyuanOCR은 여러 OCR 벤치마크 테스트에서 최고 성능을 달성했습니다. 네이티브 멀티모달 아키텍처를 기반으로 OCR 작업에 최적화되어 있으며, 텍스트 감지, 문서 구문 분석, 정보 추출, 시각적 질의응답, 텍스트-이미지 변환 등의 시나리오에 적합합니다. 이 모델은 ICDAR 2025 DIMT 챌린지(소규모 모델 트랙)에서 1위를 차지했으며, OCRbench, OmniDocBench, DoTA 등의 벤치마크에서 Qwen3-VL-4B 및 MinerU2.5와 같은 여러 대규모 모델을 능가했습니다. 핵심 기능 및 아키텍처 HunyuanOCR은 순수한 엔드 투 엔드 시각적 언어 모델 설계를 채택하여 기존 OCR 시스템의 다중 모듈화 문제를 해결하고 오류 확산 및 유지 관리 비용을 절감합니다. HunyuanOCR의 아키텍처는 세 가지 주요 구성 요소로 구성됩니다. • 네이티브 해상도 비주얼 인코더(Hunyuan-ViT): 약 0.4B 개의 매개변수를 갖는 SigLIP-v2-400M 사전 학습 모델을 기반으로 임의의 입력 해상도를 지원합니다. 적응형 블록 분할 메커니즘을 통해 이미지의 원래 종횡비를 보존하며, 긴 문서, 극단적인 종횡비를 가진 이미지, 그리고 저품질 스캔 문서 처리에 탁월합니다. • 적응형 MLP 커넥터: 시각 영역과 언어 영역 간의 브리지 역할을 하며 공간적 콘텐츠 압축을 수행하고, 시각적 토큰 시퀀스의 길이를 줄이며, 고밀도 텍스트 영역과 같은 주요 의미 정보를 보존합니다. • 경량 언어 모델(Hunyuan-0.5B): 약 0.5B개의 매개변수를 갖는 Hunyuan LLM을 기반으로 XD-RoPE 기술을 통합하여 RoPE를 텍스트, 높이, 너비, 시간의 4개 하위 공간으로 분해하여 복잡한 레이아웃 구문 분석과 페이지 간 문서 추론을 지원합니다. 이 모델은 여러 작업에 걸쳐 통합 모델링을 지원하며, 추가적인 전처리 모듈 없이도 자연어 명령어(예: "이미지에서 텍스트 감지 및 인식")를 통해 인식부터 의미론까지 다양한 작업을 완료합니다. 130개 이상의 언어(저자원 언어 포함)와 다양한 시나리오(예: 스트리트 뷰, 필기, 비디오 프레임)를 지원하며, 복잡한 시나리오에서의 강건성을 향상시키기 위해 학습 과정에서 고품질 애플리케이션 기반 데이터와 강화 학습(RL) 최적화를 강조합니다. 훈련 및 데이터 구축(2분) • 사전 학습 단계: 이 단계는 총 약 4,540억 토큰으로 구성된 4단계로 구성됩니다. 여기에는 시각-언어 정렬, 다중 모드 사전 학습, 긴 컨텍스트 확장(최대 32,000 토큰), 그리고 애플리케이션 중심의 지도 학습 미세 조정이 포함됩니다. 데이터는 오픈소스 데이터셋, 합성 요소 수준 데이터, 그리고 엔드투엔드 애플리케이션 데이터를 혼합하여 총 약 2억 개의 고품질 샘플을 생성하며, 스트리트 뷰, 문서, 필기 등 9가지 시나리오를 포괄합니다. • 학습 후 단계: 온라인 강화 학습 알고리즘인 GRPO를 과제별 보상 메커니즘(규칙 기반 및 LLM-as-a-judge 등)과 결합하여 사용합니다. 이를 통해 문서 구문 분석 및 번역과 같은 까다로운 과제에서 모델의 정확도와 안정성이 크게 향상됩니다. 데이터 파이프라인은 합성과 향상에 중점을 둡니다. 즉, SynthDog 프레임워크를 확장하여 긴 다국어 문서를 생성하고 RTL 레이아웃과 복잡한 글꼴을 지원합니다. 실제 결함(흐림, 왜곡, 조명 변화 등)을 시뮬레이션하기 위한 왜곡 합성 파이프라인을 도입합니다. 또한, 다양성과 품질을 보장하기 위해 교차 작업 샘플을 재사용하는 자동화된 QA 생성 파이프라인을 도입합니다. 성능 평가 - 텍스트 감지(스포팅): 900개 이미지(9개 장면 카테고리)의 내부 벤치마크에서 70.92%의 점수를 받았으며, PaddleOCR(53.38%)과 Qwen3-VL-235B(53.62%)보다 우수한 성능을 보였습니다. • 문서 파싱: OmniDocBench에서 전체 점수 94.10%, 텍스트 편집 거리 0.042; Wild-OmniDocBench(사실적인 장면 캡처) 점수 85.21%; DocML(다국어) 점수 91.03%. • 정보 추출 및 VQA: 768개 카드/티켓 벤치마크에서 92.29% 정확도; 비디오 캡션 추출 92.87%; OCR 벤치 점수 860점. • 텍스트 및 이미지 번역: DoTA에서 83.48%의 COMET 점수와 DocML에서 73.38%(기타 언어에서 영어로)/73.62%(기타 언어에서 중국어로)의 COMET 점수를 기록하며 14개 이상의 원본 언어를 중국어/영어로 번역할 수 있습니다. 이러한 결과는 특히 모듈형 VLM과 기존 파이프라인보다 성능이 뛰어난 실제 시나리오에서 모델의 경량 수준에서의 효율성을 강조합니다. @vllm_project는 효율적인 추론을 지원하여 최대 16,384개의 토큰을 생성합니다. 이 보고서는 좌표 감지, JSON 추출, 번역 등 작업별 힌트 템플릿을 제공하며, 중국어와 영어를 모두 지원합니다. 오픈소스 모델:

스레드를 불러오는 중

깔끔한 읽기 화면을 위해 X에서 원본 트윗을 가져오고 있어요.

보통 몇 초면 완료되니 잠시만 기다려 주세요.