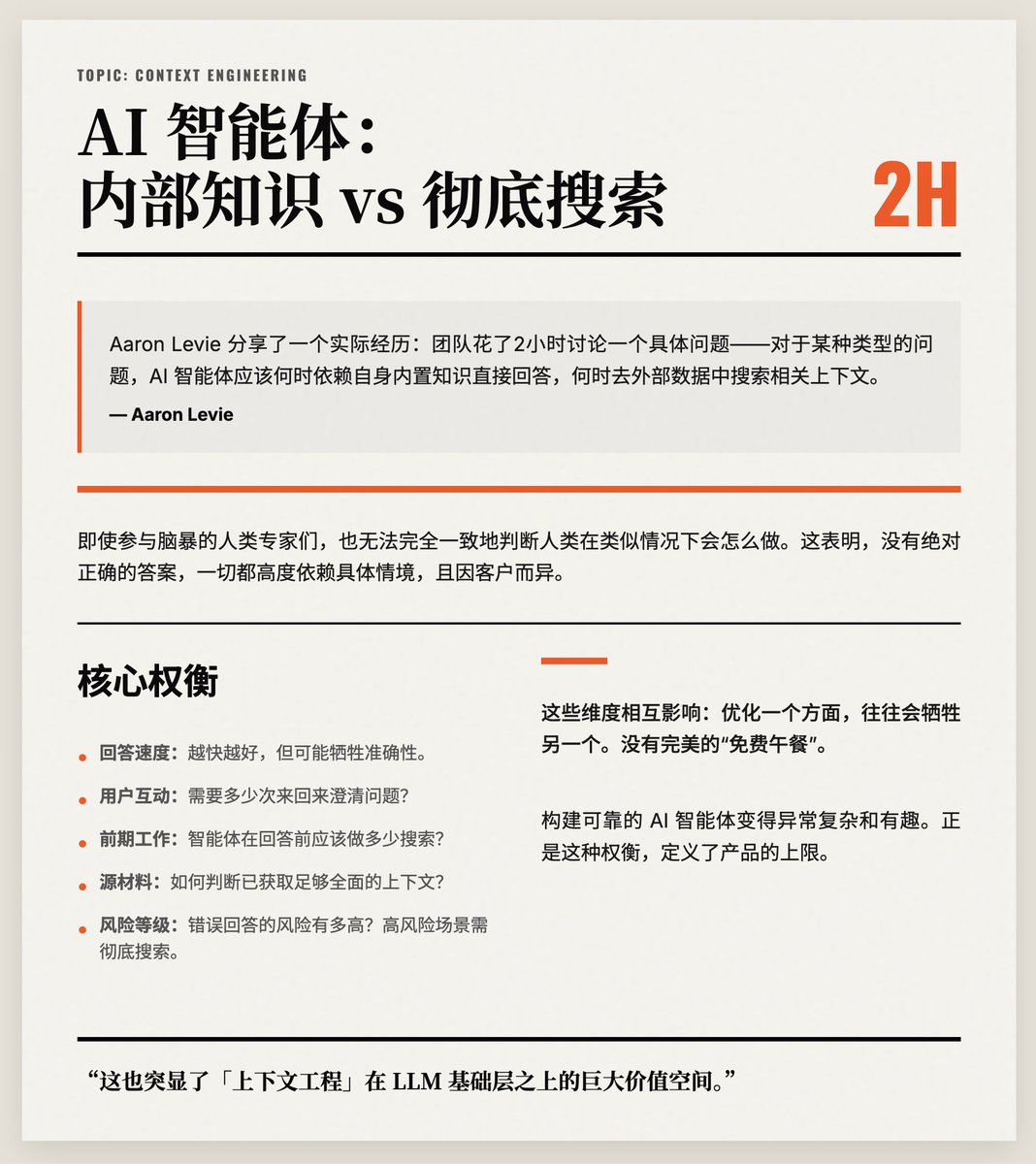

2つのケースについて2時間にわたり議論しました。AIエージェントは内部知識に頼るべきか、それとも徹底的な探索を行うべきか? 標準的な答えはありません。だからこそ、「コンテキストエンジニアリング」こそがAIモデルの最も価値あるレイヤーとなり得るのです。 アーロン・レヴィ氏は実例を挙げて説明しました。彼のチームは、AIエージェントが特定の質問に答えるために、いつ内蔵の知識に頼るべきか、そしていつ外部データから関連するコンテキストを探すべきかという、ある特定の問題について2時間かけて議論しました。数百のテストケースのうち、議論したのはたった2つだけでした。ブレインストーミングに参加した人間の専門家でさえ、同様の状況で人間がどのように行動するかについて意見が一致しませんでした。これは、絶対的に正しい答えは存在しないことを示しています。すべては状況に大きく依存し、クライアントごとに異なるのです。 レヴィの核心的な主張は、コンテキストエンジニアリングは本質的にトレードオフに満ちているというものです。コンテキストエンジニアリングでは、以下のような複数の側面を同時に考慮する必要があります。 • エージェントの応答速度(速いほど良いですが、精度が犠牲になる可能性があります)。 質問を明確にするためにユーザーはどの程度のやり取りが必要ですか? • エージェントは応答する前にどの程度の予備作業(データの検索など)を行う必要がありますか? 十分に包括的なソース資料が取得されたかどうかを判断する方法。 • 誤った回答のリスクはどの程度か(リスクの高いシナリオでは、徹底的な検索が推奨されます)。 これらの側面は相互に関連しており、ある側面を最適化すると、しばしば別の側面が犠牲になります。完璧な「タダ飯」は存在しません。そのため、信頼性の高いAIエージェントの構築は非常に複雑かつ興味深いものとなっています。 最後に、彼はこれがLLM基盤の上に築かれる「コンテクストエンジニアリング」の大きな価値を浮き彫りにするものでもあると強調しました。こうしたトレードオフを適切に処理することが、製品の中核価値とユーザーエクスペリエンスに直接的に影響を及ぼします。

スレッドを読み込み中

X から元のツイートを取得し、読みやすいビューを準備しています。

通常は数秒で完了しますので、お待ちください。