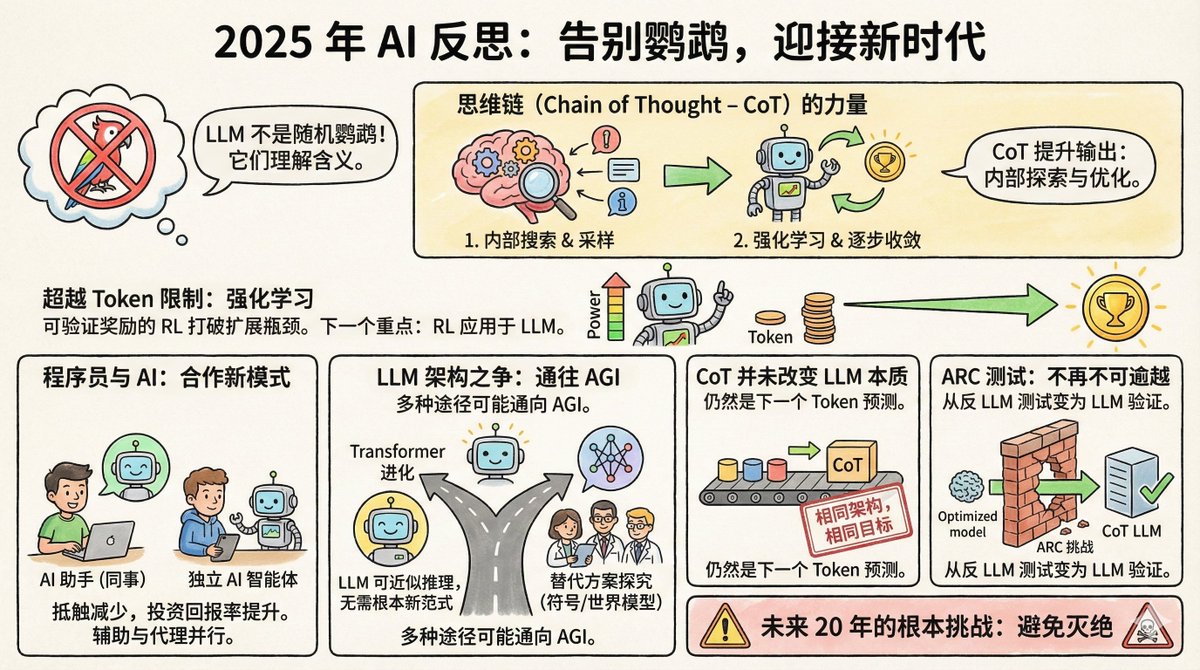

Redis の開発者 Salvatore Sanfilippo 氏は最近、AI に関する年末の考察を発表し、8 つの重要なポイントを概説しました。 まず、背景を説明します。サルヴァトーレはAI分野ではなく、プログラミング界のレジェンドです。2009年にRedisを開発しました。Redisは現在、世界で最も人気のあるキャッシュシステムの一つとなっています。2020年に自身のプロジェクトに専念するため、Redisを退職しました。2024年末にRedisに復帰し、AIツールのヘビーユーザーとなりました。クロードは彼のコーディングパートナーです。 このアイデンティティは非常に興味深いものです。彼は技術の専門家であると同時に AI の一般ユーザーでもあり、純粋な AI 研究者よりも現実的な視点を持っています。 まず、ランダムなオウムについての主張はついに信じられなくなっています。 2021年、Googleの研究者ティムニット・ゲブル氏らは、大規模言語モデルを「ランダムオウム」と名付けた論文を発表しました。これは、これらのモデルが質問の意味や、質問者が何を言っているかを理解することなく、単に確率的に単語をつなぎ合わせていることを意味します。 この比喩は鮮明で、広く使われています。しかしサルヴァトーレ氏によると、2025年までにはほとんど誰もこの比喩を使うことはなくなるでしょう。 なぜでしょうか?それは証拠が多すぎるからです。LLMモデルは、司法試験、医学試験、数学コンテストにおいて、大多数の人間よりも優れた成績を収めています。さらに重要なのは、研究者たちがこれらのモデルをリバースエンジニアリングした結果、単なる単語のコラージュではなく、概念の内部表現が実際に含まれていることを発見したことです。 ジェフリー・ヒントンは率直にこう言いました。「次の単語を正確に予測するには、文を理解しなければならない。理解は予測の代替ではなく、正確な予測を行うための必要条件である。」 もちろん、LLMがそれを本当に理解しているかどうかは哲学的な議論です。しかし、現実的には、その議論は終わりました。 II. マインドチェーンは過小評価されている画期的な発明 思考プロセスチェーンとは、モデルに答える前に思考プロセスを書き留めてもらうことです。一見シンプルに見えますが、その根底にあるメカニズムは非常に奥深いものです。 サルヴァトーレは、それが2つのことをもたらしたと考えています。 まず、モデルが回答する前に内部表現をサンプリングできるようにします。簡単に言えば、質問の文脈に関連する概念や情報を取得し、それに基づいて回答します。これは、誰かが事前に試験の概要をメモ用紙に書き出すようなものです。 第二に、強化学習を組み込むことで、モデルは思考を段階的に正しい答えへと導く方法を学習します。各トークンの出力はモデルの状態を変化させ、強化学習はモデルが正しい答えへと収束する経路を見つけるのに役立ちます。 不思議なことではありませんが、その効果は驚くべきものです。 3つ目は、コンピューティング能力の拡張のボトルネックが解消されたことです。 AIコミュニティではかつて、モデル能力の向上はトレーニングデータの量に依存するが、人間が生成するテキストの量には限りがあるため、拡張は最終的に壁にぶつかるというコンセンサスがありました。 しかし今では、検証可能な報酬を提供する強化学習によって状況は変わりました。 検証可能な報酬とは何でしょうか?プログラム速度の最適化や数学定理の証明といったタスクでは、モデル自体が結果の品質を判断できます。より高速なプログラムが優れており、正しい証明は正しいため、人間による注釈は必要ありません。 これは、モデルがこれらの種類のタスクにおいて継続的に自己改善し、ほぼ無限の量のトレーニング信号を生成できることを意味します。サルヴァトーレ氏は、これがAIにおける次の大きなブレークスルーの方向性になると考えています。 AlphaGoの37手目を覚えていますか?当時は誰も理解できませんでしたが、後に神の御業であることが証明されました。サルバトーレは、LLMが特定の分野で同様の道を辿る可能性があると考えています。 IV. プログラマーの態度は変化しました。 1年前、プログラマーコミュニティは2つの陣営に分かれていました。AI支援プログラミングは魔法の武器だとする意見と、単なるおもちゃだとする意見です。しかし今では、懐疑派の意見は大きく入れ替わっています。 理由は単純です。投資収益率が臨界点を超えたからです。モデルは確かに間違いを起こす可能性がありますが、それによって節約できる時間は、間違いを修正するコストをはるかに上回ります。 興味深いことに、プログラマーのAIへのアプローチは2つの陣営に分かれます。1つはLLMを「同僚」として扱い、主にWebベースの会話型インターフェースを通して利用します。サルヴァトーレ自身もこの陣営に属し、GeminiやClaudeといったWebベースのバージョンを使って、まるで知識豊富な人とチャットしているかのように共同作業を行っています。 別の学派では、LLM を「独立した自律的なコーディング インテリジェンス」とみなし、LLM が独自にコードを記述し、テストを実行し、バグを修正できるものとし、レビューは主に人間が担当すると考えています。 これら 2 つの使用法は、異なる哲学に基づいています。AI をアシスタントとして扱いますか、それとも実行者として扱いますか? V. トランスフォーマーが前進への道となるかもしれない。 著名な AI 科学者の中には、Transformer を超えるアーキテクチャの探究を始め、明示的な記号表現や世界モデルを研究するための企業を設立している人もいます。 サルヴァトーレはこの点について、オープンながらも慎重な見解を示しています。彼は、LLMは本質的に微分可能空間における離散推論の近似であり、根本的に新しいパラダイムなしにAGIを実現することは不可能ではないと考えています。さらに、AGIは様々な全く異なるアーキテクチャを通じて独立して実装することも可能です。 つまり、すべての道はローマに通じているということです。トランスフォーマーが唯一の道ではないかもしれませんが、必ずしも行き止まりというわけでもありません。 VI. マインドセットの連鎖はLLMの本質を変えるものではありません。 意見を変えた人もいます。以前はLLMは単なるオウム返しだと言っていましたが、今ではLLMに能力があることを認めています。しかし同時に、マインドチェーンはLLMの本質を根本的に変えるので、以前の批判は依然として有効だと主張しています。 サルバトーレは率直にこう言った。「彼らは嘘をついている。」 アーキテクチャは変わらず、Transformerであることに変わりありません。学習目標も変わりません。次のトークンを予測することです。CoTもトークンごとに生成されますが、これは他のコンテンツの生成と変わりません。モデルがより強力になったからといって、「何か別のものになった」と主張して、誤った判断を正当化することはできません。 かなり率直な発言ですが、論理的には正しいです。科学的な判断はメカニズムに基づくべきであり、結果が変わったからといって定義を変えるべきではありません。 この点をよく表すもう 1 つの例は、ARC テストです。 VII. ARC テストは、LLM に反対するものから LLM に賛成するものへと変化しました。 ARCは、フランソワ・ショレが2019年に開発した、抽象的推論能力を測定するためのテストです。記憶の想起や総当たり攻撃に抵抗し、真の推論力で解くことを目指して設計されています。 当時、多くの人が法学修士(LLM)はこの試験に合格するはずがないと考えていました。なぜなら、法学修士(LLM)はごく少数のサンプルから規則を一般化し、それを新しい状況に適用する能力を必要としていたからです。これはまさに、ランダムなオウムにはできない能力だったのです。 その結果は?2024年末までに、OpenAIのo3はARC-AGI-1で75.7%の精度を達成しました。2025年には、より難易度の高いARC-AGI-2でも、トップモデルは50%以上の精度を達成しました。 この逆転は実に皮肉なことです。このテストはもともとLLMの無効性を証明するために設計されたものでした。しかし皮肉なことに、LLMの有効性を証明する証拠となってしまったのです。 VIII. 今後20年間の根本的な課題 最後のポイントは、次の一文です。「今後 20 年間の AI の根本的な課題は、絶滅を回避することです。」 彼は詳細には触れず、ただその一文だけを述べた。しかし、彼が何を言っているのかはお分かりだろう。AIが真に強力になった時、「AIが大きな問題を引き起こさないようにするにはどうすればよいか」はもはやSFではなくなるだろう。 サルヴァトーレはAIの熱烈な信奉者でも懐疑論者でもありません。彼はAI技術を理解し、実際にAIを活用している人物です。彼の視点は、純粋に学問的なものでも、商業的な誇大宣伝でもなく、熟練したエンジニアとしての冷静な観察に基づいています。 彼の基本的な判断は、LLM は多くの人が認めるよりもはるかに強力であり、強化学習は新たな可能性を切り開きつつあり、これらのシステムに対する私たちの理解はまだ完全には程遠いというものです。 おそらくこれが 2025 年の AI 開発の真の姿です。機能は加速し、論争は減少していますが、不確実性は依然として非常に大きいままです。

スレッドを読み込み中

X から元のツイートを取得し、読みやすいビューを準備しています。

通常は数秒で完了しますので、お待ちください。