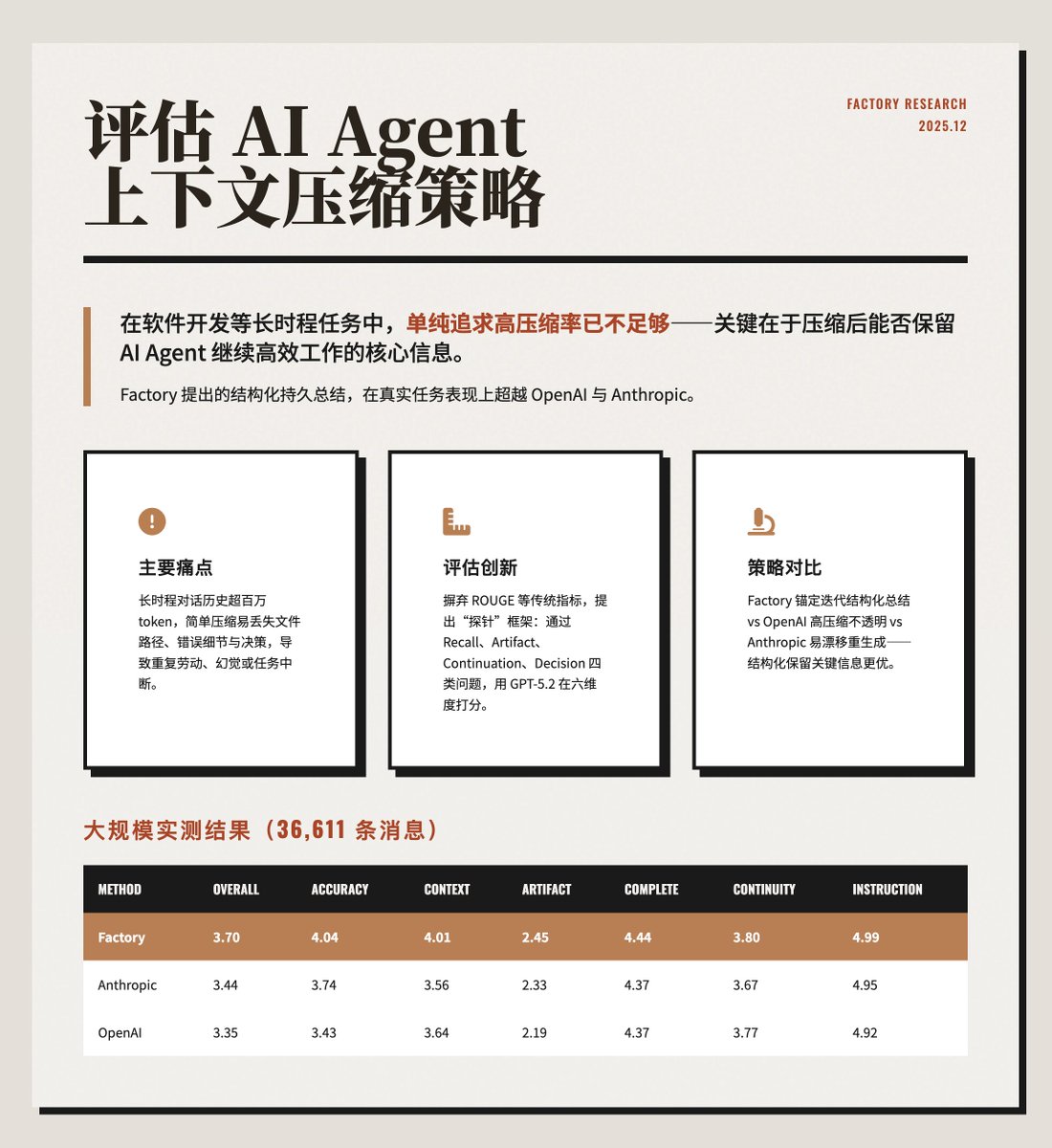

AIエージェントのコンテキスト圧縮戦略を評価する ソフトウェア開発など、継続性が求められるタスクを扱う場合、単に高いコンテキスト圧縮率を追求するだけでは不十分です。より重要なのは、AIエージェントが効果的に機能し続けるために、圧縮プロセスにおいて重要な情報を保持する必要があることです。@factory.ai/news/evaluatin…実用的なタスクにおいてOpenAIやAnthropicを凌駕する性能を発揮します。 https://t.co/ZsCDxoVO3Q 主な問題 AIエージェントを長時間実行すると、膨大な量の対話履歴(100万トークン以上)が生成され、モデルのコンテキストウィンドウの制限を超えてしまいます。単純な圧縮では、変更されたファイルパス、エラーメッセージ、過去の判断といった重要な情報が簡単に失われ、AIエージェントが反復タスクを実行したり、幻覚症状を経験したり、タスクが中断されたりする可能性があります。この記事では、「圧縮ごとのトークン削減」ではなく、「タスクごとのトークン消費」を最適化することが、効率的で継続的な運用を実現するために重要であると強調しています。 この評価方法は、テキストの類似性のみを測定し、圧縮されたコンテキストが実際のタスクの継続をサポートしているかどうかを評価できない従来の指標(ROUGEや埋め込み類似度など)を革新するものです。本論文では、プローブベースの評価フレームワークを提案します。 • 圧縮後、AIエージェントに特定の質問をして保持をテストします。 • プローブは、リコール、アーティファクト、継続、決定の 4 つのカテゴリに分類されます。 • GPT-5.2 を LLM 評価ツールとして使用し、精度、コンテキスト認識、ワークピースの追跡、整合性、継続性、指示の遵守という 6 つの側面 (0 ~ 5 ポイント) でスコアを付けます。 3つの圧縮戦略の比較:ファクトリー:アンカー型反復要約を採用し、意図、ドキュメントの変更、決定事項、次のステップを含む構造化された永続的な要約を維持します。新しいコンテンツは毎回再生成するのではなく、徐々に統合されます。 • OpenAI: `/responses/compact` インターフェースを使用して最高の圧縮率 (99.3%) を達成していますが、その要約は不透明で、ファイル パスなどのエントロピーの低いコンテンツが破棄されることが多いです。 • Anthropic: 詳細な構造化サマリー (分析、ドキュメント、タスクなどを含む) を生成しますが、圧縮されるたびに完全に再生成されるため、サマリーのドリフトが発生する可能性があります。 例と結果は、401 エラーのデバッグという具体的なケースでこれを説明しています。Factory は圧縮後にエラーの詳細と根本原因を正確に思い出しますが、OpenAI と Anthropic では技術的な詳細がいくらか失われています。 実際の運用データ (36,611 件のメッセージ) に対する大規模テストの結果を以下の画像に示します。 Factoryは精度とコンテキスト認識においてリードしています。OpenAIは最高の圧縮率を誇りますが、品質は最も低く、情報の損失により追加の検索コストが発生する可能性があります。 重要なポイント: 極端な圧縮よりも構造を重視: 明示的にセグメント化された要約の方が重要な情報をより適切に保存できます。 圧縮率だけが基準ではありません。圧縮率が高いとタスクの効率が犠牲になる可能性があり、トークンの総消費量の方が重要です。 • ワークピースの追跡は課題です。すべての方法でこの側面のスコアが低く、追加のインデックス機構が必要になります。 • プローブ評価は信頼性が高く、従来の NLP メトリックよりも実際のユーザビリティを反映します。

スレッドを読み込み中

X から元のツイートを取得し、読みやすいビューを準備しています。

通常は数秒で完了しますので、お待ちください。