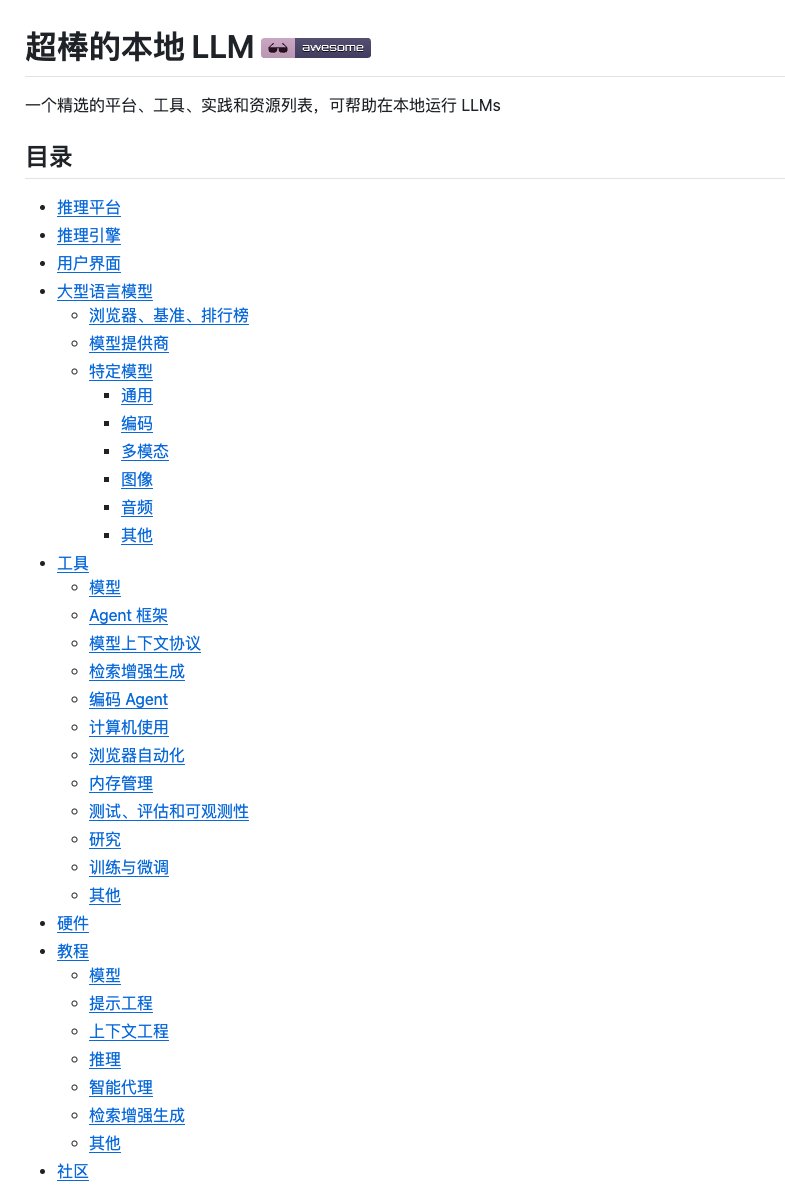

大規模なモデルをローカルにデプロイするのは、利用可能なツールやチュートリアルの数が膨大で、大変な作業になりがちです。Ollamを使ったかと思えば、vLLMを使ったり、微調整のためのフレームワークも様々です。信頼できるソリューションを見つけるのは至難の業です。 GitHubで偶然、Awesome local LLMプロジェクトを見つけました。これは、大規模モデルをローカルで実行するための「百科事典」のようなものです。包括的なだけでなく、分類ロジックも非常に明確で、テクノロジースタックを素早く理解するのに役立ちます。 推論プラットフォーム、推論エンジン、ユーザー インターフェイス、大規模言語モデル、開発ツールなど、10 を超えるカテゴリをカバーしており、ハードウェアの選択に関するアドバイスや実用的なチュートリアルも含まれています。 GitHub: https://t.co/9OJw4ll84L 各プロジェクトにはGitHubのスター数と簡単な説明が記載されているため、人気度や目的をすぐに把握できます。また、YouTubeチュートリアルやハードウェアレビューなどの学習リソースも含まれています。 ローカルで大規模なモデル環境を構築したい場合や、特定の機能を備えたオープンソース ツールを探している場合は、このコレクションを将来の参照用に保存しておく価値があります。

スレッドを読み込み中

X から元のツイートを取得し、読みやすいビューを準備しています。

通常は数秒で完了しますので、お待ちください。