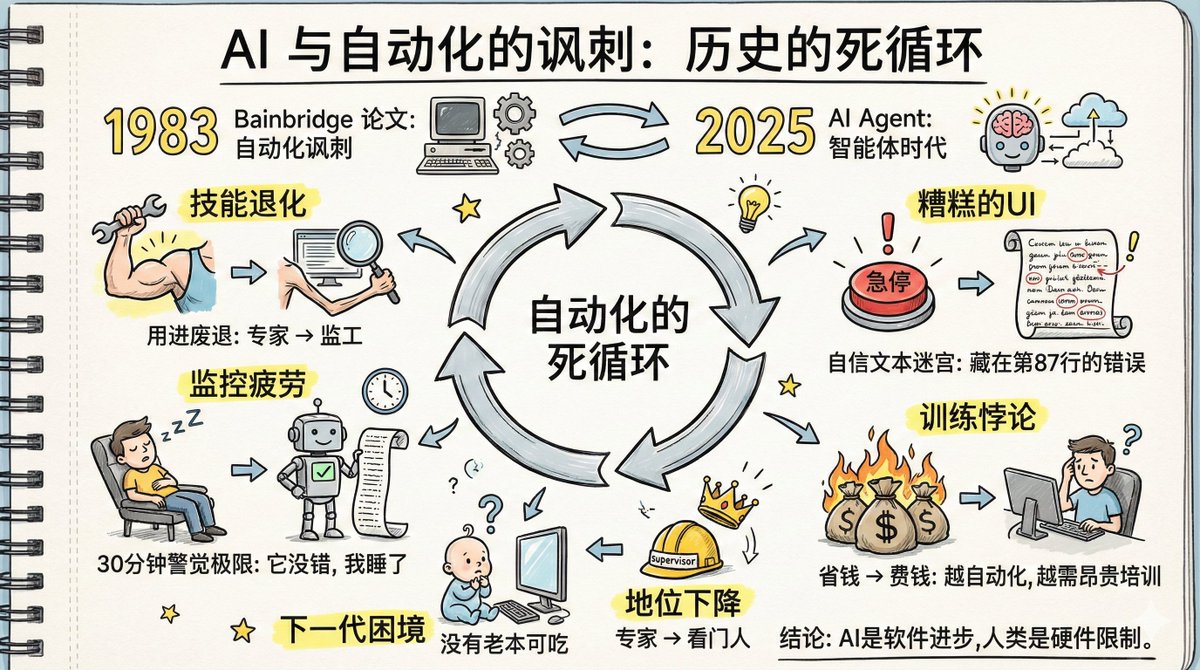

今日、「AI と自動化の皮肉」という記事を読みましたが、その内容は現在の AI の発展に非常に関連しています。 1983年、認知心理学者のリザンヌ・ベインブリッジは「自動化の皮肉」と題した論文を執筆しました。40年以上経った今、その論文で予測された問題は、AIエージェントの事例において文字通り現実のものとなっています。 当時、彼女は工場の自動化、つまり機械が作業を行い、人間が監督するという研究をしていました。 今日、私たちはAIエージェントによる自動化に直面しています。AIが作業を行い、人間が監視するのです。状況は変化しましたが、根底にあるロジックは全く同じままです。そして、彼女が論文で指摘した問題が今、再び発生しています。 論文ではどのような問題が取り上げられましたか? 1. スキル劣化のジレンマ:スキルは使われないと衰退する;専門家のスキルは管理者になると縮む 「使わなければ失う」という概念は誰もが理解しています。しかし、AI時代においては、その概念はより残酷なものとなります。 以前は、あなたは特定の分野の専門家として、毎日難なくこなしていました。しかし今、会社は「AIエージェントに任せましょう。あなたはそれを監視し、問題が発生した場合にのみ介入する責任があります」と言っています。 素晴らしいですね。従業員から管理者に昇格すれば、もっと簡単になりますよね? 問題は、これをやめてしまうと、スキルが向上しないだけでなく、むしろ低下してしまう可能性があることです。 毎日AIを使ってコードを書いている人間として、ここ2年間、あまり進歩が感じられず、AIに依存するようになってしまったと感じています。かつては難なく書けていたコードが、今ではAIなしでは書けなくなっています。 まさに「使わなければ失ってしまう」というケースです。 OpenAIとAnthropicはどちらもコーディングエージェントの威力を誇示し、従業員はAIの出力を検証するだけでよいと主張しています。しかし、これらの人材はAIの精度を判断するのに十分な経験を持つ、厳選された高度なスキルを持つ専門家であるという事実を意図的に無視しています。今後数年間、AIの作業の検証のみに注力すれば、彼らのスキルは徐々に低下していくでしょう。 私たち年配のプログラマーは大丈夫ですが、次の世代はさらに悪い状況です。 今日のベテランプログラマーは、少なくとも実務経験を通して成長してきました。では、未来のプログラマーはどうでしょうか?彼らはAIを初日から観察してきましたが、実践的な仕事はあまり経験していません。スキルも学ぶ機会も不足しています。では、AIの正しさを彼らはどのように判断するのでしょうか? 論文の原文は次の通りです。 現世代の自動化システムは、旧世代のオペレーターのスキルに依存しています。次世代のオペレーターがこれらのスキルを習得する可能性は低いでしょう。 この問題は今は明らかではないかもしれませんが、3〜5年後には明らかになる可能性があります。 2. 記憶の想起の困難: あまり使用されない知識の想起が遅くなります。 もう一つの問題は、関連するスキルの記憶も低下する可能性があることです。 高校時代に暗記した公式を思い出してみてください。今でもどれだけ覚えているでしょうか?AIが教師あり学習を行うシナリオでは、AIが強力になるにつれて、AIはほぼ正しいものになります。つまり、ほとんどの場合、あなたの知識は必要なくなります。知識が使われる機会が減るにつれて、関連する記憶は劣化していきます。 3. 実践のパラドックス:理論的な訓練は役に立たず、実践を通して学ぶ必要があります。しかし、AIが作業を行っているため、人間には実践する機会がありません。 この時点で、あなたはこう考えているかもしれません: 「このトレーニングは役に立つのか?」 しかし、「自動化の皮肉」という論文では、トレーニングはあまり役に立たないと結論付けています。 専門的なスキルは講義で習得されるものではなく、実社会での実践を通して磨かれるものです。教室で学ぶ理論は、実践的な演習がなければ理解できないことが多く、それに対応する経験的枠組みが欠如しています。たとえ最初は理解できたとしても、実社会の課題に結びついた記憶想起経路がないため、すぐに忘れてしまいます。 AIを監督する能力を維持するには、自ら定期的に業務を遂行する必要があります。しかし、企業の目標がAIの自動化による効率化である場合、実践する機会は限られてしまいます。 これは悪循環です。 論文には次のように記されている。 私たちはオペレーターに指示に従うよう訓練し、それをシステムに組み込んで情報を提供することを期待します。 普段は考えたり練習したりする必要がない人間が、重要な瞬間に良い解決策を思いつくことを期待することはできません。 4. 監視の疲労: 人間は、「めったにミスを起こさない」システムに対して長期間にわたって監視を続けることはできません。 心理学的研究によって、人間はめったに問題に遭遇しない目標に対して長時間注意力を維持することはできないことが長年明らかにされており、30分が限界です。これは意志力の問題ではなく、むしろ生理学的構造によって決まるのです。 進化論的な観点から見ると、これは実際には生存上の利点です。ある場所をじっと見つめていて何も起こらなければ、脳は自動的に警戒レベルを下げ、注意力を実際の脅威に対処するために節約します。しかし、監視のシナリオでは、これが問題になります。 AIエージェントはほとんどの場合正しいのですが、時折間違いを犯します。これはまさに監視が最も難しいパターンです。頻繁に間違いを犯す場合は注意が必要です。全く間違いを犯さない場合は監視する必要はありません。しかし、めったに間違いを犯さない状況は、まさに人間の注意の盲点に陥ります。 さらに悪いことに、AIエージェントは特に微妙な方法で間違いを犯します。「わかりません」と言う代わりに、非常に自信に満ちた口調で、数十行、あるいは数百行にわたって計画を説明します。誤りは、例えば87行目の「2は3より大きいので、…すべきだ」といった小前提に隠れているかもしれません。一見正しいように見える内容に覆われ、その自信に満ちた口調に麻痺しているため、誤りに気づくのは困難です。 自動警報システムを追加してみませんか? 論文には、「誰が警報システムを監視するのか?」と書かれています。警報システム自体に故障が発生した場合、警報システムは長期間正常に動作しているため、オペレーターは気付かないはずです。 誰かがメモを取ったらどうなりますか? 論文では、人々は数字が実際に何であるかに注意を払わずに、数字を機械的にコピーできると述べています。 監視疲労に対抗しようとするあらゆる試みは、同じ壁に突き当たる。人間の注意は、めったに問題を引き起こさない対象に長時間集中することはできないのだ。これはハードウェアの限界であり、ソフトウェアの問題ではない。 5. 地位の問題: 専門家から監督者への降格は、心理的ショックと社会的地位の低下をもたらしました。 あなたはかつて専門家でした。同僚はどんな問題でもあなたに相談し、尊敬され、強いプロフェッショナルとしてのアイデンティティを持っていました。しかし今、あなたはAIの門番です。 スキルの喪失は別問題ですが、心理的な影響は別問題です。専門家から監督者へ、クリエイターからレビュアーへ、必要とされる存在からバックアップへと降格される――こうした変化は多くの人にとって受け入れがたいものです。 論文によると、このように降格された人々は、様々な複雑な対処メカニズムを示し、中には矛盾しているように見えるものもあるという。この部分は長すぎるため、詳しくは触れない。興味のある方は原著論文をお読みください。 6. 貧弱な UI: 現在の AI エージェント インターフェースは、最悪の監視設計です。 産業オートメーション分野では、制御室の設計最適化に数十年を費やしてきました。オペレーターが異常を迅速に検知できるようにディスプレイをどのように配置するか、緊急停止ボタンがなぜ赤色なのか、なぜこれほど大きいのか、なぜその場所に設置されているのかなど、あらゆる細部が事故から得られた教訓から生まれています。 それでは、AIエージェントのインターフェースを見てみましょう。 自信たっぷりの長文、次から次へと続く多段階の計画、数十行、あるいは数百行にも及ぶ長々とした説明。その文章の中に隠された誤りを見つけ出さなければなりません。 これはおそらく人類がこれまでに設計した中で最悪の異常検出インターフェースです。 7. トレーニングのパラドックス: 自動化システムが成功すればするほど、人間をトレーニングするためにより多くの投資が必要になります。 この論文では、自動化によってもたらされるトレーニングの問題について議論しています。 オペレーターが定期的に交代して自ら作業を実施できない場合は、シミュレータによる訓練が必要です。しかし、シミュレータには根本的な問題があります。それは、予測可能な故障しかシミュレートできないということです。未知の故障はシミュレートできず、既知ではあっても未経験の故障を正確にシミュレートすることも困難です。 それで私たちは何をすべきでしょうか? トレーニングでは、具体的な対処法ではなく、一般的な戦略しかカバーできません。しかし、これは新たな問題を引き起こします。オペレーターが操作マニュアルのみを参照して異常に対処できるとは期待できないのです。なぜなら、マニュアルではあらゆる状況を網羅できないからです。 自動化システムが成功するほど、人間の介入の必要性は減りますが、人材育成に必要な投資は大きくなります。 介入が少ないほど、人のスキルは早く劣化し、まれな異常に対処する能力は弱くなり、各トレーニング セッションのコストは高くなります。 意思決定者は AI によってコストを削減したいと考えていますが、削減された人的資源コストをトレーニング コストとして 2 倍にする必要があるかもしれません。 8. リーダーシップのジレンマ: AI を監督するということは、受動的に監視するだけではなく、能動的に「導く」ことです。 AIエージェントの監視は、単に受動的に監視するだけでなく、能動的に指示を与えることです。何をすべきか、何をすべきでないか、何歩進むべきか、そしてどのように方向を調整するべきかを指示します。 これは実はリーダーシップのスキルなのです。 LinkedInでAIエージェントを最も熱烈に称賛するのはなぜマネージャーが多いのでしょうか?それは、彼らが目標設定、タスク割り当て、フィードバック提供、方向性調整といった間接的な業務に慣れているからです。しかし、実際の業務は行いません。彼らにとって、AIエージェントを指導することは、部下を指導することと何ら変わりません。 しかし、これまでずっと自分で仕事をしてきた人にとっては、これは大きな役割の転換です。自分で何かをする人から、他の人に何かをさせる人へと変わらなければなりません。これは、いくつかの指示を変えるだけで解決できる問題ではなく、スキルセットを根本から再構築する必要があるのです。 会社は新しく昇進した管理職にリーダーシップ研修を提供しています。しかし、AIの監督者にリーダーシップ研修を提供している会社を見たことがあるでしょうか? 40年前の論文はこう締めくくられていました。 人間は時間的なプレッシャーがなければ、素晴らしい問題解決能力を発揮できます。問題は、時間的なプレッシャーがかかると効率が劇的に低下してしまうことです。この論文が2つの点を明らかにしてくれることを願っています。1つ目は、皮肉なことに、自動化が必ずしも困難を解消するわけではないということです。2つ目は、これらの問題を解決するために必要な技術的創造性は、自動化そのものよりも大きい可能性があるということです。 40年後、私たちは異なる状況にいますが、同じ一連の問題に直面しています。 AIエージェントは進化していますが、人間の認知構造は依然として変化していません。モニタリングによる疲労は依然として30分しか持続せず、スキルの低下は依然として使用の有無によるものであり、注意力の盲点も依然として存在します。これらはハードウェアの限界であり、ソフトウェアのアップデートで解決できるものではありません。 おすすめの読み物: 「自動化の皮肉」:https://t.co/5HWoelLIkR 「AIと自動化の皮肉 - パート1」 https://t.co/u27fpcCOWk 「AIと自動化の皮肉 - パート2」

スレッドを読み込み中

X から元のツイートを取得し、読みやすいビューを準備しています。

通常は数秒で完了しますので、お待ちください。