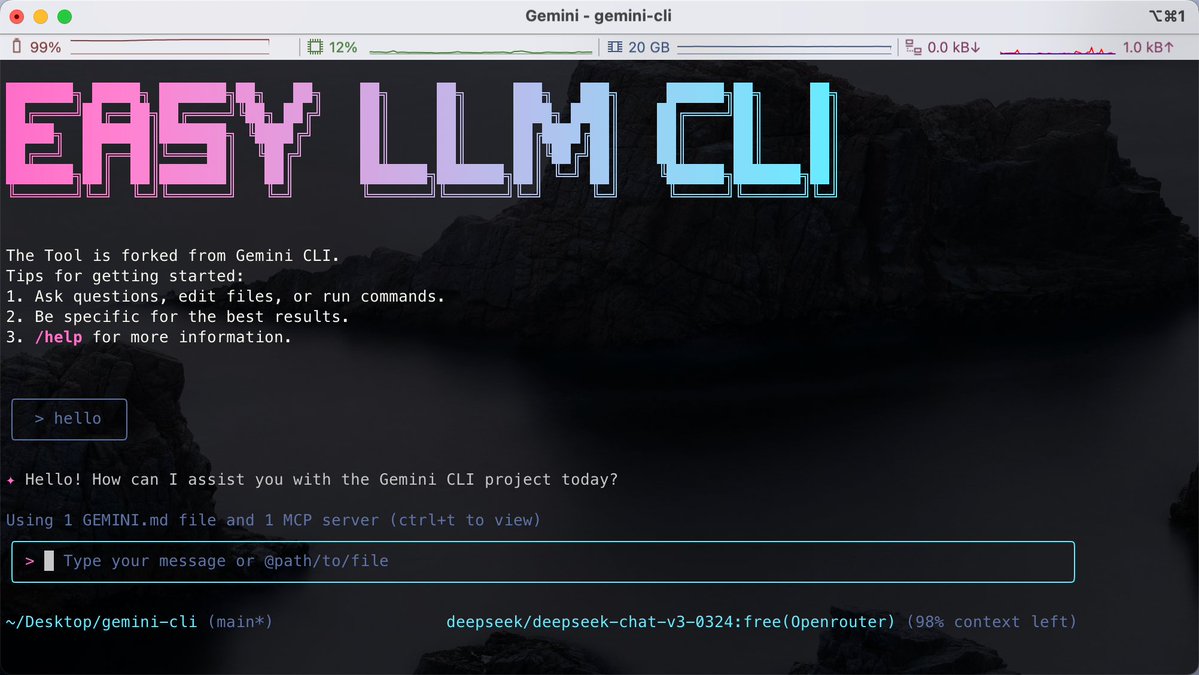

ターミナルでコードを書くことに慣れている人にとって、さまざまな AI ツールが特定のモデルに結び付けられているため、同じ CLI 内でさまざまな大規模モデルを柔軟に切り替えるのが難しいという課題がよくあります。 GitHubでEasy LLM CLIというオープンソースプロジェクトを見つけました。Google Gemini CLIをベースにした二次開発ですが、単一モデルの限界を打ち破っています。 Gemini、OpenAI、Claude、DeepSeek などの複数のモデルと互換性があり、Ollama を介したローカル モデルへのアクセスもサポートしています。 ツールの機能を拡張するための MCP (モデル コンテキスト プロトコル) をサポートするだけでなく、コード リポジトリのコンテキストを直接読み取ることもできるため、Git 操作の自動実行、コードのリファクタリング、アプリケーションの生成にも役立ちます。 GitHub: https://t.co/MofOBwdQdw Node.js環境が必要ですが、インストール不要でnpxを使って直接実行できます。シンプルな環境変数の設定で、使用したいモデルのバックエンドをカスタマイズできます。 これは、特定のベンダーに縛られず、ターミナル上でタスクを効率的に処理したい開発者に適しています。

スレッドを読み込み中

X から元のツイートを取得し、読みやすいビューを準備しています。

通常は数秒で完了しますので、お待ちください。