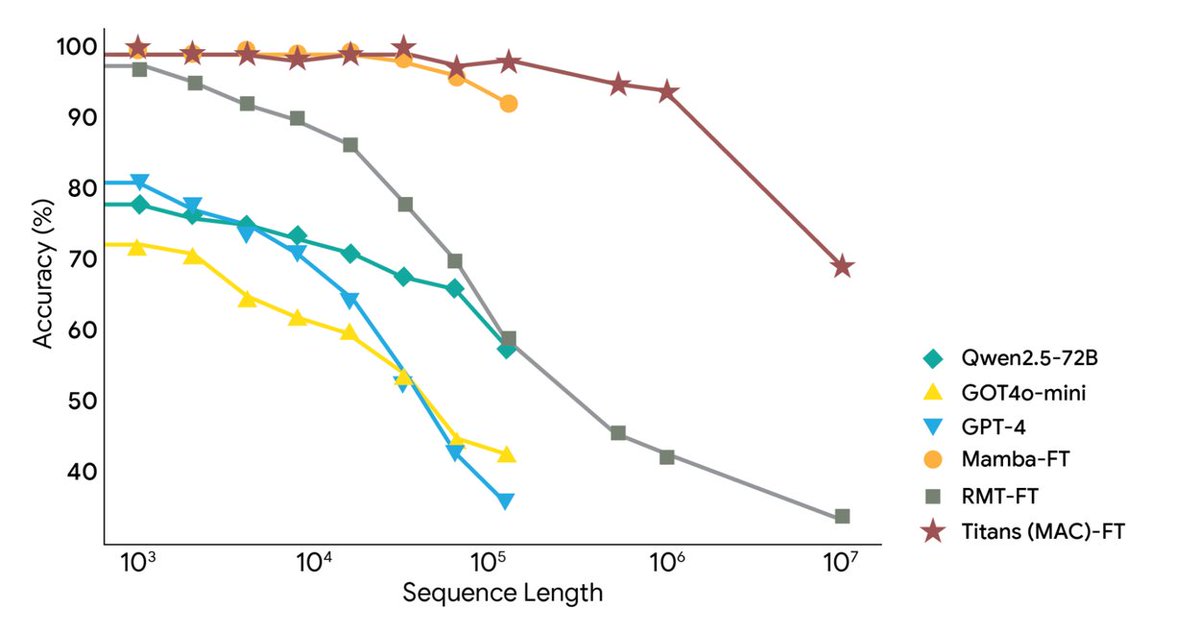

Google Research は本日、AI の極めて長いコンテキストと長期記憶の課題に対処し、コンテキストを 200 万以上のトークンに拡張する、Titans アーキテクチャと MIRAS フレームワークという 2 つの新しいフレームワークをリリースしました。 リアルタイム学習にディープニューラルメモリを使用することで、大規模なモデルが実行中に長期メモリをリアルタイムで更新できるようになり、RNN の速度と Transformer の精度を実現します。 Titans により、AI は実行時に長期記憶モジュールをリアルタイムで更新できるようになります。 MIRAS は、統合メモリ システムの理論的な青写真を提供します。 Titansは、従来のRNNの固定ベクトルではなく、多層パーセプトロン(MLP)を用いて長期記憶を構築します。新しい単語が読み込まれるたびに「驚きレベル」が計算され、注目に値する単語はスキップされ、注目すべき単語は長期記憶に書き込まれ、MLPのパラメータがそれに応じて更新されます。 容量を制御するために、重みの減衰が追加され、重要でない古い情報が自動的にフェードアウトされます。 最終的に、Attention レイヤーは長期記憶を「オンデマンド」で取得することも、最新のコンテキストのみを確認することもできます。 MiRASは統一的な視点を提示し、主流のシーケンスモデルは本質的に同じ問題、つまり重要な情報を忘れずに新しい情報と古い記憶をいかに効率的に組み合わせるかという問題を解決していると主張しています。これらはすべて異なる形態の「連想記憶」システムです。 これは、AI モデルのメモリ システムを、メモリ構造、注意バイアス、保持ゲート、メモリ アルゴリズムの 4 つの主要な部分に分解します。 さらに、より複雑で洗練された数学的手法を判断に使用することを提案しており、これにより、より強力で堅牢な記憶システムの設計が可能になります。 実験では、Titans は言語モデリング、常識的推論、DNA モデリング、時系列予測、200 万トークンの BABILong タスクにおいて、同様の規模の Transformer++、Mamba-2、Gated DeltaNet よりも優れており、GPT-4 をも上回っていることが示されています。 #AIメモリ#タイタンズ

スレッドを読み込み中

X から元のツイートを取得し、読みやすいビューを準備しています。

通常は数秒で完了しますので、お待ちください。