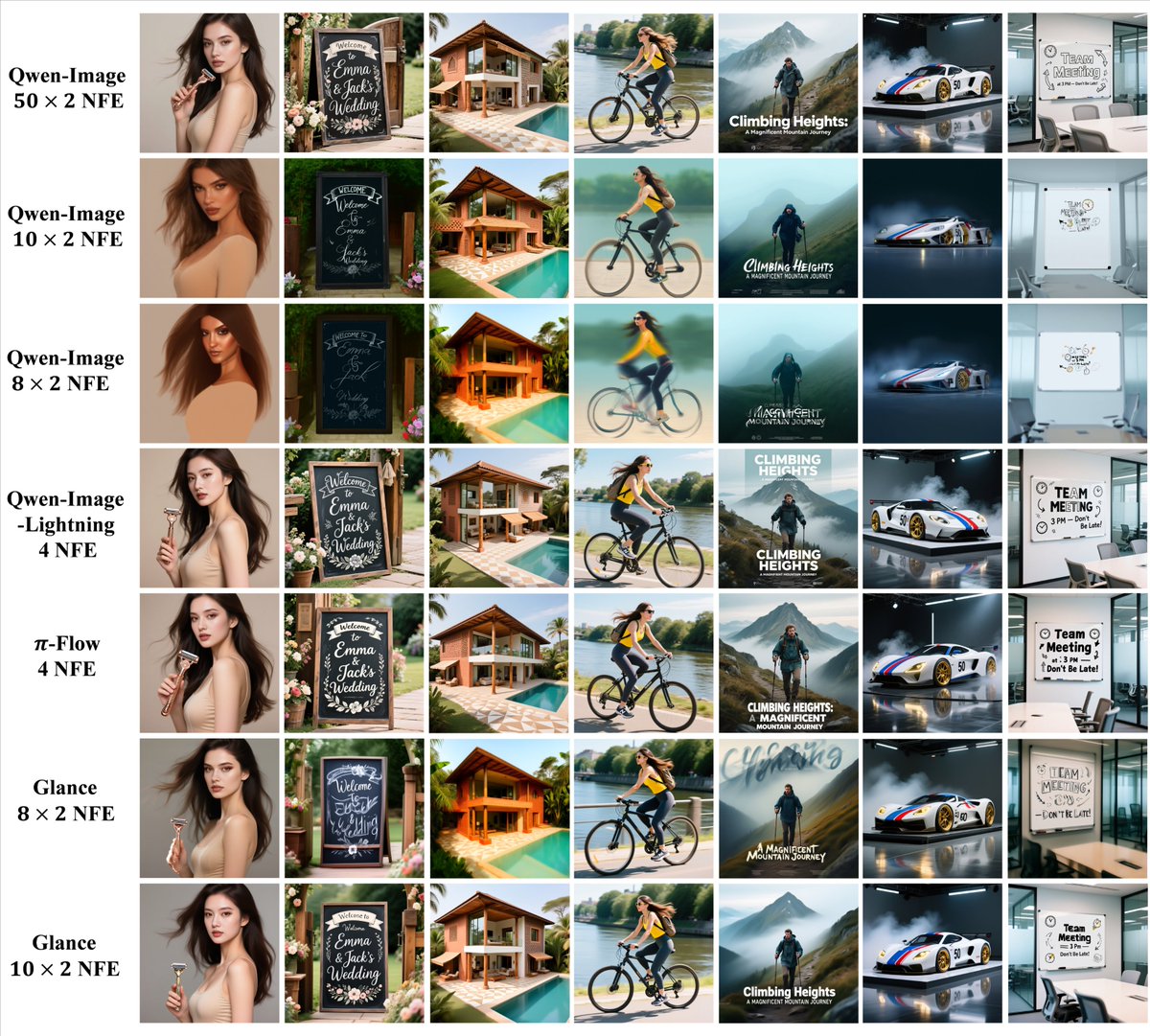

このプロジェクトは興味深いです。Glanceは、段階を考慮した加速手法で、「2段階LoRAエキスパート」によって、非常に少ないデータ(1サンプル)と非常に低いトレーニングコストで、生成品質を基本的に維持しながら、拡散モデルの推論を大幅に(最大5倍)加速できます。 現在の拡散マッピング モデル (安定拡散など) は次のように考えることができます。 「純粋なノイズから始めて、ゆっくりとそれをきれいに拭き取り、徐々に絵を消してください。」 質問は次のとおりです: 良質な画像を作成するには、通常、数十回、あるいは数百回も「消去」する必要があり、そのたびに大規模なモデルを実行する必要があります。これは時間がかかり、グラフィックカードにも大きな負荷がかかります。そのため、「生成された画像の品質は非常に良いが、処理が遅すぎる」と考える人が多いのです。 これまでの加速戦略には主に次のようなものがありました。 「生徒モデル」をより少ないステップで描画できるように再トレーニングするには、大量のトレーニング データと計算能力が必要であり、「頭脳流出」(一般化の不足)が発生する傾向があります。 Glance は異なるアプローチを採用しました。 すべてのステップを均等に圧縮する代わりに、次の点を観察します。 最初のステップは、構造と全体的な内容を定義する上で非常に重要です。後のステップでは、細部の洗練と小さなノイズの除去に重点が置かれます。その多くは「冗長」です。 そこで彼らは「段階的な加速」アプローチを実装しました。 モデルに 2 つの軽量 LoRA プラグインを追加します。 Slow-LoRA: 前半で使用され、「ゆっくりとした着実な」アプローチを可能にし、ジャンプを最小限に抑え、構成とセマンティクスが損なわれないことを保証します。 Fast-LoRA: ゲーム後半で使用され、時間を節約し、計算を減らす大胆なジャンプを可能にします。 これら 2 つの LoRA アルゴリズムは、1 つのサンプル画像のみを使用して 1 つの V100 画像で約 1 時間でトレーニングできるため、トレーニング コストはごくわずかです。 消す: 元のモデルと比較すると、推論速度は最大 5 倍まで向上しますが、さまざまなテスト セットで生成されたグラフの品質は基本的に元のモデルと同じであり、明らかな低下はありません。

スレッドを読み込み中

X から元のツイートを取得し、読みやすいビューを準備しています。

通常は数秒で完了しますので、お待ちください。