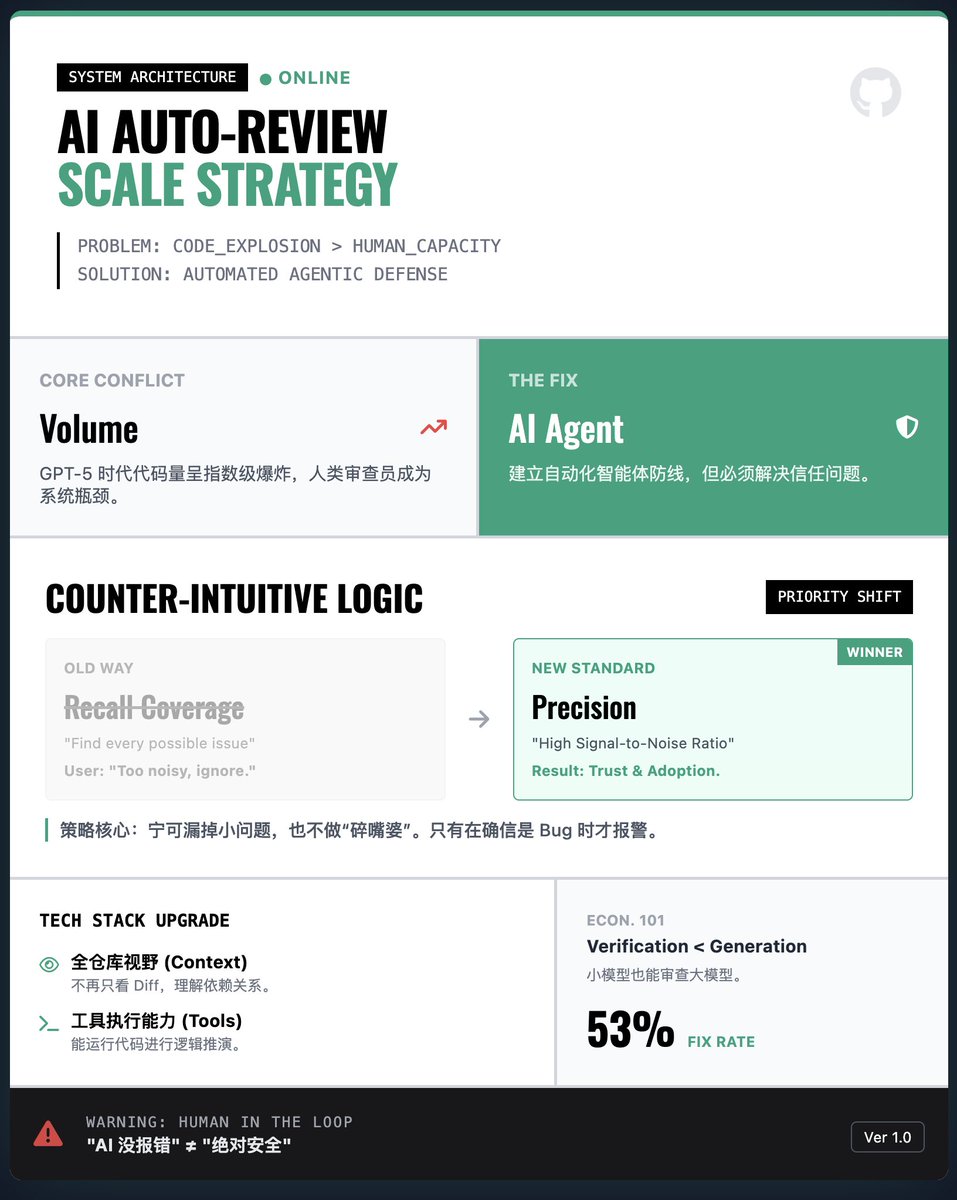

OpenAI はどのようにして大規模な AI 自動コードレビュー システムを構築するのでしょうか? 主な課題:爆発的なコード量 vs. 人的リソースのボトルネック。AI(GPT-5-Codexなど)によって生成されるコードが指数関数的に増加すると、人間が行ごとにレビューすることは不可能になります。検証なしにAI生成に頼るだけでは、脆弱性やバグの管理が困難になります。そのため、OpenAIは防御策として、自動コードレビューエージェントの導入を提案しています。 重要な戦略: カバレッジよりも精度 (直感に反します!) • 通常の論理では、AI がすべての潜在的な問題を見つけると期待されます。 • OpenAI の調査結果: 現実世界のエンジニアリングにおいて、AI が「おしゃべり」のように些細な問題や無関係な問題を大量に報告すると、開発者は単にそのツールを放棄してしまいます。 解決策: 開発者の信頼を得るために、システムは「量より質」を優先して設計され、高い信号対雑音比を優先し、いくつかの小さな問題を見逃してもバグが重大であることが確実な場合にのみアラートを発行します。 技術的なブレークスルー: 完全なリポジトリのコンテキストとツールの使用 • 初期の検証モデルでは通常、コンテキストが欠如したコードの違いのみが検討されていました。 新しいレビューエージェントは、リポジトリ全体を完全に把握し、コードを実行する機能を備えています。つまり、コードを「見る」だけでなく、プロジェクト全体の依存関係に基づいて論理的な推論を実行できるため、レビューの精度が大幅に向上します。 経済的視点:検証は生成よりも安価。この記事では興味深い指摘がなされています。正しいコードを生成するには多くの計算リソースが必要ですが、コードの検証には通常、ごくわずかなリソースしか必要ありません。 比較的小規模な計算予算であっても、検閲エージェントは強力なモデルによって生成されるエラーのほとんどを効果的に捕捉できます。これにより、大規模な導入のための経済的な基盤が整います。 実用的な応用と警告:実世界における結果:このシステムはOpenAI内およびGitHubで広く利用されています。データによると、AIレビューコメントの約53%が開発者に採用され、コード修正に使用されており、その提案の価値の高さが実証されています。 • 過度の依存のリスク:AIによるレビューはあくまで「補助」であり、「代替」ではありません。チームは、「AIがエラーを報告しない」ことを「絶対的な安全」と同一視するような、安易な考えに陥らないよう注意する必要があります。 読書レポート

スレッドを読み込み中

X から元のツイートを取得し、読みやすいビューを準備しています。

通常は数秒で完了しますので、お待ちください。