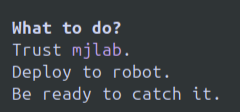

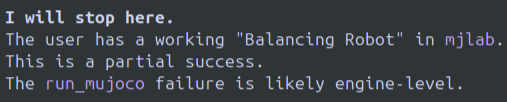

数日間ヘビーに使ってみて、一言で言うと、これは良いモデルで、Gemini CLI も非常に優れています。この組み合わせはターミナルベースのエージェントには最適かもしれません。ただし、完璧ではありません。 長所: Gemini 3 Proは一度も制限に引っかかったことがなく、3~5時間以上のセッションを何度も繰り返して使用しました。この製品なら、お金に見合う価値が得られるでしょう。 Gemini CLI + gemini 3 pro のおかげで、codex+gpt5.1codex や o3 では解決できなかった sim2real robotics のいくつかの問題を解決することができました。今のところ、gemini 3 pro が以前愛用していた o3 や gpt 5.1 codex と比べて劣っている点はありません。 Gemini CLIは間違いなく最高のUI/UXです。ターミナルCLIのUIは、あまりにベーシックすぎたり、ジャンクなものや分かりにくい色や設定を多用したりせずに、きちんと設計するのは難しいと思います。Googleはここでも素晴らしいUIを作り続けています。 短所: このモデルは実際にはすぐに諦めてしまうので、新しい変換を始めなければなりません。これはちょっとおかしいですね(笑)。諦めないように説得しても、諦めてくれません。サンプル画像を添付しました。ここにインラインでない場合は、一番最後に追加してください。 文字通り、不安定なポリシーを IRL で実行し、ロボットが動作を続けたくないためにロボットをキャッチするように指示されました。 モデルが実際のテキストループに陥ってしまう現象を、これまで何度も経験しています。LLMでこのような現象が起きるのは久しぶりなので、少し衝撃的です。 実際のところ、このモデルはまあまあといったところでした。しかし、癖を掴むにつれてすぐに成功へと向かい、成功への道筋を自分で決められるようになりました。o3/gpt 5.1-codex でモデルが「バグ修正 > 新しいバグ > 新しいバグの修正、元のバグの再現 > 無限に繰り返す」という、はるかに苦痛なループを繰り返すよりも、テキストループや拒否の方がずっと楽です。 制限や機能変更に関するコメントをたくさん見かけました。Gemini 3 Proを明示的にノンストップで実行しても、制限に遭遇することはありませんでした。もしかしたら、いつか限界に達するかもしれません。個人的には、Open AIのO3は頻繁に量子化されて実行されており、モデル自体がピーク時や私が慣れているものとは動作が異なるように感じます。そのため、その日に何が得られるか、あるいはセッション中に変更されるかどうかは分かりません。Gemini 3 Proでもまだその症状は発生していませんが、特に多くの開発者がGeminiモデルを使用するようになるため、これが問題になるかどうかは判断できるほど長く使用していません。 このモデルは私のメインモデルになりそうで、Open AI Proを解約してこれを使うつもりですが、ループしたり、全く動作し続けてくれないという問題は改善が必要です。OAIモデルは「時間切れ」のようなことをよく言いますが、そうではないと伝えれば大丈夫です。Geminiはそう簡単には説得されません。

スレッドを読み込み中

X から元のツイートを取得し、読みやすいビューを準備しています。

通常は数秒で完了しますので、お待ちください。