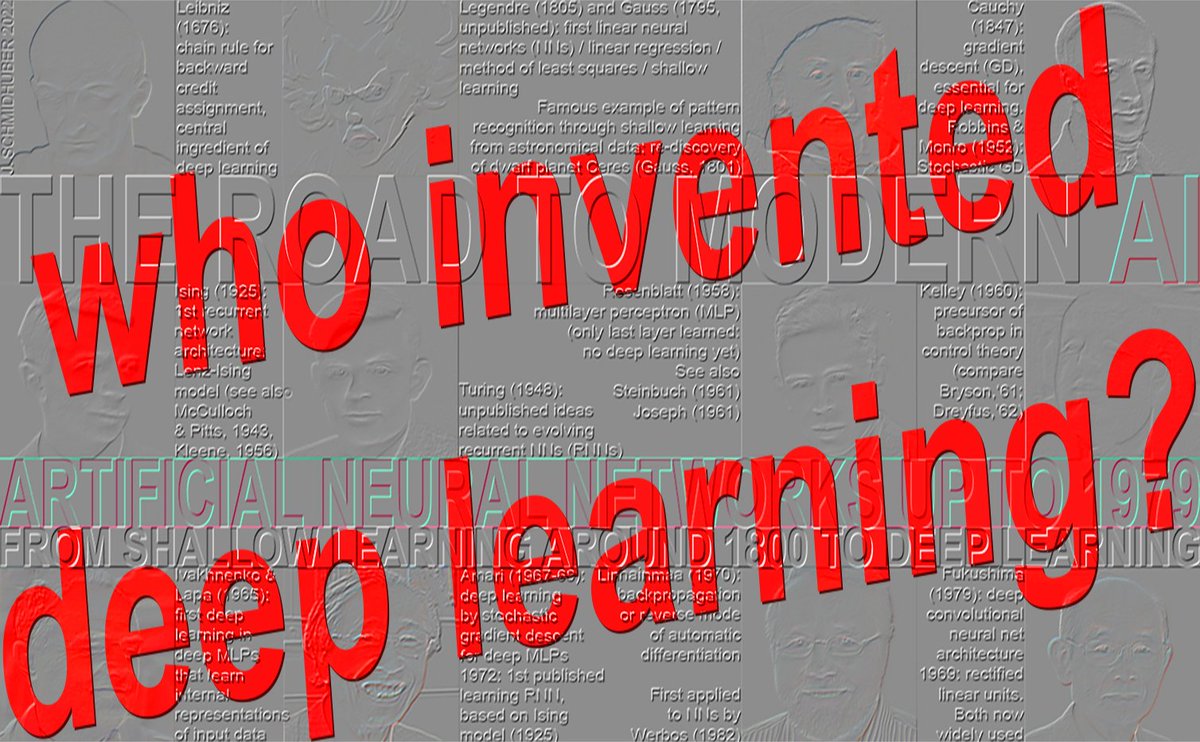

ディープラーニングを発明したのは誰ですか? https:people.idsia.ch/~juergen/who-i…ン: 1965年: 最初のディープラーニング(Ivakhnenko & Lapa、1971年までに8層) 1967-68年: 確率的勾配降下法によるエンドツーエンドのディープラーニング(Amari、5層) 1970年: ニューラルネットワーク(Werbos, 1982)のバックプロパゲーション(Linnainmaa, 1970): 5層を超えるものは稀(1980年代) 1991-93: 深層ニューラルネットワークの教師なし事前学習(Schmidhuber、その他、100層以上) 1991-2015: 深層残差学習(Hochreiter、その他、100層以上) 1996年以降: 勾配のないディープラーニング(100層以上) ★ 1965年: 最初のディープラーニング(Ivakhnenko & Lapa、1971年までに8層) ディープフィードフォワードネットワークアーキテクチャでの学習の成功は、1965年にウクライナ(当時はソ連)で、Alexey IvakhnenkoとValentin Lapaが、多くの隠し層(現在では一般的な乗法ゲートをすでに含んでいた)を持つディープマルチレイヤーパーセプトロン(MLP)またはフィードフォワードNN(FNN)用の、最初の一般的な実用的な学習アルゴリズムを導入したときに始まりました[DEEP1-2][DL1-2][DLH][WHO5]。 1971 年の論文 [DEEP2] では、新世紀でもまだ人気があった、引用数の多い手法でトレーニングされた 8 層のディープラーニング ネットについて説明しました [DL2]。 入力ベクトルとそれに対応するターゲット出力ベクトルの訓練セットが与えられた場合、層は段階的に成長し、回帰分析によって訓練されます。微調整フェーズでは、別の検証セット[DEEP2][DLH]を用いた正則化によって不要な隠れユニットが除去されます。これによりネットワークが簡素化され、未知のテストデータに対する汎化性能が向上します。層数と層あたりのユニット数は、問題に依存した方法で学習されます。これは、オリジナルの2層ガウス・ルジャンドルNN (1795-1805) [DLH]の強力な一般化です。 つまり、イヴァクネンコ氏とその同僚たちは、1980年代に「コネクショニズム」という名称が普及する20年も前に、適応型隠れ層を備えたコネクショニズムを考案していたのです。後の深層ニューラルネットワークと同様に、彼のネットワークは入力データの階層的かつ分散的な内部表現を学習して構築しました。彼はそれを深層学習ニューラルネットワークとは呼んでいませんでしたが、実際には深層学習ニューラルネットワークでした。 イヴァクネンコの先駆的な研究は、後にチューリング賞を共同受賞する研究者によって繰り返し盗用された[DLP][NOB]。例えば、イヴァクネンコの1971年の層別学習[DEEP2]の深度は、35年後に発表されたヒントンとベンジオの2006年の層別学習[UN4][UN5]の深度とほぼ同等であったが、これは元の研究[NOB]との比較なしに行われたものである。当時、計算コストは元の研究[NOB]の何百万倍も高かった。同様に、ルカンら[LEC89]は、イヴァクネンコの深層ニューラルネットワークの枝刈りに関する元の研究に言及することなく、ニューラルネットワークの枝刈り技術を発表した。受賞者たちは、ずっと後の深層学習に関する「調査」[DL3][DL3a]においても、深層学習の起源そのものについて言及していない[DLP][NOB]。イヴァクネンコとラパは、生物学的に不可能な逆方向パスを必要とせずに、局所的に利用可能な情報のみを用いて隠れユニットの適切な重みを学習できることも実証した[BP4]。60年後、ヒントンはこの功績を自らの功績と認めた[NOB25a]。 イヴァクネンコのネットワークは、深層学習を用いない、さらに初期の多層フィードフォワードネットワークと比べてどうでしょうか?1958年、フランク・ローゼンブラットは多層パーセプトロン(MLP)[R58]を研究しました。彼のMLPは、ランダムな重みを持つ非学習の初層と適応型出力層を備えていました。これはまだ深層学習ではありませんでした。なぜなら、最終層のみが学習していたからです[DL1]。MLPは1961年にカール・シュタインブック[ST61-95]とロジャー・デイヴィッド・ジョセフ[R61]によっても議論されました。オリバー・セルフリッジの多層パンデモニウム[SE59](1959)も参照してください。1962年には、ローゼンブラットらが、ジョセフが1961年に提案した隠れ層ユニットの学習に関する予備的なアイデア[R61]に基づいて、隠れ層を持つMLPにおける「誤差逆伝播」についてさえ論じました[R62]。しかし、ジョセフとローゼンブラットには深層MLPのための実用的な深層学習アルゴリズムがありませんでした。現在バックプロパゲーションと呼ばれているものは全く異なり、1970 年に Seppo Linnainmaa [BP1-4] によって初めて公開されました。 なぜ1960年代半ばのソ連でディープラーニングが生まれたのでしょうか?当時、ソ連は多くの重要な科学技術分野をリードしていましたが、特に宇宙分野では顕著でした。最初の人工衛星(1957年)、天体への最初の人工物体の着陸(1959年)、最初の人類の宇宙飛行(1961年)、最初の女性の宇宙飛行(1962年)、天体への最初のロボット着陸(1965年)、惑星外への最初のロボット着陸(1970年)などです。ソ連はまた、世界最大の爆弾(1961年)を爆発させ、多くの著名な数学者を輩出し、数十年後に初めてその重要性が明らかになる、青空数学研究のための十分な資金を有していました。 上記の他のセクション(1967、1970、1991-93、1991-2015、1996)については、[WHO5]「ディープラーニングを発明したのは誰か?」テクニカルノートIDSIA-16-25、IDSIA、2025年11月で取り上げられています。 選択された参考文献([WHO5]には追加の参考文献が多数あります - 上記のリンクを参照してください): [BP1] S. Linnainmaa. アルゴリズムの累積丸め誤差を局所丸め誤差のテイラー展開として表現する。修士論文(フィンランド語)、ヘルシンキ大学、1970年。第6~7章と58~60ページのFORTRANコードを参照。また、BIT 16, 146-160, 1976も参照。リンク。自動微分法の逆モードとしても知られる「現代的」バックプロパゲーションに関する最初の出版物。 [BP4] J. Schmidhuber (2014). バックプロパゲーションを発明したのは誰か? [BPA] HJ Kelley. 最適飛行経路の勾配理論. ARS Journal, Vol. 30, No. 10, pp. 947-954, 1960. 現代のバックプロパゲーションの先駆け [BP1-4]. [DEEP1] Ivakhnenko, AG and Lapa, VG (1965). サイバネティック予測装置. CCM Information Corporation. 多層構造を持ち、内部表現を学習する初の実用的なディープラーナー. [DEEP1a] イヴァクネンコ、アレクセイ・グリゴレヴィッチ. データ処理のグループ法:確率的近似法の競合. ソビエト自動制御 13 (1968): 43-55. [DEEP2] イヴァクネンコ, AG (1971). 複雑系の多項式理論. IEEE Transactions on Systems, Man and Cybernetics, (4):364-378. [DL1] J. Schmidhuber, 2015. 「ニューラルネットワークにおけるディープラーニング:概要」Neural Networks, 61, 85-117. 1988年創刊のNeural Networks誌より、初となる最優秀論文賞を受賞しました。 [DL2] J. Schmidhuber, 2015.ディープラーニング.Scholarpedia, 10(11):32832. [DL3] Y. LeCun, Y. Bengio, G. Hinton (2015). ディープラーニング. Nature 521, 436-444. ディープラーニングの「サーベイ」ですが、ディープラーニングの先駆的な研究には触れられていません [DLP][NOB]。 [DL3a] Y. Bengio、Y. LeCun、G. Hinton (2021). チューリング講演:AIのためのディープラーニング. Communications of the ACM、2021年7月. ディープラーニングの先駆的な研究に触れていない、ディープラーニングのもう一つの「サーベイ」 [DLP][NOB]. [DLH] J. Schmidhuber. 現代AIとディープラーニングの注釈付き歴史. 技術レポートIDSIA-22-22, IDSIA, ルガーノ, スイス, 2022. プレプリントarXiv:2212.11279. [DLP] J. Schmidhuber. チューリング賞受賞者3名が、その作成者をクレジットしなかった重要な手法やアイデアをいかに再出版したか。技術報告書IDSIA-23-23、スイスAIラボIDSIA、2023年。 [GD'] C. Lemarechal. コーシーと勾配法. Doc Math Extra, pp. 251-254, 2012. [GD''] J. アダマール。 Vequilibre des plaques elastiques encastrees に関する分析に関するメモワール。 Memoires presentes par divers savant estrangers à l'Academie des Sciences de l'Institut de France、33、1908。 [GDa] YZ Tsypkin (1966). 適応、訓練、自己組織化自動制御システム, Avtomatika I Telemekhanika, 27, 23-61. 非線形システムのための勾配降下法に基づくオンライン学習について。 [GDb] YZ Tsypkin (1971). 自動システムにおける適応と学習, Academic Press, 1971. 非線形システムのための勾配降下法に基づくオンライン学習について. [GD1] SI Amari (1967). 適応型パターン分類器の理論, IEEE Trans, EC-16, 279-307 (日本語版は1965年に出版)。確率的勾配降下法 [STO51-52] を多層ニューラルネットワークの学習に用いた最初の論文と考えられる(現在では逆自動微分法またはバックプロパゲーション [BP1] として知られている特定の勾配降下法については言及していない)。 [GD2] SI Amari (1968). 『情報理論―情報の幾何学的理論』共立出版, 1968年 (日本語版、119-120ページ参照)。非線形に分離可能なパターンクラスを分類するための内部表現を学習する5層ネットワーク(うち2層は変更可能)のコンピュータシミュレーション結果を掲載。 [GD2a] 斎藤 誠 (1967). 九州大学大学院工学府修士論文. 天理の1967年確率的勾配降下法の多層パーセプトロンへの実装 [GD1]. (天理誠、私信、2021年) [NOB] J. シュミットフーバー. 盗作でノーベル賞. 技術レポートIDSIA-24-24 (2024年12月7日、2025年10月更新). [NOB25a] G. Hinton. ノーベル賞講演:ボルツマンマシン. Rev. Mod. Phys. 97, 030502, 2025年8月25日. この講演における多くの問題のある記述の一つは、「ボルツマンマシンは現在では使われていないが、歴史的に重要な存在であった[...] 1980年代には、生物学的に不可能な逆方向パスを必要とせずに、局所的に利用可能な情報のみを用いて隠れニューロンに適切な重みを学習できることが実証された」という点である。ここでも、Hintonは、20年前の1960年代にこれを実証していたIvakhnenkoについて言及していない[DEEP1-2]。 [WHO5] J. Schmidhuber (AI Blog, 2025). Who invented deep learning? Technical Note IDSIA-16-25, IDSIA, Nov 2025. 上記リンクを参照。

スレッドを読み込み中

X から元のツイートを取得し、読みやすいビューを準備しています。

通常は数秒で完了しますので、お待ちください。