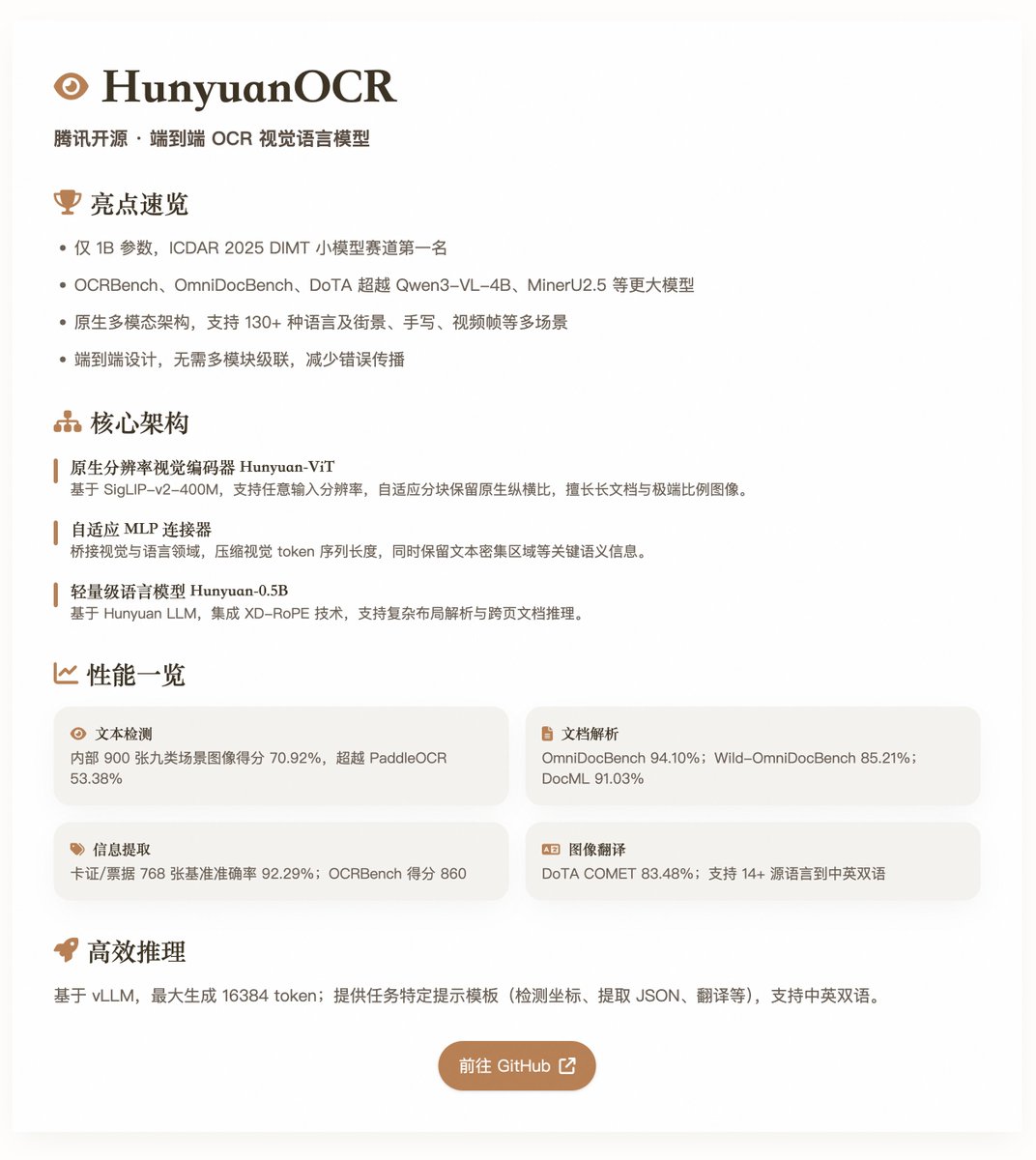

HunyuanOCR: テンセントのオープンソースエンドツーエンドOCRビジュアル言語モデル わずか1Bのパラメータサイズを持つHunyuanOCRは、複数のOCRベンチマークテストでトップクラスの性能を達成しました。ネイティブマルチモーダルアーキテクチャをベースとし、OCRタスクに最適化されており、テキスト検出、文書解析、情報抽出、ビジュアル質問応答、テキスト画像変換といったシナリオに適しています。このモデルは、ICDAR 2025 DIMTチャレンジ(小規模モデルトラック)で1位を獲得し、OCRbench、OmniDocBench、DoTAなどのベンチマークにおいて、Qwen3-VL-4BやMinerU2.5といった多くの大規模モデルを凌駕する性能を示しました。 コア機能とアーキテクチャ HunyuanOCRは、純粋なエンドツーエンドの視覚言語モデル設計を採用しており、従来のOCRシステムのような複数モジュールのカスケーディングを回避し、エラーの伝播とメンテナンスコストを削減します。そのアーキテクチャは、以下の3つの主要コンポーネントで構成されています。 • ネイティブ解像度ビジュアルエンコーダ(Hunyuan-ViT):約0.4億個のパラメータを持つSigLIP-v2-400M事前学習済みモデルをベースとし、任意の入力解像度をサポートします。適応型ブロック分割メカニズムにより画像の元のアスペクト比を維持し、長い文書、極端なアスペクト比を持つ画像、低品質のスキャン文書の処理に優れています。 • アダプティブ MLP コネクタ: 視覚領域と言語領域の橋渡しとして機能し、空間コンテンツの圧縮、視覚トークン シーケンスの長さの短縮、高密度テキスト領域などの重要な意味情報の保持を行います。 • 軽量言語モデル (Hunyuan-0.5B): 約 0.5B のパラメータを持つ Hunyuan LLM をベースに、XD-RoPE テクノロジを統合し、RoPE をテキスト、高さ、幅、時間の 4 つのサブスペースに分解して、複雑なレイアウト解析とページ間ドキュメント推論をサポートします。 このモデルは、複数のタスクにわたる統合モデリングをサポートし、追加の前処理モジュールを必要とせずに、自然言語指示(「画像内のテキストを検出して認識する」など)を通じて、知覚からセマンティクスまでのタスクを完了します。複数の言語(130言語以上、リソースの少ない言語を含む)と複数のシナリオ(ストリートビュー、手書き、ビデオフレームなど)をカバーし、トレーニング中にアプリケーションに合わせた高品質のデータと強化学習(RL)の最適化を重視し、複雑なシナリオにおける堅牢性を向上させます。 トレーニングとデータ構築(2分) • 事前学習フェーズ:このフェーズは4つのステップで構成され、合計約4540億トークンを使用します。視覚言語アライメント、マルチモーダル事前学習、ロングコンテキスト拡張(最大32Kトークン)、アプリケーション指向の教師ありファインチューニングが含まれます。データはオープンソースデータセット、合成要素レベルデータ、エンドツーエンドアプリケーションデータで構成され、合計約2億の高品質サンプルに及び、ストリートビュー、文書、手書きなど9つのシナリオをカバーしています。 • 学習後フェーズ:オンライン強化学習アルゴリズムGRPOを、タスク固有の報酬メカニズム(ルールベースやLLMを判断基準とするなど)と組み合わせて使用します。これにより、文書解析や翻訳といった難しいタスクにおけるモデルの精度と安定性が大幅に向上します。 データ パイプラインは、合成と拡張に重点を置いています。SynthDog フレームワークを拡張して、長い多言語ドキュメントを生成し、RTL レイアウトと複雑なフォントをサポートします。歪み合成パイプラインを導入して、現実世界の欠陥 (ぼやけ、歪み、照明の変化など) をシミュレートします。また、タスク間のサンプルを再利用して多様性と品質を確保する自動 QA 生成パイプラインも導入します。 パフォーマンス評価 - テキスト検出 (スポッティング): 900 枚の画像 (9 つのシーン カテゴリ) の内部ベンチマークで 70.92% のスコアを獲得し、PaddleOCR (53.38%) および Qwen3-VL-235B (53.62%) を上回りました。 • ドキュメント解析: OmniDocBench での総合スコアは 94.10%、テキスト編集距離は 0.042。Wild-OmniDocBench (リアルなシーンのキャプチャ) スコアは 85.21%、DocML (多言語) スコアは 91.03%。 • 情報抽出と VQA: 768 枚のカード/チケットのベンチマークで 92.29% の精度、92.87% のビデオキャプション抽出、OCR ベンチ スコア 860。 • テキストと画像の翻訳:14以上のソース言語から中国語/英語への翻訳をサポートし、DoTAではCOMETスコアが83.48%、DocMLでは73.38%(その他から英語)/ 73.62%(その他から中国語)です。 これらの結果は、特にモジュラー VLM や従来のパイプラインよりも優れたパフォーマンスを発揮する実際のシナリオにおいて、軽量レベルでのモデルの効率性を強調しています。 @vllm_project は効率的な推論をサポートし、最大16384個のトークンを生成します。レポートには、座標検出、JSON抽出、翻訳といったタスク固有のヒントテンプレートが用意されており、中国語と英語の両方をサポートしています。 オープンソースモデル:

スレッドを読み込み中

X から元のツイートを取得し、読みやすいビューを準備しています。

通常は数秒で完了しますので、お待ちください。