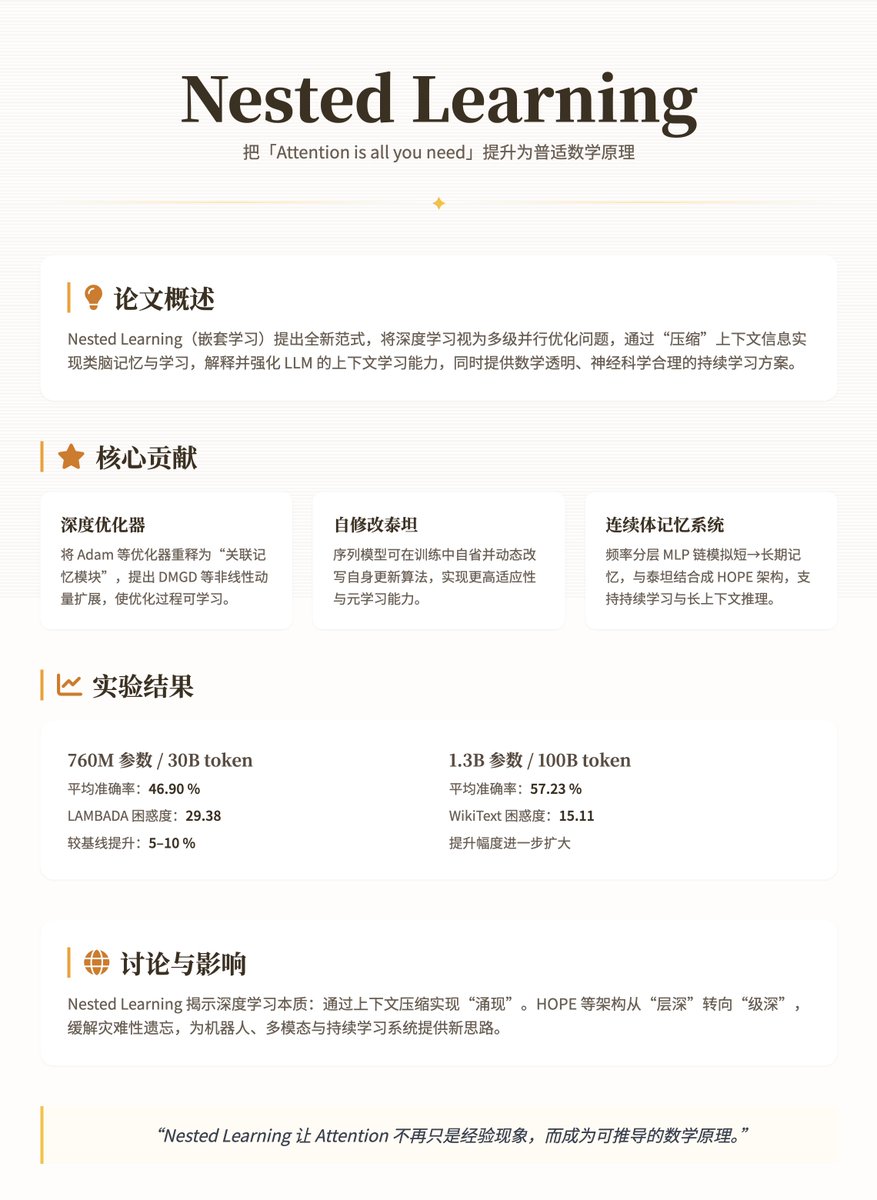

Google Research の最新論文「Nested Learning」は Transformer を基盤として、「Attention is all you need (注意さえあれば十分)」というスローガンを経験的現象からより深く普遍的な数学原理へと高めています。 本論文では、深層学習モデル、特にLLM(Long-Level M)を再検証し、改善するための新たなパラダイム、ネスト学習(Nested Learning)を提案します。その核となる主張は、従来の深層学習は単に層を積み重ねるのではなく、ネストされた多段階の最適化問題を通して文脈情報を「圧縮」することで、脳のような記憶・学習メカニズムを実現するというものです。これは、LLMの「文脈学習」能力を説明するだけでなく、LLMの静的および忘却問題を克服するための、数学的に透明かつ神経科学的に健全な解決策を提供します。 本論文の中核概念と貢献は、ニューラルネットワークをネストされた多段階並列最適化問題としてモデル化し、各段階が異なる「コンテキストフロー」に対応し、更新頻度は高から低(例えば、高速な短期記憶から低速な長期記憶の統合)まで変化するというものです。これは神経生理学における記憶統合プロセスに着想を得ています。脳はオンラインシナプス統合(リアルタイム調整)とオフラインシステム統合(長期記憶)を通じて情報を処理します。従来のディープラーニングはしばしば「幻想」とみなされます。一見すると深いアーキテクチャを持っているように見えますが、実際には勾配や注意信号を圧縮するために暗黙的なネスト最適化に依存しているからです。 この論文の主な貢献は次の 3 つの側面に及びます。 1. ディープオプティマイザー:これらは、AdamやモメンタムベースのSGDなどのオプティマイザーを、勾配圧縮損失(ℓ₂回帰など)を最小化することで履歴情報を「記憶」する「関連メモリモジュール」として再解釈します。著者らは、ディープモメンタム勾配降下法(DMGD)の導入、非線形モメンタムを扱うための多層MLPの使用、表現力を高めるための前処理の追加などにより、これらのオプティマイザーを拡張しています。これにより、最適化プロセスは固定ルールではなく、学習可能なサブモジュールのようなものになります。 2. 自己修正型タイタン:メタ学習に類似した、自身の更新アルゴリズムを動的に修正できるシーケンスモデルの一種。エージェントは学習中に「内省」し、パラメータ更新を調整することで、より高い適応性を実現します。 3. 連続記憶システム(CMS):周波数階層型MLPチェーン。各層は異なる周期(例えばCステップごとに1回)で更新され、短期記憶から長期記憶までの連続スペクトルをシミュレートします。CMSと自己修正型Titanを組み合わせることで、継続的な学習と長文脈推論をサポートする効率的な言語モデルであるHOPEアーキテクチャが実現します。 これらの貢献は、数式(連想メモリの最適化目標 min_M ˜L(M(K); V) や運動量更新 m_{t+1} = α m_t - η ∇L など)を通じて厳密に定義され、透明性とスケーラビリティが保証されます。 方法と技術的詳細 正規化(NL)の中核は、マルチタイムスケール更新です。モデルは線形層またはアテンションメカニズムに分解され、それぞれが専用の勾配フローを持ちます。例えば、 • シンプルな MLP トレーニングは、ローカルサプライズシグナル (LSS、出力とターゲットの不一致) を使用して勾配降下法を実行する、単一ステージの最適化として考えることができます。 線形アテンション メカニズムは 2 段階です。内側の層はドット積の類似性を通じてメモリを更新し、外側の層は投影行列を最適化します。 • モメンタムなどのオプティマイザーはキー値メモリに拡張されます。キーは履歴勾配、値は前処理子 P_i であり、より堅牢な圧縮を実現します。 HOPEアーキテクチャは、CMS(多階層MLPチェーン:y_t = MLP^{(f_k)}(...MLP^{(f_1)}(x_t)...))と自己修正メカニズムを統合し、並列計算をサポートし、Transformerの二次複雑性を回避します。学習中、内層は即時のパターンを捉えるために急速に更新され、外層は長期的な知識をゆっくりと統合することで、壊滅的な忘却を軽減します。 著者らは、3億4000万から13億のパラメータを持つモデルを、言語モデル(WikiText、LAMBADA)と常識推論タスク(PIQA、HellaSwagなど)で、300億から1000億トークンの事前学習済みデータを用いてテストした。ベースラインには、Transformer++、RetNet、DeltaNet、Titansが含まれた。結果は、HOPEがパープレキシティと精度の両方で大幅に優れていることを示した。 • 7億6000万のパラメータ/300億のトークン設定で、HOPEは平均精度46.90%、LAMBADAパープレキシティ29.38を達成し、ベースラインを約5~10%上回りました。 • 13億パラメータ/1000億トークンでは、平均精度は57.23%、WikiTextパープレキシティは15.11となり、より顕著な改善が見られました。 議論と影響 NLパラダイムは、深層学習の本質を明らかにします。それは、LLMにおけるFew-Shot Learningのように、コンテキスト圧縮を通じて「創発的」な能力を実現することです。しかし、同時に限界も露呈します。モデルは静的展開後に分布シフトの影響を受けやすいのです。HOPEのようなイノベーションは、多層ネストによってこの問題を軽減し、将来のアーキテクチャを「層の深さ」から「レベルの深さ」へと移行させ、ロボット工学やマルチモーダルシステムへの応用の可能性を秘めています。 紙の住所

スレッドを読み込み中

X から元のツイートを取得し、読みやすいビューを準備しています。

通常は数秒で完了しますので、お待ちください。