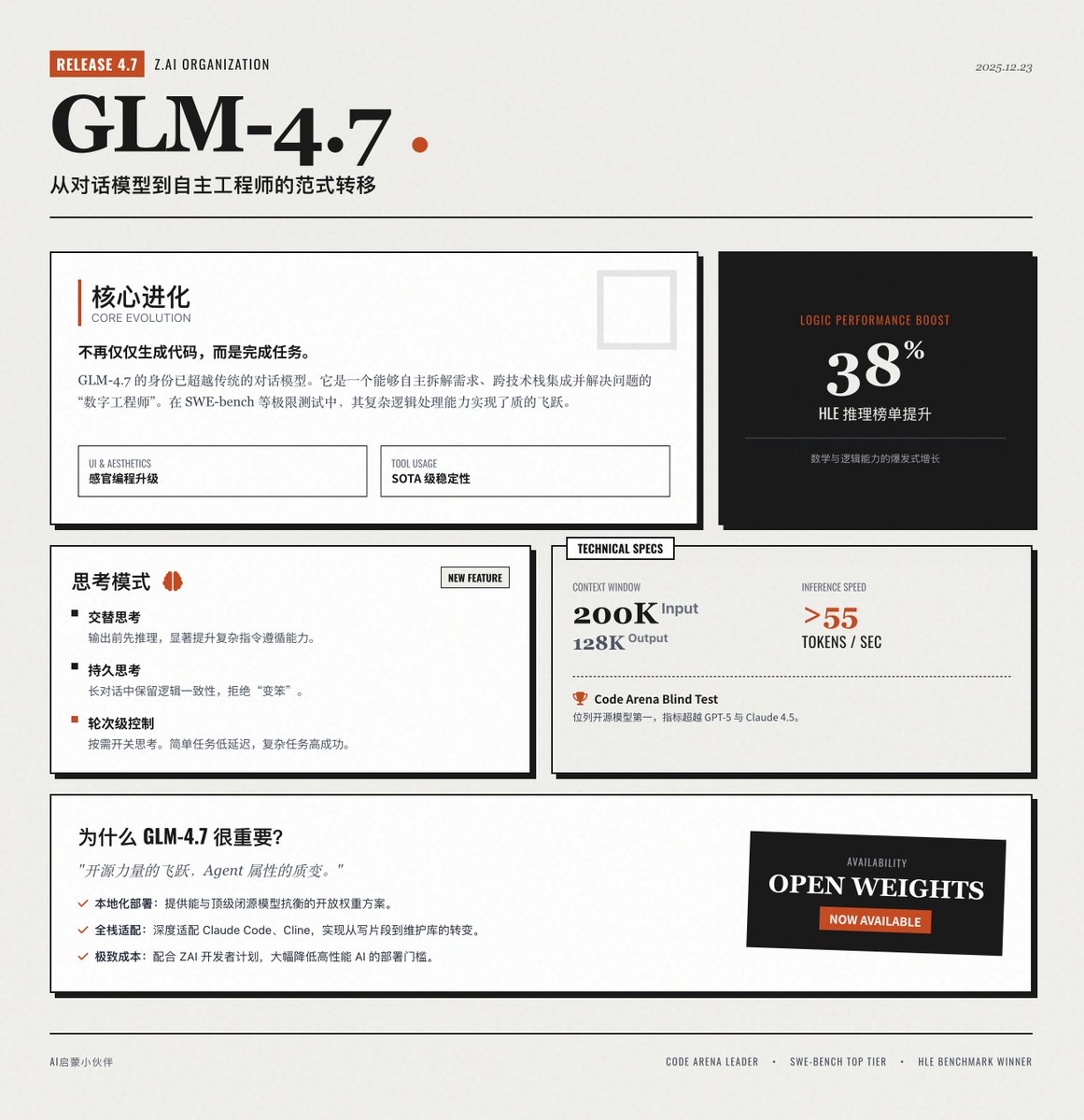

Zhipu AI lance officiellement GLM-4.7 🚀 Le dernier modèle phare de Zai AI, une mise à niveau majeure de la série GLM, a réalisé des progrès révolutionnaires en matière de programmation, de raisonnement logique et de capacités des agents. 📢 Interlude : Cette fiche d’information a été générée à l’aide de GLM-4.7 et de ses invites de saisie. Vous pouvez ainsi vous faire une idée de ses fonctionnalités de conception d’interface. Évolution fondamentale : De la « génération de code » à « l'achèvement de la tâche » GLM-4.7 n'est plus seulement un modèle de dialogue ; il s'apparente davantage à un ingénieur numérique capable de résoudre de manière autonome des problèmes complexes. • Programmation de base : Programmation d’agents multilingues améliorée, surpassant considérablement son prédécesseur dans des tests de programmation complexes tels que SWE-bench, capable de comprendre de manière autonome les exigences, de décomposer les solutions et de s’intégrer à travers différentes piles technologiques. • Programmation sensorielle : Améliore l'esthétique de l'interface utilisateur/du front-end, ce qui donne un code de page Web et des mises en page de diapositives plus modernes et plus esthétiques, réduisant ainsi le processus fastidieux des ajustements manuels de style. • Appel d'outils : Stabilité de décision en plusieurs étapes, atteignant un niveau de pointe (SOTA) sur le banc d'essai d'utilisation d'outils complexes et prenant en charge l'extraction en temps réel des paramètres de l'outil. • Raisonnement complexe : percées mathématiques et logiques, avec des performances améliorées d'environ 38 % par rapport à GLM-4.6 sur des benchmarks de raisonnement extrêmement difficiles tels que HLE. Fonctionnalités innovantes : Mode de « pensée » multidimensionnelle GLM-4.7 introduit un contrôle plus flexible de la chaîne de pensée, rendant le modèle plus « rationnel » dans le traitement des tâches. Pensée alternée : Réfléchir avant de donner une réponse ou d’utiliser un outil améliore considérablement la capacité à suivre des instructions complexes. • Pensée persistante : Dans les dialogues à plusieurs tours, le modèle conserve ses processus de pensée précédents, assurant ainsi la cohérence de la pensée dans les tâches de programmation complexes tout au long des longues conversations et empêchant le modèle de « devenir stupide en raison de dialogues excessivement longs ». • Contrôle de la réflexion par cycles : les utilisateurs peuvent activer ou désactiver la fonction de réflexion selon leurs besoins. Pour les tâches simples, comme la recherche d’informations, la réflexion peut être désactivée afin de réduire la latence ; pour la planification complexe, la réflexion approfondie peut être activée afin d’optimiser les chances de réussite. Spécifications techniques et performances GLM-4.7 a atteint le plus haut niveau du secteur en termes de paramètres techniques, notamment en matière de traitement de textes longs et d'efficacité. • Contexte long : Prend en charge jusqu'à 200 Ko d'entrée de contexte et jusqu'à 128 Ko de sortie de contenu en une seule exécution. • Vitesse d'inférence extrême : des vitesses d'inférence supérieures à 55 jetons/s offrent une expérience de réactivité exceptionnelle tout en maintenant des performances de pointe. • Classement de référence : Dans des tests à l'aveugle tels que Code Arena, GLM-4.7 s'est classé premier parmi les modèles open source, et certaines métriques ont même surpassé GPT-5 et Claude 4.5 Sonnet. Pourquoi GLM-4.7 est-il si important ? • Un bond en avant dans la puissance de l'open source : En tant que modèle de pondération ouvert, GLM-4.7 offre aux développeurs une option qui peut rivaliser avec les meilleurs modèles à code source fermé, favorisant grandement la possibilité de déploiement local et d'applications privées. • Attributs d'agent renforcés : Il s'agit de l'un des modèles les plus compatibles avec les solutions d'assistance à la programmation intelligente telles que Claude Code et Cline, permettant véritablement de passer de « l'écriture de fragments de code » à « la maintenance autonome de l'ensemble du code source ». • Équilibre entre efficacité et coût : Grâce au programme pour développeurs lancé par ZAI, le coût de son utilisation a été considérablement réduit, rendant le déploiement à grande échelle d'une IA haute performance plus pratique. Consultez l'annonce officielle :

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.