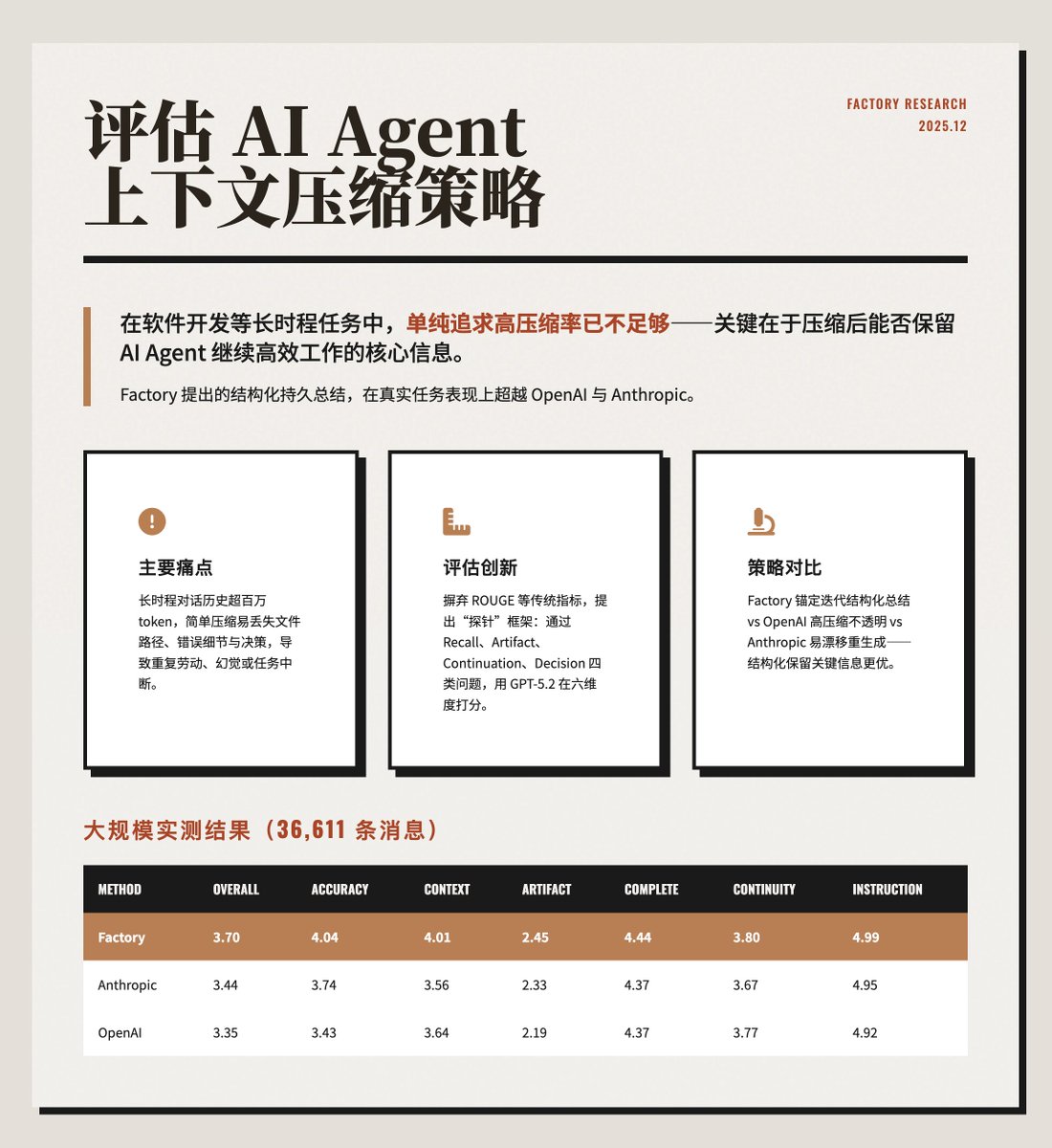

Évaluer la stratégie de compression du contexte de l'agent d'IA Pour les tâches exigeant de la continuité, comme le développement logiciel, un factory.ai/news/evaluatin…textuelle élevé ne suffit pas. Il est essentiel que le processus de compression préserve les informations cruciales au bon fonctionnement de l'agent d'IA. La méthode de résumé structuré proposée par @FactoryAI surpasse OpenAI et Anthropic dans les applications pratiques. https://t.co/ZsCDxoVO3Q Principaux problèmes Lorsque les agents d'IA fonctionnent pendant de longues périodes, ils génèrent une quantité massive d'historique de dialogue (plus d'un million de jetons), dépassant ainsi la limite de la fenêtre de contexte du modèle. Une simple compression peut facilement entraîner la perte d'informations cruciales, telles que des chemins de fichiers modifiés, des messages d'erreur ou des décisions antérieures, ce qui peut amener l'agent d'IA à effectuer des tâches répétitives, à souffrir d'hallucinations ou à subir des interruptions. L'article souligne qu'il est essentiel d'optimiser la « consommation de jetons par tâche » plutôt que la « réduction de jetons par compression » pour garantir un fonctionnement efficace et continu. La méthode d'évaluation proposée innove par rapport aux métriques traditionnelles (telles que ROUGE ou la similarité d'embedding), qui ne mesurent que la similarité textuelle et ne permettent pas d'évaluer si le contexte compressé permet la poursuite de la tâche. Cet article propose un cadre d'évaluation basé sur l'exploration : • Après la compression, posez des questions spécifiques à l'agent IA pour tester sa rétention. • Les sondes sont classées en quatre catégories : rappel, artefact, continuation et décision. • Utilisez GPT-5.2 comme évaluateur LLM et notez-le dans six dimensions (0-5 points) : précision, conscience du contexte, suivi de la pièce, intégrité, continuité et conformité aux instructions. Comparaison de trois stratégies de compression : Factory : Utilise une « résumé itératif ancré », conservant un résumé structuré et persistant qui inclut l’intention, les modifications apportées au document, les décisions et les prochaines étapes. Le nouveau contenu est fusionné progressivement, plutôt que d’être régénéré à chaque fois. • OpenAI : utilise l'interface `/responses/compact`, atteignant le taux de compression le plus élevé (99,3 %), mais son résumé est opaque et supprime souvent le contenu à faible entropie tel que les chemins de fichiers. • Anthropic : Génère des résumés structurés et détaillés (incluant analyses, documents, tâches, etc.), mais il se régénère complètement à chaque compression, ce qui peut entraîner une dérive des résumés. L'exemple et les résultats illustrent cela avec un cas spécifique de débogage d'une erreur 401 : Factory, après compression, se souvient avec précision des détails de l'erreur et de sa cause première, tandis qu'OpenAI et Anthropic perdent une partie de leur spécificité technique. Les résultats d'un test à grande échelle sur des données de production réelles (36 611 messages) sont présentés dans l'image ci-dessous. Factory excelle en matière de précision et de prise en compte du contexte. Si OpenAI affiche le taux de compression le plus élevé, sa qualité est en revanche la plus faible, ce qui peut engendrer des coûts de récupération supplémentaires dus à la perte d'informations. Point clé à retenir : Privilégier la structure à la compression extrême : des résumés explicitement segmentés préservent mieux les informations clés. Le taux de compression n'est pas le seul indicateur : une compression élevée peut sacrifier l'efficacité des tâches ; la consommation totale de jetons est plus importante. • Le suivi des pièces est un défi : toutes les méthodes obtiennent de faibles résultats dans ce domaine, ce qui nécessite des mécanismes d’indexation supplémentaires. • L’évaluation par sondage est plus fiable : elle reflète mieux l’utilisabilité réelle que les indicateurs NLP traditionnels.

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.