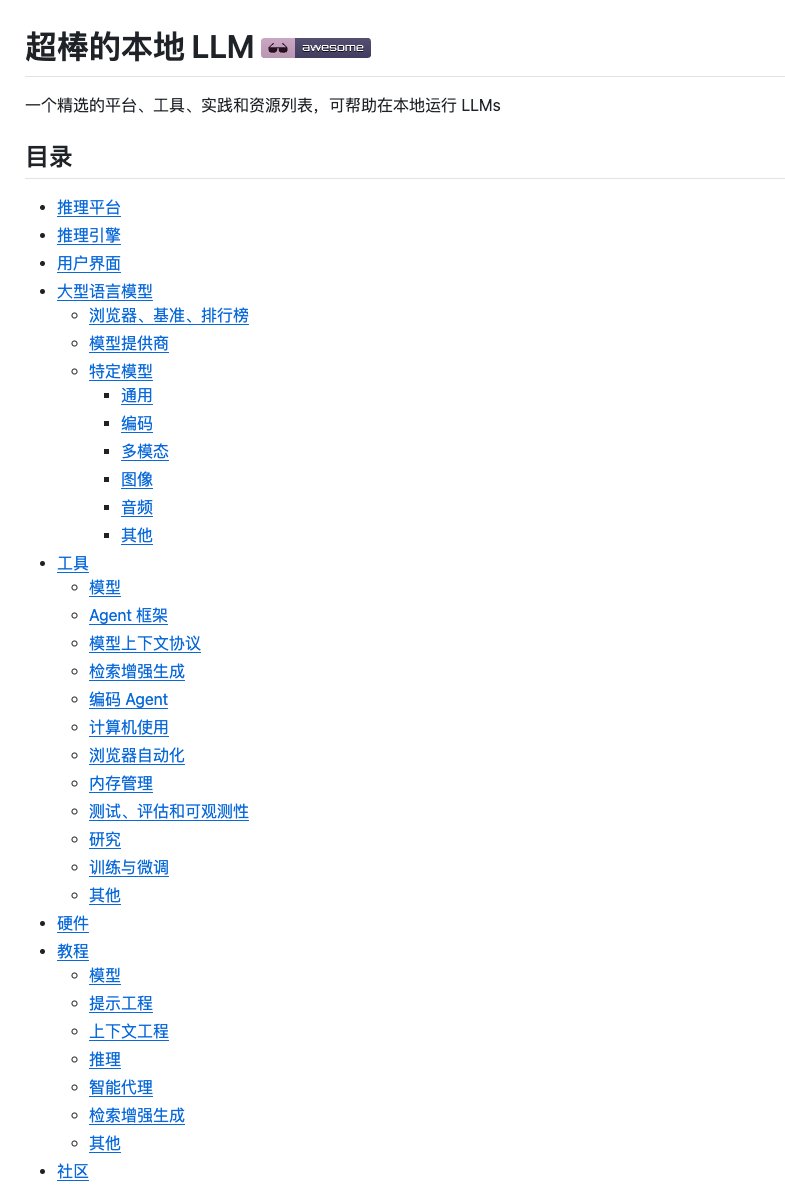

Déployer des modèles volumineux en local peut s'avérer complexe face à la multitude d'outils et de tutoriels disponibles. On passe d'Ollam à vLLM, sans parler des nombreux frameworks de paramétrage. Trouver une solution fiable relève souvent du parcours du combattant. Je suis tombé par hasard sur l'excellent projet local LLM sur GitHub, véritable encyclopédie pour l'exécution locale de modèles complexes. Non seulement il est exhaustif, mais sa logique de classification est également très claire, ce qui nous a permis de comprendre rapidement l'architecture technique. Il couvre plus d'une douzaine de catégories, notamment les plateformes d'inférence, les moteurs d'inférence, les interfaces utilisateur, les grands modèles de langage et les outils de développement, et comprend également des conseils sur le choix du matériel et des tutoriels pratiques. GitHub : https://t.co/9OJw4ll84L Chaque projet est identifié par son nombre d'étoiles sur GitHub et une brève description, ce qui permet d'en déterminer rapidement la popularité et l'objectif. Il comprend également des ressources pédagogiques telles que des tutoriels YouTube et des tests de matériel. Si vous souhaitez construire un environnement de modélisation local à grande échelle, ou si vous recherchez des outils open source dotés de fonctions spécifiques, cette collection mérite d'être conservée pour référence future.

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.