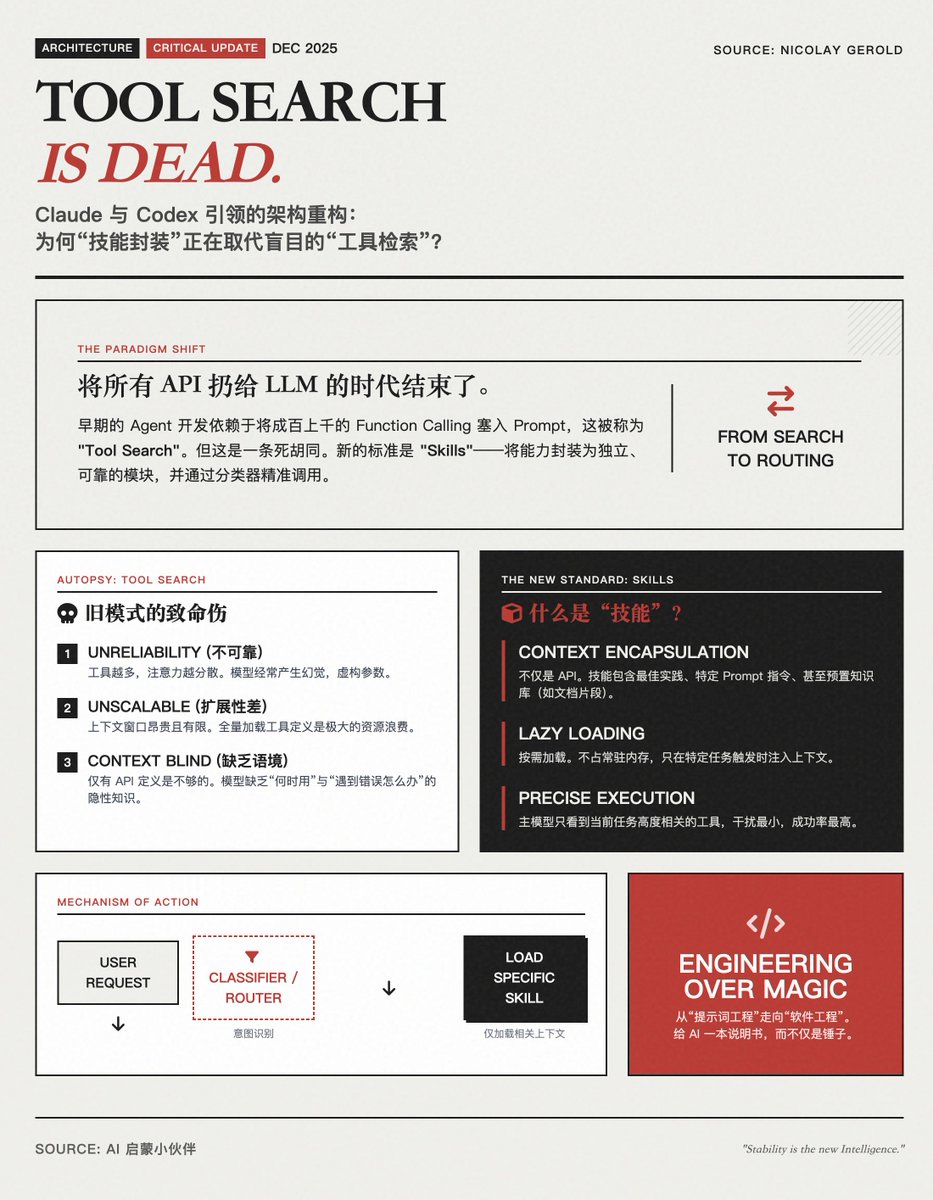

De la « recherche d’outils » aux « compétences » : un changement de paradigme dans l’architecture des agents d’IA Claude a publié les règles relatives aux compétences, et Codex a également commencé à les prendre en charge, ce qui devient une fonctionnalité standard pour les agents d'IA. Se contenter de déverser tous les outils sur un LLM et de le laisser choisir lui-même (c'est-à-dire la « recherche d'outils ») est une impasse ; l'avenir consiste à encapsuler les capacités sous forme de « compétences » indépendantes et fiables, et à les invoquer grâce à un mécanisme de classification plus précis. Argument clé : Pourquoi la « recherche d’outils » est-elle morte ? Dans les premières phases de développement d'agents, les développeurs avaient l'habitude d'insérer des dizaines, voire des centaines, de définitions d'appels de fonctions dans le contexte d'invite d'un modèle volumineux, en espérant que le modèle puisse « rechercher » et sélectionner l'outil approprié, comme on consulte un dictionnaire. L'auteur estime que ce modèle présente trois défauts rédhibitoires : • Peu fiable : à mesure que le nombre d'outils augmente, l'attention du modèle se trouve distraite, ce qui conduit souvent à la sélection d'un outil inapproprié ou à la génération d'illusions. • Faible évolutivité : les fenêtres de contexte sont limitées et gourmandes en ressources. Tenter d’intégrer toutes les définitions d’outils dans une seule invite gaspille des jetons et dégrade la qualité de l’inférence du modèle. • Manque de connaissances sur l’« usage » : Fournir simplement au modèle une définition d’API pour un outil (par exemple, get_weather(city)) est insuffisant. Le modèle a souvent besoin de connaissances implicites telles que « quand l’utiliser », « comment l’utiliser » et « que faire en cas d’erreur », mais le modèle de « recherche d’outil » ignore ce contexte. Solution : Les compétences deviennent la nouvelle norme. « Compétences » ne se limite pas à renommer des outils ; il s’agit d’une approche architecturale plus modulaire et directrice. Qu'est-ce qu'une « compétence » ? • Encapsule le contexte : une « compétence » inclut non seulement l'outil lui-même, mais aussi les meilleures pratiques d'utilisation de l'outil, des instructions d'utilisation spécifiques et même des bases de connaissances pré-construites. • Chargement à la demande : les compétences ne sont pas toujours associées au contexte. Le système ne « charge » les compétences spécifiques dans le modèle que lorsque cela est nécessaire. Comment ça marche ? (Catégorisation vs. Recherche) Les auteurs préconisent l'utilisation de classificateurs ou de couches de routage plutôt que de laisser de grands modèles parcourir aveuglément de longues listes. • Reconnaissance de l'intention : Lorsqu'un utilisateur effectue une requête, son intention est d'abord déterminée par un modèle ou un classificateur léger. • Chargement des compétences : En fonction des résultats de la classification, le système récupère uniquement le « pack de compétences de recherche » ou le « pack de compétences de programmation » correspondant dans le contexte. • Exécution précise : À ce stade, le modèle principal ne voit que quelques outils et instructions détaillées hautement pertinents pour la tâche en cours, ce qui se traduit par un taux de réussite extrêmement élevé. Résumé : Implications pour les développeurs d'IA Le développement d'agents passe de « l'ingénierie des mots-clés » à « l'ingénierie logicielle ». • Ancienne approche : fonder tous ses espoirs sur les capacités de généralisation du LLM et prier pour qu’il puisse trouver les bons outils au milieu du chaos. • Nouveau modèle (compétence) : Découpler les tâches complexes comme l’écriture de code. Ne pas se contenter de donner à l’IA un outil, mais aussi un « mode d’emploi », et ne la lui fournir que lorsqu’elle a besoin de planter des clous. Cette transformation a fait passer les agents d'IA de simples « jouets occasionnels » à de véritables « outils de productivité stables et fiables ». Pour les applications d'entreprise, une bibliothèque de « compétences » bien définie et clairement définie constituera un atout bien plus important qu'une simple accumulation de paramètres de modèle. Lire le texte original

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.