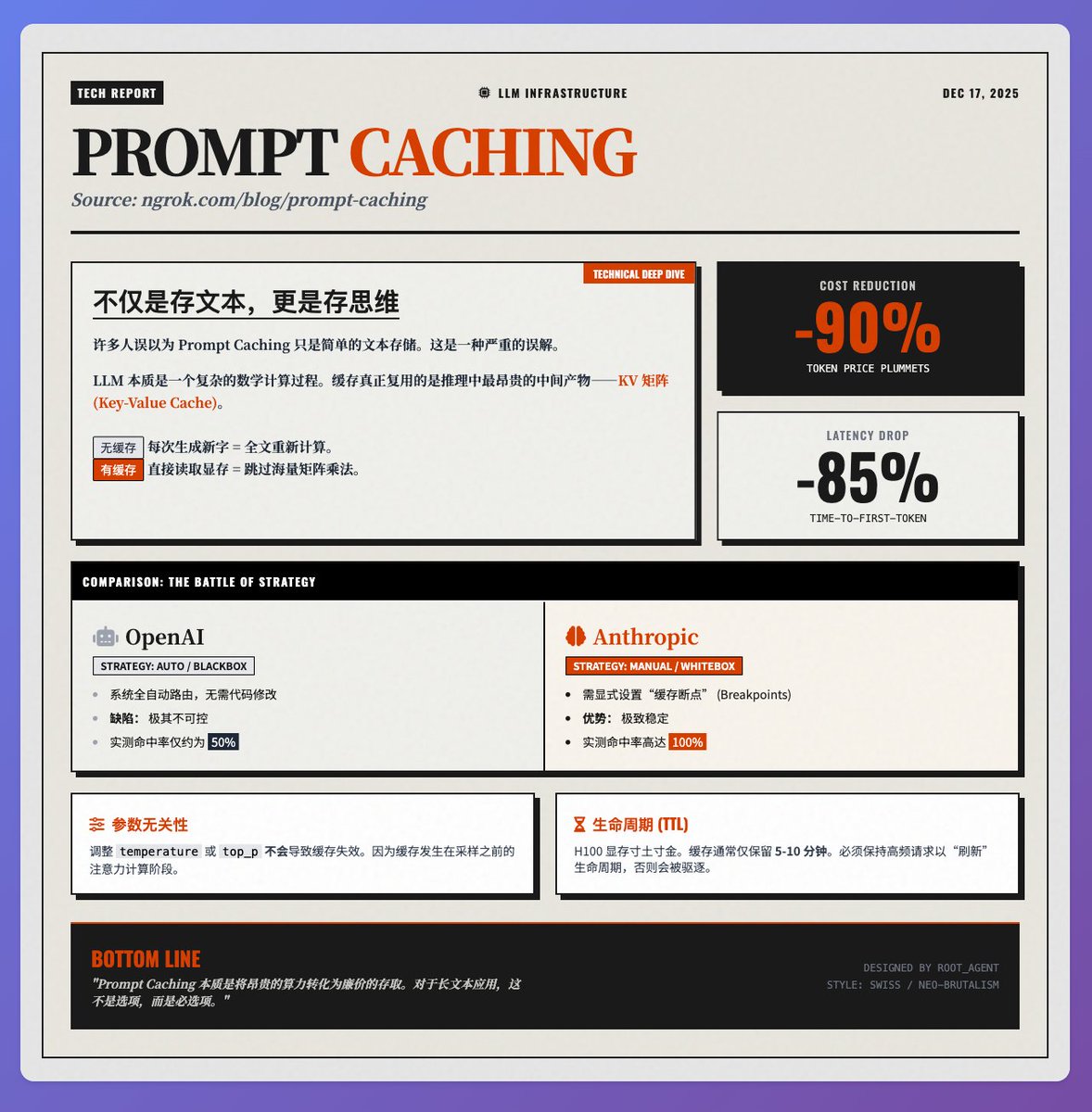

Réduction des coûts de 90 %, réduction de la latence de 85 % : Analyse approfondie des principes de la technologie de mise en cache rapide Dans son blog technique sur la mise en cache des invites au sein de l'équipe @ngrokHQ, Sam explique clairement comment cette technologie est devenue une application incontournable pour la réduction des coûts et l'amélioration de l'efficacité des applications LLM, depuis les principes sous-jacents jusqu'aux tests réels effectués par les fournisseurs. Principe fondamental : ce qui est mis en cache, ce n'est pas du « texte », c'est un « état d'esprit ». Beaucoup pensent à tort que la mise en cache des invites se contente de stocker le texte d'entrée. En réalité, elle réutilise le produit intermédiaire le plus coûteux du processus d'inférence du modèle : les matrices K (clé) et V (valeur) (c'est-à-dire le cache KV). Lors du traitement de chaque jeton, LLM doit calculer sa relation avec le contexte grâce à un mécanisme d'attention. • Sans mise en cache : pour chaque nouveau caractère généré, le modèle doit recalculer la matrice K/V de l’ensemble du texte, ce qui entraîne un énorme gaspillage de puissance de calcul. • Avec mise en cache : lire directement la matrice précédemment calculée à partir de la mémoire vidéo, en évitant la multiplication matricielle fastidieuse. C’est pourquoi il offre un double avantage : il permet d’économiser environ 90 % des frais de jeton et réduit de 85 % la latence du premier mot dans les scénarios de texte long. Tests des fournisseurs : Les différences entre les stratégies d’OpenAI et d’Anthropic. Dans les déploiements réels, les stratégies de ces deux fournisseurs majeurs sont radicalement différentes, ce qui a un impact direct sur la stabilité du système : 1. OpenAI (Boîte noire entièrement automatisée) : Le système tente automatiquement d'acheminer les requêtes vers le cache, sans nécessiter de modifications de code de la part des développeurs. Cependant, cette approche a un coût : l'imprévisibilité. Lors de tests réels, le taux de succès du cache s'est avéré instable, oscillant autour de 50 %. 2. Anthropique (boîte blanche manuelle) : Les développeurs peuvent définir explicitement des « points d'arrêt mis en cache ». Bien que cela complexifie le développement, avec une configuration adéquate, le taux de réussite atteint 100 % lors des tests en conditions réelles. Pour les environnements de production exigeant une stabilité extrême, Anthropic offre actuellement des performances encore supérieures. Détails techniques à prendre en compte par les développeurs : Indépendance des paramètres : La modification des paramètres d’échantillonnage, tels que la température ou le paramètre top_p, n’entraîne pas d’invalidation du cache. En effet, la mise en cache a lieu lors de la phase de calcul de l’attention, avant l’échantillonnage, ce qui offre une grande flexibilité pour le débogage de l’application. • Durée de vie : En raison du coût très élevé de la mémoire H100, le cache n’est généralement conservé que pendant 5 à 10 minutes. Pour le réutiliser sur une longue période, une fréquence élevée de requêtes est nécessaire afin de « rafraîchir » sa durée de vie. Résumer L'essence de la mise en cache des invites est de transformer des « ressources informatiques » coûteuses en une « récupération de stockage » relativement peu coûteuse. Pour les applications RAG, d'analyse de documents longs ou de dialogues à plusieurs tours, il s'agit d'une technologie clé qui non seulement permet de réaliser des économies, mais aussi d'améliorer considérablement l'expérience utilisateur. Référence au texte original

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.