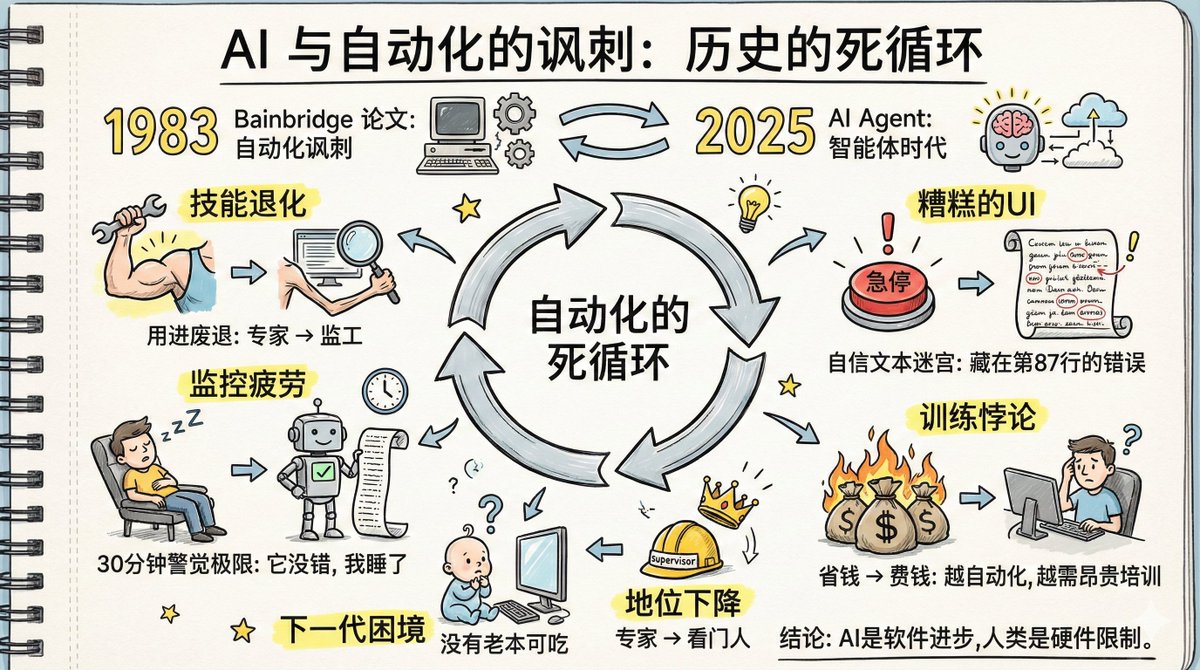

J'ai lu aujourd'hui un article intitulé « L'ironie de l'IA et de l'automatisation », et son contenu est très pertinent au regard du développement actuel de l'IA. En 1983, la psychologue cognitive Lisanne Bainbridge a écrit un article intitulé « L'ironie de l'automatisation ». Plus de quarante ans plus tard, les problèmes prédits dans cet article se réalisent mot pour mot dans le cas des agents d'IA. À l'époque, elle menait des recherches sur l'automatisation des usines : les machines effectuant le travail, les humains supervisant. Aujourd'hui, nous sommes confrontés à l'automatisation par agents IA : l'IA effectue le travail, les humains supervisent. Le contexte a changé, mais la logique sous-jacente demeure inchangée. Et les problèmes qu'elle soulignait dans son article se reproduisent. Quels problèmes ont été abordés dans l'article ? 1. Le dilemme de la dégradation des compétences : les compétences s’atrophient lorsqu’elles ne sont pas utilisées ; les compétences des experts diminuent lorsqu’ils deviennent superviseurs Nous comprenons tous le concept du « s'en servir ou le perdre ». Mais à l'ère de l'IA, il a une version bien plus brutale. Auparavant, vous étiez expert dans un domaine précis, que vous pratiquiez quotidiennement avec aisance. Désormais, l'entreprise vous dit : « Laissez l'agent IA s'en charger ; votre rôle consiste à le superviser et à intervenir uniquement en cas de problème. » Ça a l'air génial, non ? Passer d'employé à superviseur, ce serait plus simple, non ? Voici le problème : si vous arrêtez de faire cela, vos compétences non seulement ne progresseront pas, mais pourraient même se détériorer. En tant que développeur utilisant quotidiennement l'IA, je constate que mes progrès ont été minimes ces deux dernières années et que je suis devenu dépendant de cette technologie. De nombreuses lignes de code que j'écrivais auparavant sans effort sont désormais impossibles à réaliser sans elle. C'est vraiment un cas de « s'en servir ou le perdre ». OpenAI et Anthropic vantent toutes deux les mérites de leurs agents de codage, affirmant que leurs employés n'ont qu'à vérifier les résultats de l'IA. Cependant, elles omettent délibérément de préciser que ces personnes sont des experts hautement qualifiés, triés sur le volet et possédant une vaste expérience pour évaluer la précision de l'IA. Si, pendant les prochaines années, elles se contentent de vérifier le travail de l'IA, leurs compétences déclineront progressivement. Nous, les programmeurs plus âgés, on s'en sort bien, mais la génération suivante est dans une situation encore pire. Les programmeurs expérimentés d'aujourd'hui ont au moins acquis leur savoir-faire par la pratique. Qu'en sera-t-il des programmeurs de demain ? Ils observent l'IA depuis ses débuts, mais n'ont guère pratiqué. Ils manquent à la fois de compétences et d'opportunités d'apprentissage. Comment pourront-ils alors juger de la fiabilité de l'IA ? Le texte original de l'article était le suivant : La génération actuelle de systèmes d'automatisation repose sur les compétences des opérateurs de la génération précédente. Il est peu probable que la prochaine génération d'opérateurs possède ces compétences. Ce problème n'est peut-être pas apparent aujourd'hui, mais il pourrait le devenir dans trois à cinq ans. 2. Difficultés de récupération de la mémoire : La récupération des connaissances rarement utilisées est plus lente. Un autre problème réside dans la détérioration possible de la mémoire des compétences associées. Repensez à toutes ces formules que nous connaissions par cœur au lycée ; combien nous en souvenons-nous encore ? Dans un contexte d'intelligence artificielle supervisée, plus l'IA devient puissante, plus elle est précise. Cela signifie que, la plupart du temps, vos connaissances ne seront plus nécessaires. À mesure que vos connaissances seront moins utilisées, vos souvenirs associés s'estomperont. 3. Le paradoxe de la pratique : la formation théorique est inutile ; il faut apprendre par la pratique. Or, l’IA effectue le travail, et les humains n’ont plus l’occasion de s’exercer. À ce stade, vous vous demandez peut-être : cette formation est-elle utile ? Cependant, l'article intitulé « L'ironie de l'automatisation » conclut que la formation n'est pas très utile. Les compétences professionnelles ne s'acquièrent pas par des cours magistraux ; elles se perfectionnent par la pratique. Les théories apprises en classe sont souvent incompréhensibles sans exercices pratiques, faute d'un cadre expérientiel correspondant. Même si on les comprend au départ, on les oublie vite, car il n'existe aucun lien entre leur mémorisation et des situations concrètes. Pour maîtriser la supervision de l'IA, il est nécessaire de pratiquer régulièrement. Cependant, si l'objectif de l'entreprise est d'automatiser l'IA pour améliorer l'efficacité, les occasions de s'exercer seront rares. C'est un cercle vicieux. Comme indiqué dans l'article : Nous formons les opérateurs à suivre des instructions, puis nous les intégrons au système et attendons d'eux qu'ils fournissent des renseignements. On ne peut pas s'attendre à ce que les humains, qui n'ont généralement pas besoin de réfléchir ni de s'exercer, trouvent de bonnes solutions dans les moments critiques. 4. Surveiller la fatigue : les humains ne peuvent pas maintenir une vigilance constante sur des systèmes qui « font rarement des erreurs » pendant des périodes prolongées. Les recherches en psychologie ont depuis longtemps établi que l'être humain ne peut maintenir son attention longtemps sur une cible qui ne rencontre que rarement des difficultés ; la limite est d'une demi-heure. Il ne s'agit pas d'une question de volonté, mais d'une caractéristique physiologique. D'un point de vue évolutionniste, il s'agit en réalité d'un avantage pour la survie : si l'on fixe un point sans qu'il ne se passe rien, le cerveau diminue automatiquement son niveau d'alerte, préservant ainsi ses ressources attentionnelles pour faire face à de véritables menaces. Mais dans un contexte de surveillance, cela devient un problème. Les agents d'IA fonctionnent correctement la plupart du temps, mais il leur arrive de commettre des erreurs. C'est précisément ce type d'erreur qui est le plus difficile à surveiller. Si l'IA commet fréquemment des erreurs, la vigilance devient de mise. Si elle n'en commet jamais, aucune surveillance n'est nécessaire. Mais la situation où elle commet rarement des erreurs échappe totalement à l'attention humaine. Pire encore, les agents d'IA commettent des erreurs d'une manière particulièrement subtile. Au lieu de dire « Je ne suis pas sûr », ils exposent leur plan d'un ton extrêmement assuré, s'étirant sur des dizaines, voire des centaines de lignes. L'erreur peut se dissimuler dans une prémisse mineure à la ligne 87, comme « Puisque 2 est supérieur à 3, donc nous devrions… ». Noyée sous une telle quantité de contenu apparemment correct, et engourdie par ce ton assuré, elle passe inaperçue. Et pourquoi pas ajouter un système d'alarme automatique ? L'article indique : Qui surveille le système d'alarme ? Si le système d'alarme lui-même dysfonctionne, l'opérateur ne s'en apercevra pas car le système fonctionnera normalement depuis longtemps. Et si quelqu'un prenait des notes ? L'article affirme que les gens peuvent copier mécaniquement des nombres sans prêter attention à ce que représentent réellement ces nombres. Toutes les tentatives pour lutter contre la lassitude face à la surveillance se heurtent au même obstacle : l’attention humaine ne peut rester focalisée longtemps sur une cible qui cause rarement des problèmes. Il s’agit d’une limitation matérielle, et non d’un problème logiciel. 5. Problème de statut : La rétrogradation d'expert à superviseur a entraîné un choc psychologique et une baisse du statut social. Avant, vous étiez un expert ; vos collègues venaient vous voir pour le moindre problème, vous étiez respecté et vous aviez une forte identité professionnelle. Maintenant, vous êtes le gardien de l’IA. La perte de compétences est une chose, mais l'impact psychologique en est une autre. Passer du statut d'expert à celui de superviseur, de créateur à celui de relecteur, d'indispensable à celui de remplaçant : ce genre de transformation est difficile à accepter pour beaucoup. L'article indique que les personnes rétrogradées de cette manière présentent divers mécanismes d'adaptation complexes, dont certains semblent même contradictoires. Ce point étant trop long, nous invitons les personnes intéressées à consulter l'article original. 6. Mauvaise interface utilisateur : L’interface actuelle de l’agent IA représente la pire conception de surveillance. Le secteur de l'automatisation industrielle a consacré des décennies à optimiser la conception des salles de contrôle : comment agencer les écrans pour permettre aux opérateurs de détecter rapidement les anomalies, pourquoi le bouton d'arrêt d'urgence est rouge, pourquoi il est si grand et pourquoi il est placé à cet endroit précis. Chaque détail est le fruit des enseignements tirés des accidents. Examinons maintenant l'interface de l'agent IA. Des textes longs et assurés, des plans à plusieurs étapes les uns après les autres, des dizaines, voire des centaines de lignes d'explications interminables. Il vous faut dénicher l'erreur cachée dans tout ce texte. Il s'agit probablement de la pire interface de détection d'anomalies jamais conçue par l'humanité. 7. Le paradoxe de la formation : plus le système automatisé est performant, plus il faut investir dans la formation des humains. Cet article traite des problèmes de formation engendrés par l'automatisation : Si les opérateurs ne peuvent pas périodiquement prendre le relais et effectuer eux-mêmes les tâches, la formation sur simulateur est indispensable. Cependant, les simulateurs présentent un problème fondamental : ils ne permettent de simuler que les pannes prévisibles. Les pannes inconnues ne peuvent être simulées, et les pannes connues mais non rencontrées sont également difficiles à simuler avec précision. Que devons-nous faire alors ? La formation ne peut porter que sur les stratégies générales, et non sur les méthodes d'adaptation spécifiques. Or, cela soulève un nouveau problème : on ne peut pas s'attendre à ce que les opérateurs gèrent les anomalies en se basant uniquement sur le manuel d'utilisation, car celui-ci ne peut pas couvrir toutes les situations. Plus un système automatisé est performant, moins il nécessite d'intervention humaine, mais plus l'investissement dans la formation du personnel est important. Car moins il y a d'intervention, plus les compétences d'une personne se détériorent rapidement, plus sa capacité à faire face aux anomalies rares diminue et plus le coût de chaque séance de formation est élevé. Les décideurs souhaitent réaliser des économies grâce à l'IA, mais les économies réalisées sur les ressources humaines pourraient devoir être doublées en coûts de formation. 8. Dilemme du leadership : superviser l'IA ne consiste pas seulement à observer passivement, mais à la « diriger » activement. Superviser des agents d'IA ne consiste pas seulement à les observer passivement ; il s'agit de les diriger activement. De leur indiquer ce qu'ils doivent faire, ce qu'ils ne doivent pas faire, le nombre d'étapes à effectuer et comment ajuster leur trajectoire. Il s'agit en réalité d'une compétence de leadership. Pourquoi les managers sont-ils souvent les plus enthousiastes à propos des agents d'IA sur LinkedIn ? Parce qu'ils ont l'habitude de travailler indirectement : fixer des objectifs, attribuer des tâches, donner du feedback et ajuster la stratégie, sans pour autant réaliser le travail directement. Pour eux, diriger un agent d'IA revient au même que diriger des subordonnés. Mais pour ceux qui ont toujours tout fait eux-mêmes, c'est un renversement de situation radical. Il faut passer de celui qui fait les choses à celui qui délègue. Ce n'est pas un problème qui se résout en modifiant quelques invites ; il faut reconstruire entièrement les compétences. L'entreprise propose des formations au leadership aux managers nouvellement promus. Mais a-t-on déjà vu une entreprise proposer des formations au leadership aux superviseurs d'IA ? L'article d'il y a quarante ans se terminait ainsi : Les humains peuvent se révéler d'excellents résolveurs de problèmes lorsqu'ils ne sont pas soumis à la pression du temps. La difficulté réside dans le fait que leur efficacité chute drastiquement sous la contrainte du temps. J'espère que cet article permettra d'éclaircir deux points : premièrement, l'ironie est que l'automatisation n'élimine pas nécessairement les difficultés ; deuxièmement, la créativité technologique requise pour résoudre ces problèmes peut être supérieure à l'automatisation elle-même. Quarante ans plus tard, nous nous trouvons dans un contexte différent, mais nous sommes confrontés aux mêmes problèmes. Les agents d'IA progressent, mais les structures cognitives humaines demeurent inchangées. La surveillance de la fatigue ne dure toujours qu'une demi-heure, la dégradation des compétences reste liée à l'usage et au manque d'usage, et les angles morts de l'attention persistent. Ce sont des limitations matérielles, non des problèmes que les mises à jour logicielles peuvent résoudre. Lectures recommandées : « Les paradoxes de l’automatisation » : https://t.co/5HWoelLIkR « L’IA et les paradoxes de l’automatisation – Partie 1 » https://t.co/u27fpcCOWk « L’IA et les paradoxes de l’automatisation – 2e partie »

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.