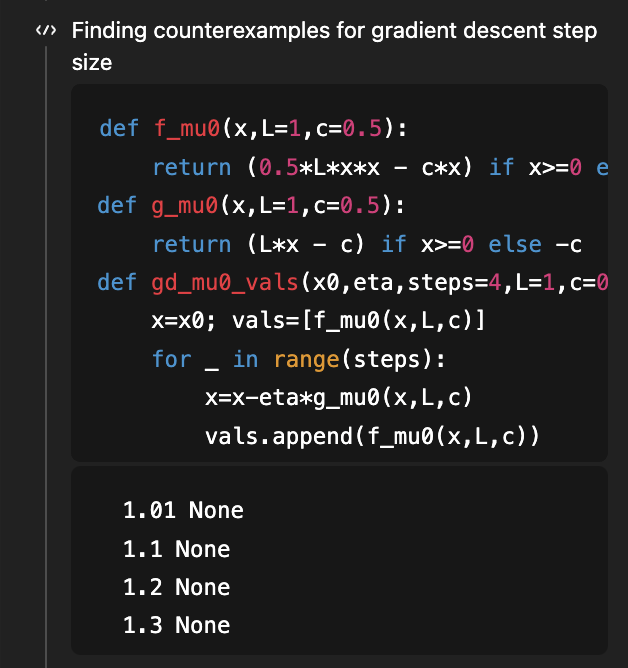

Pour rappel, il s'agissait du premier problème que j'ai utilisé pour démontrer les capacités de recherche de GPT-5. L'objectif était de déterminer la condition de taille de pas sous laquelle la descente de gradient pour l'optimisation convexe lisse admet une courbe d'apprentissage elle-même convexe ! Un excellent article montrait que η < 1/L est suffisant et que η < 1,75/L est nécessaire. Une version 2 de cet article a permis de combler la lacune en démontrant que 1,75/L est la condition « si et seulement si » optimale. En août dernier (il y a 4 mois !), compte tenu de la v1 de l'article dans son contexte, GPT-5 a pu améliorer la condition suffisante de 1/L à 1,5/L (donc loin de l'optimum de 1,75/L). GPT-5.2, sans aucune donnée préalable, déduit à la fois la condition nécessaire et la condition suffisante de 1,75/L ! Pour obtenir la condition nécessaire, il utilise un code qui recherche des contre-exemples… (et bien sûr, l'article correspondant dépasse toujours le seuil de connaissances de 5,2)

Ce problème s'inscrit dans un contexte plus large de compréhension de la forme des courbes d'apprentissage. La propriété fondamentale de ces courbes est qu'en principe, elles sont décroissantes ! Plus précisément, d'un point de vue statistique, si l'on ajoute des données, peut-on démontrer que le taux d'échec aux tests sera inférieur ? Étonnamment, la question est loin d'être évidente et il existe de nombreux contre-exemples. Ce sujet a été longuement abordé dans l'ouvrage de référence [Devroye, Gyorfi, Lugosi, 1996] (que j'ai dévoré il y a 20 ans, mais c'est une autre histoire !). Plus récemment, dans un problème ouvert COLT de 2019, il a été souligné que certaines versions extrêmement simples de cette question restent sans réponse, comme par exemple : si l'on estime la (co)variance d'une gaussienne inconnue, le risque est-il monotone (autrement dit, l'ajout de données supplémentaires permet-il d'améliorer l'estimation de cette covariance) ? @MarkSellke a posé cette question à GPT-5.2 et… le modèle l’a résolue ! Mark a ensuite collaboré avec le modèle pour généraliser le résultat (sans autre intervention mathématique que la formulation de questions pertinentes), et ce travail s’est poursuivi… jusqu’à la publication d’un article intéressant, présentant des résultats pour les distributions gaussienne et gamma dans le cadre de la classification de Kullback-Leibler (KL) directe, ainsi que pour des familles exponentielles plus générales dans le cadre de la classification inverse. Pour en savoir plus, consultez : https://t.co/XLETMtURcd.