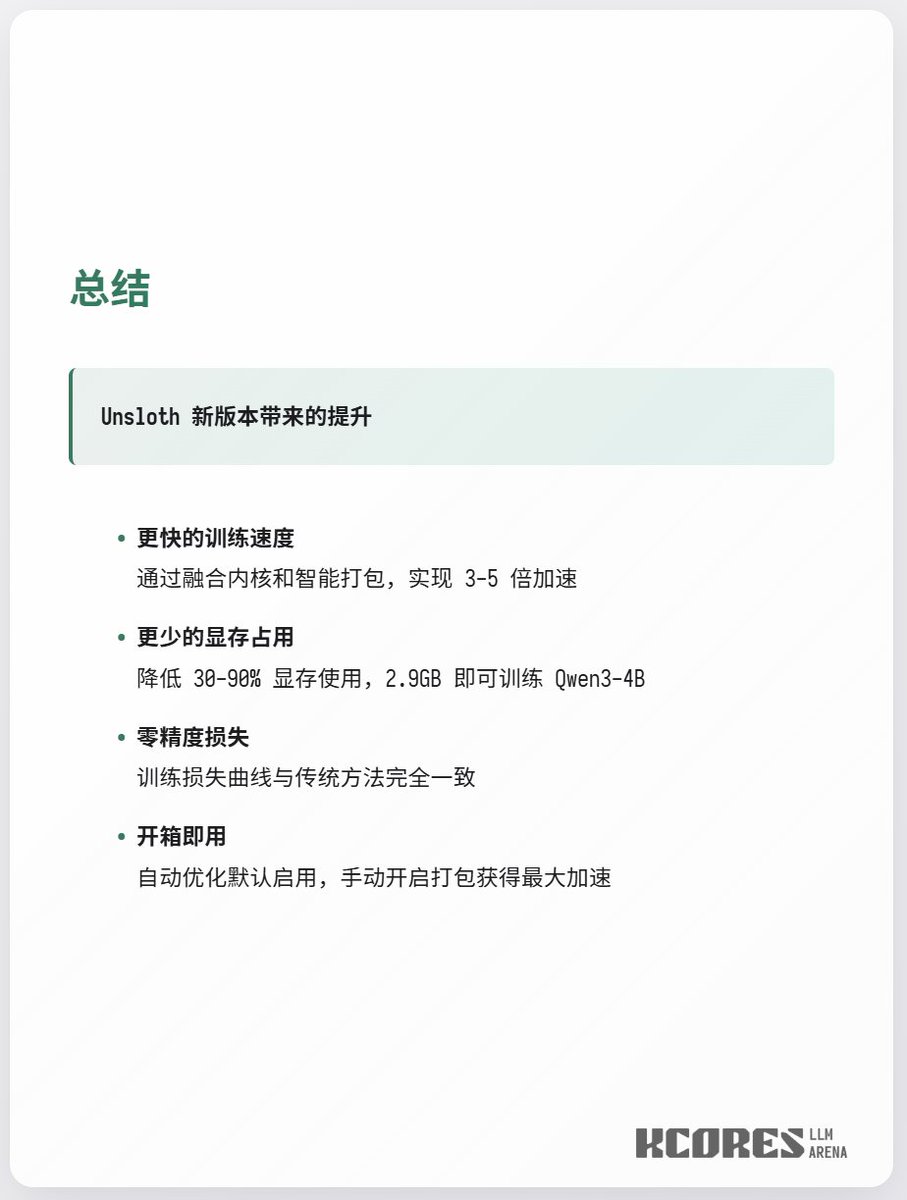

Unsloth remet ça, en entraînant Qwen3-4b avec 3 Go de VRAM. La dernière mise à jour d'Unsloth représente une amélioration majeure. Concrètement, les deux noyaux Triton initialement nécessaires pour Q et K ont été fusionnés en un seul, et la prise en charge des RoPE de longueur variable est désormais assurée. Ceci permet d'économiser une quantité importante de mémoire GPU et d'améliorer la vitesse de calcul (auparavant, Q et K nécessitaient deux noyaux Triton, désormais fusionnés en un seul), avec un gain de vitesse de 2,3x pour l'entraînement sur des contextes longs. De plus, il prend en charge les index int64 car les index int32 d'origine provoquaient des erreurs de dépassement de capacité CUDA lors de l'entraînement avec un contexte très large de 500 000. Par conséquent, une précision plus élevée a été utilisée pour éviter ces erreurs, permettant ainsi la prise en charge de contextes plus vastes.

Détails de mise en œuvre / 1

Détails de mise en œuvre / 2

Comment utiliser