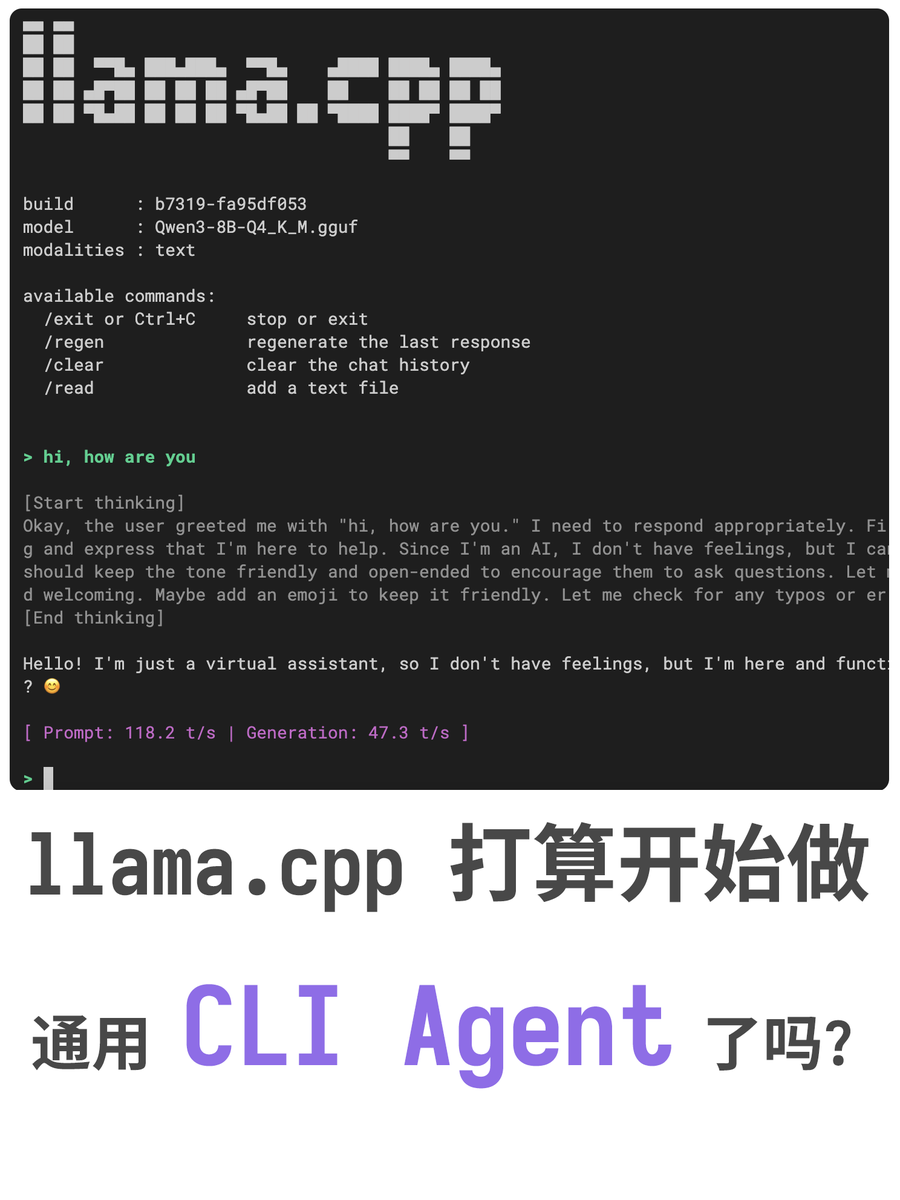

Le fichier llama.cpp vient d'être fusionné avec une nouvelle PR, qui optimise l'interface CLI, prend en charge le fonctionnement multimodal et révèle également les projets futurs concernant la prise en charge de la complétion de la ligne de commande, des téléchargements multimédias sur Internet, et plus encore. En réalité, llama.cpp est sur la bonne voie. Actuellement, il n'existe pas de solution définitive sous Linux/macOS concernant les shells IA, et il y aura certainement des distributions Linux basées sur l'IA à l'avenir, comme llama Linux. Si ce développement se poursuit dans cette direction, il deviendra l'infrastructure de la nouvelle ère. Je suis très optimiste quant aux futures versions de llama.cpp.

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.