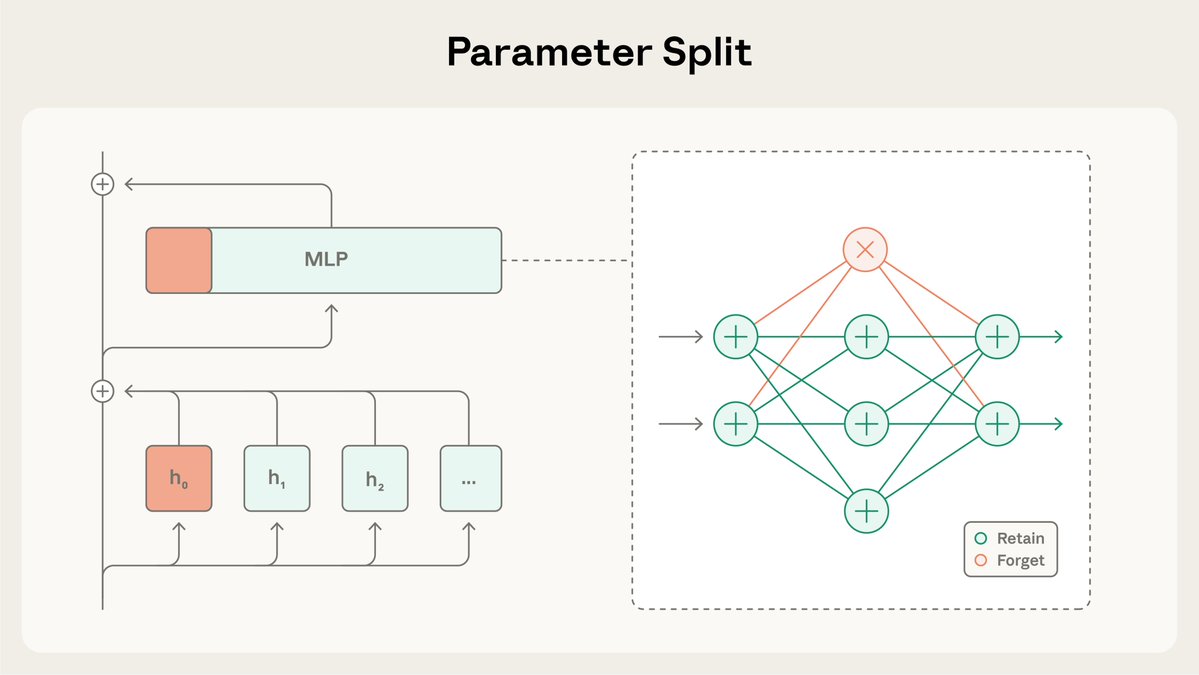

Nouvelles recherches du programme Anthropic Fellows : masquage sélectif par gradient (SGTM). Nous étudions comment entraîner des modèles de manière à ce que les connaissances à haut risque (par exemple sur les armes dangereuses) soient isolées dans un petit ensemble distinct de paramètres qui peuvent être supprimés sans affecter globalement le modèle.

SGTM divise les poids du modèle en sous-ensembles « à conserver » et « à oublier », et oriente les connaissances spécifiques vers le sous-ensemble « à oublier » lors du pré-entraînement. Ces connaissances peuvent ensuitalignment.anthropic.com/2025/selective… le déploiement dans des environnements à haut risque. Lire la suite : https://t.co/BfR4Kd86b0

Dans notre étude, nous avons testé si SGTM pouvait supprimer les connaissances biologiques des modèles entraînés sur Wikipédia. Le filtrage des données pourrait entraîner la fuite d'informations pertinentes, car des pages Wikipédia non consacrées à la biologie pourraient encore contenir des informations biologiques.

En contrôlant les capacités générales, les modèles entraînés avec SGTM sont moins performants sur le sous-ensemble indésirable de connaissances « oubliées » que ceux entraînés avec un filtrage des données.

Contrairement aux méthodes de désapprentissage qui interviennent après la fin de la formation, SGTM est difficile à annuler. Il faut 7 fois plus d'étapes de réglage fin pour récupérer des connaissances oubliées avec SGTM par rapport à une méthode de désapprentissage précédente, RMU.

L’étude présentait des limites : elle a été réalisée dans un cadre simplifié avec des modèles de petite taille et des évaluations indirectes plutôt que des points de référence standard. De même que pour le filtrage des données, SGTM n'empêche pas les attaques contextuelles où un adversaire fournit lui-même les informations.

Lisez l'article complet sur SGTM iarxiv.org/abs/2512.05648jX7hD Pour faciliter la reproductibilité, nous avons également mis le code cgithub.com/safety-researc…ion sur GitHub : https://t.co/zRmJYy6bDE.

Ces recherches ont été menées par @_igorshilov dans le cadre du programme Anthropic Fellows.