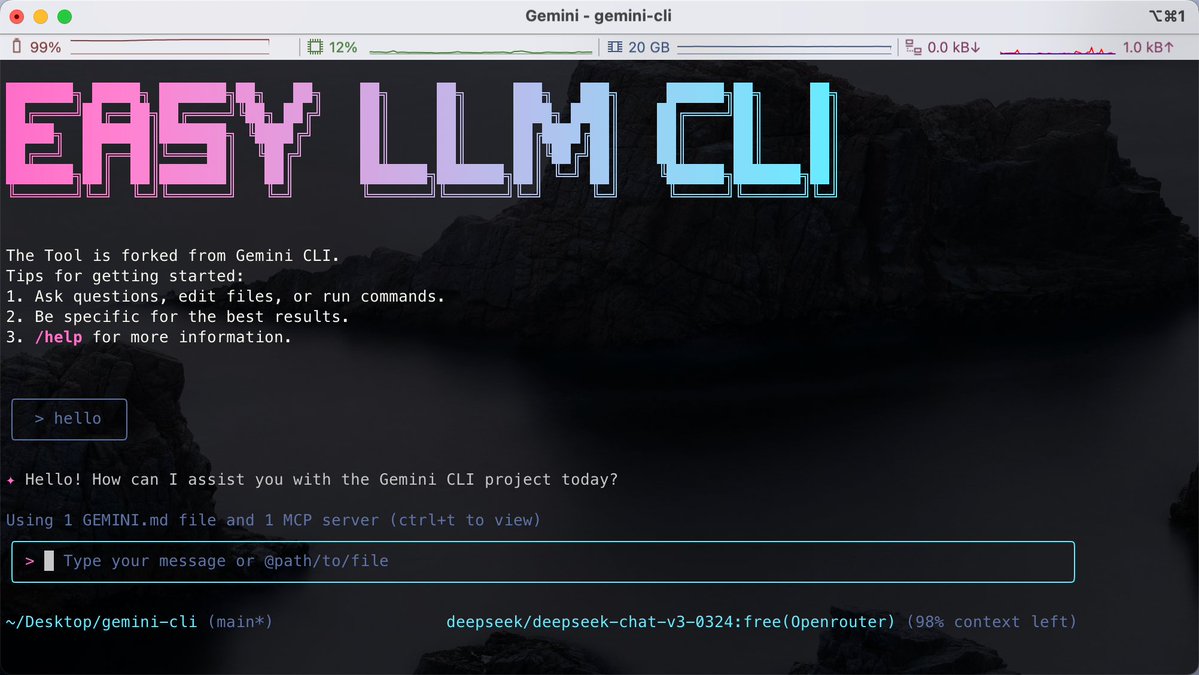

Pour ceux qui ont l'habitude d'écrire du code dans le terminal, la difficulté réside souvent dans le fait que différents outils d'IA sont liés à des modèles spécifiques, ce qui rend difficile de passer facilement d'un modèle complexe à un autre au sein d'une même interface de ligne de commande. J'ai découvert le projet open-source Easy LLM CLI sur GitHub. Il s'agit d'un développement dérivé de Google Gemini CLI, mais il s'affranchit des limitations d'un modèle unique. Il est compatible avec de nombreux modèles tels que Gemini, OpenAI, Claude et DeepSeek, et prend même en charge l'accès aux modèles locaux via Ollama. Il prend non seulement en charge le protocole MCP (Model Context Protocol) pour étendre les capacités de l'outil, mais peut également lire directement le contexte du dépôt de code pour nous aider à effectuer automatiquement des opérations Git, à refactoriser le code ou à générer des applications. GitHub : https://t.co/MofOBwdQdw Il nécessite un environnement Node.js et peut être exécuté directement avec npx sans installation. Vous pouvez personnaliser le moteur de rendu que vous souhaitez utiliser grâce à une simple configuration des variables d'environnement. Cela convient aux développeurs qui ne souhaitent pas être liés à un fournisseur spécifique et qui préfèrent gérer efficacement leurs tâches sur le terminal.

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.