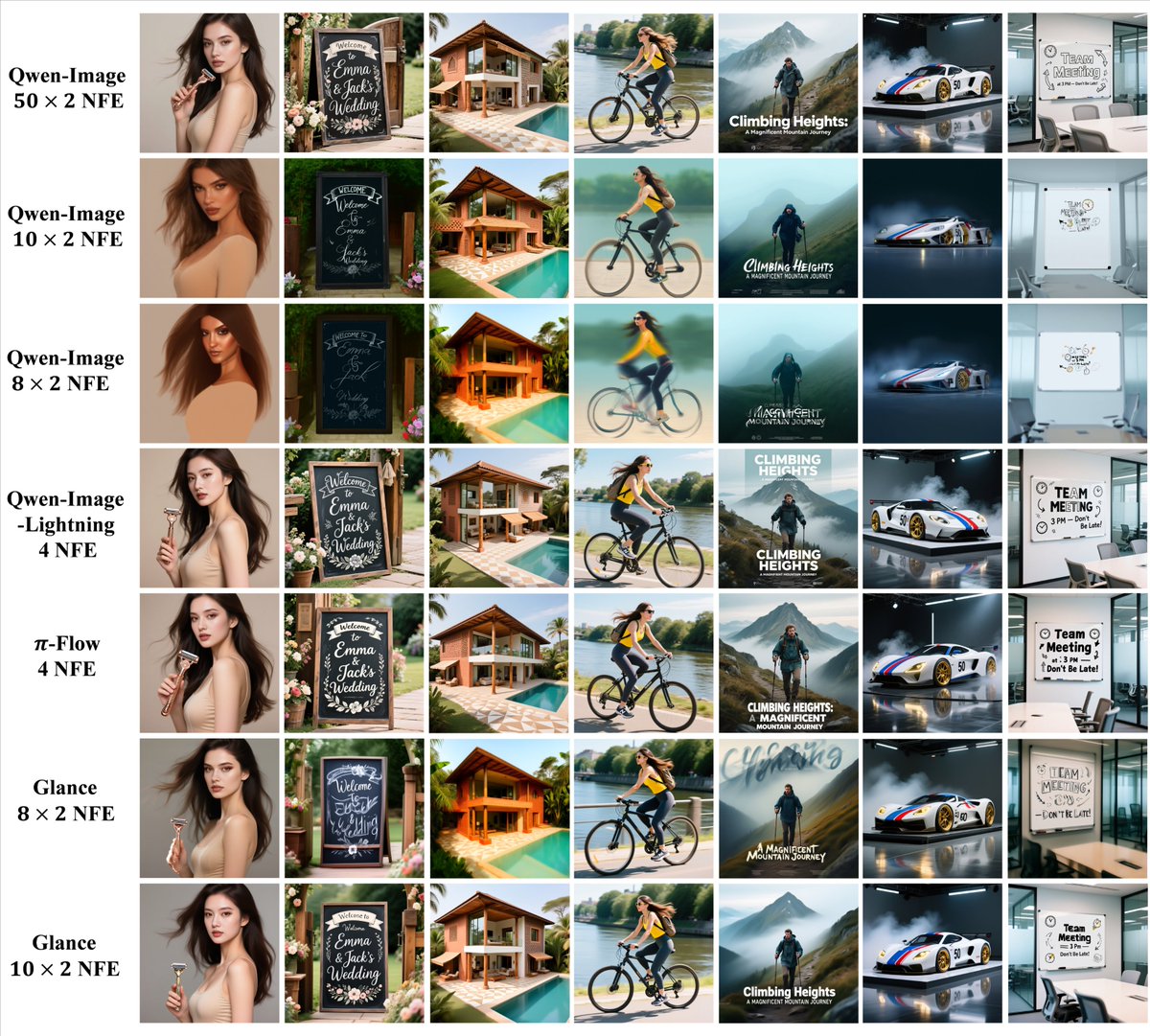

Ce projet est intéressant. Glance est une méthode d'accélération prenant en compte l'étape, capable d'accélérer considérablement l'inférence de modèles de diffusion (jusqu'à 5 fois) avec très peu de données (1 échantillon) et un coût d'entraînement très faible grâce à des « experts LoRA en deux étapes », tout en maintenant la qualité de la génération. On peut considérer les modèles actuels de cartographie de diffusion (tels que la diffusion stable) comme suit : « Commencez par un bruit pur, effacez-le lentement, puis effacez progressivement la peinture. » La question est : Pour obtenir une image de bonne qualité, il faut généralement l'« effacer » des dizaines, voire des centaines de fois, en exécutant un modèle complexe à chaque fois. Ce processus est à la fois long et gourmand en ressources graphiques, ce qui explique pourquoi beaucoup pensent : « La qualité est excellente, mais c'est beaucoup trop lent. » Les stratégies d'accélération précédentes impliquaient principalement : Réentraîner un « modèle étudiant » pour apprendre à dessiner en moins d'étapes nécessite beaucoup de données d'entraînement et de puissance de calcul, et est également sujet à une « fuite des cerveaux » (mauvaise généralisation). Glance a adopté une approche différente : Au lieu de compresser toutes les étapes de manière uniforme, nous observons : Les premières étapes sont cruciales pour définir la structure et le contenu général. Les étapes suivantes se concentrent davantage sur le peaufinage des détails et l'élimination des éléments superflus ; une grande partie de ce travail est « redondante ». Ils ont donc mis en œuvre une approche d’« accélération progressive » : Ajoutez deux plugins LoRA légers au modèle : Slow-LoRA : Utilisé dans la première moitié, il permet une approche « lente et régulière », minimisant les sauts et garantissant que la composition et la sémantique restent intactes. Fast-LoRA : Utilisé dans la seconde moitié du jeu, il permet de gagner du temps et d’effectuer des sauts audacieux afin de réduire les calculs. Ces deux algorithmes LoRA peuvent être entraînés sur une seule image V100 en utilisant une seule image d'exemple en une heure environ, ce qui rend le coût d'entraînement négligeable. s'avérer: Par rapport au modèle original, la vitesse d'inférence peut être multipliée par 5, mais la qualité des graphes générés sur différents ensembles de test reste fondamentalement la même que celle du modèle original, sans déclin notable.

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.