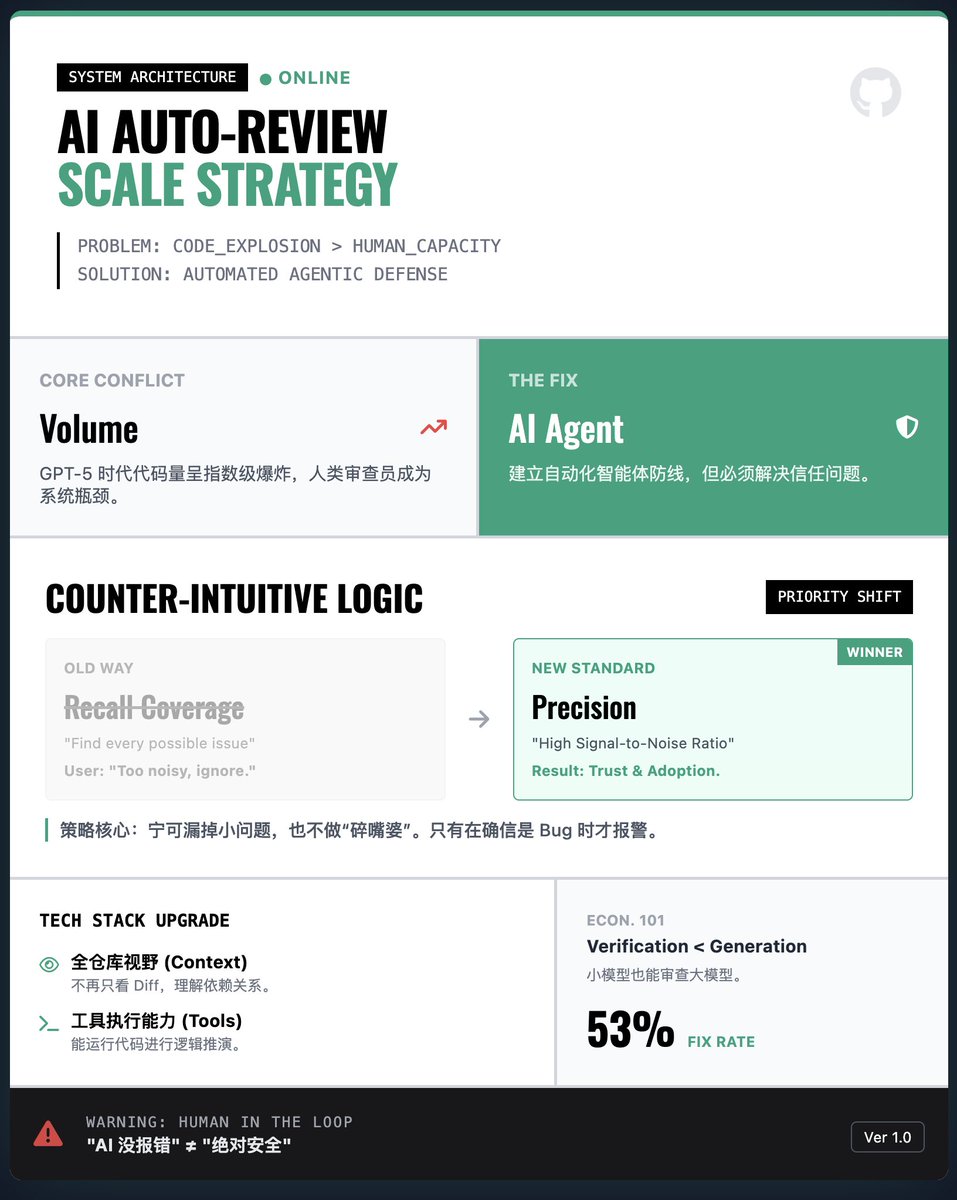

Comment OpenAI construit-elle un système de revue de code automatisé par l'IA à grande échelle ? Principaux défis : Explosion du volume de code face aux goulets d’étranglement des ressources humaines. Avec la croissance exponentielle du code généré par l’IA (comme GPT-5-Codex), il est impossible pour les humains de le vérifier ligne par ligne. Se fier uniquement à la génération par l’IA sans vérification rendra difficile le contrôle des vulnérabilités et des bogues. C’est pourquoi OpenAI propose la mise en place d’un agent de revue de code automatisé comme ligne de défense. Stratégie clé : privilégier la précision à la couverture (contre-intuitif !) • La logique habituelle est la suivante : on s'attend à ce que l'IA détecte tous les problèmes potentiels. • Constat d’OpenAI : Dans le domaine de l’ingénierie réelle, si l’IA signale de nombreux problèmes insignifiants ou non pertinents, comme une « bavarde », les développeurs abandonneront tout simplement l’outil. Solution : Afin de gagner la confiance des développeurs, le système a été conçu selon le principe de « la qualité plutôt que la quantité », privilégiant un rapport signal/bruit élevé et n'émettant des alertes que lorsqu'il est certain qu'un bogue est critique, même au risque de manquer certains problèmes mineurs. Percée technologique : contexte complet du référentiel et utilisation des outils • Les premiers modèles de validation se basaient généralement uniquement sur les différences de code, sans tenir compte du contexte. Le nouvel agent d'analyse dispose d'une vue complète du dépôt et de la capacité d'exécuter du code. Cela signifie qu'il ne se contente pas de « voir » le code, mais peut également effectuer des déductions logiques basées sur les dépendances de l'ensemble du projet, améliorant ainsi considérablement la précision de l'analyse. Perspective économique : la validation est moins coûteuse que la génération. L’article fait une observation intéressante : générer du code correct exige beaucoup de ressources informatiques, tandis que la validation du code n’en requiert généralement que très peu. Même avec un budget informatique relativement modeste, les agents de censure peuvent efficacement détecter la plupart des erreurs générées par des modèles performants. Ceci justifie économiquement un déploiement à grande échelle. Applications pratiques et mises en garde : Résultats concrets : Ce système a été largement utilisé au sein d’OpenAI et sur GitHub. Les données montrent qu’environ 53 % des commentaires de l’IA ont été adoptés par les développeurs et utilisés pour modifier leur code, ce qui démontre la grande valeur de ses suggestions. • Risque de dépendance excessive : l’analyse par IA n’est qu’une « assistance », et non un « remplacement ». Les équipes doivent se prémunir contre l’écueil de croire que l’absence de signalement d’erreurs par l’IA garantit une « sécurité absolue ». Rapport de lecture

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.