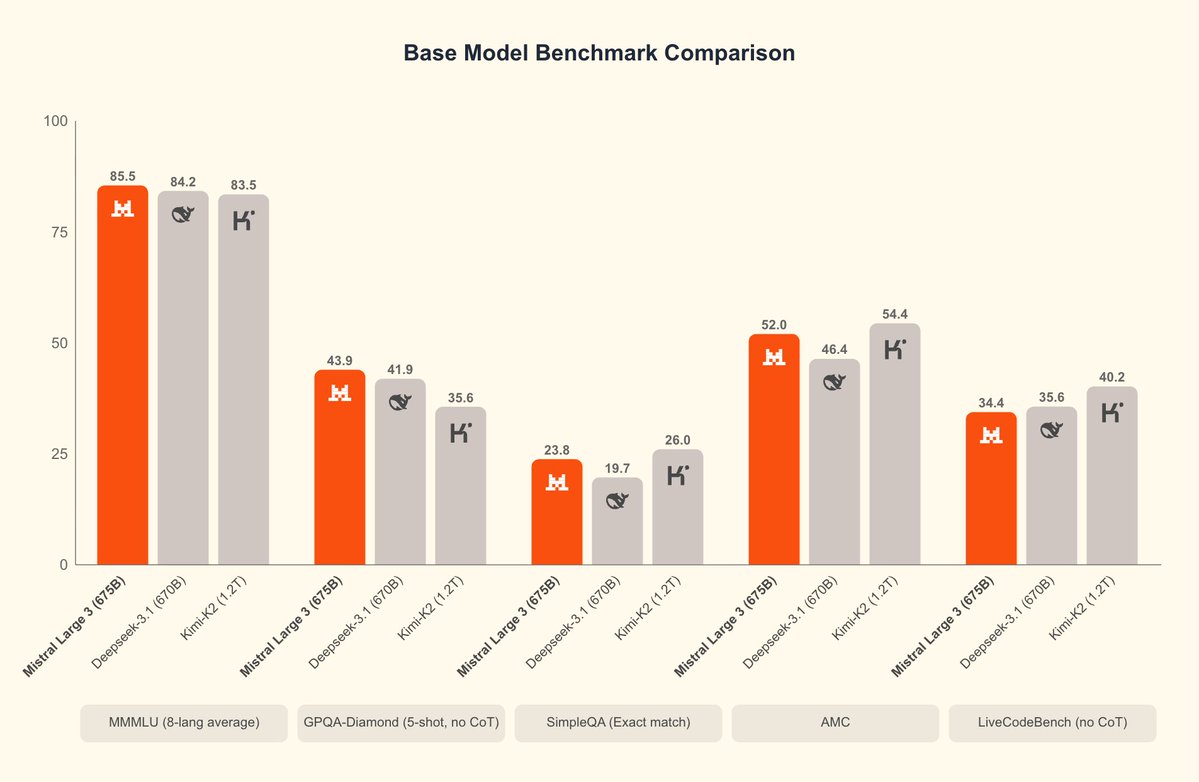

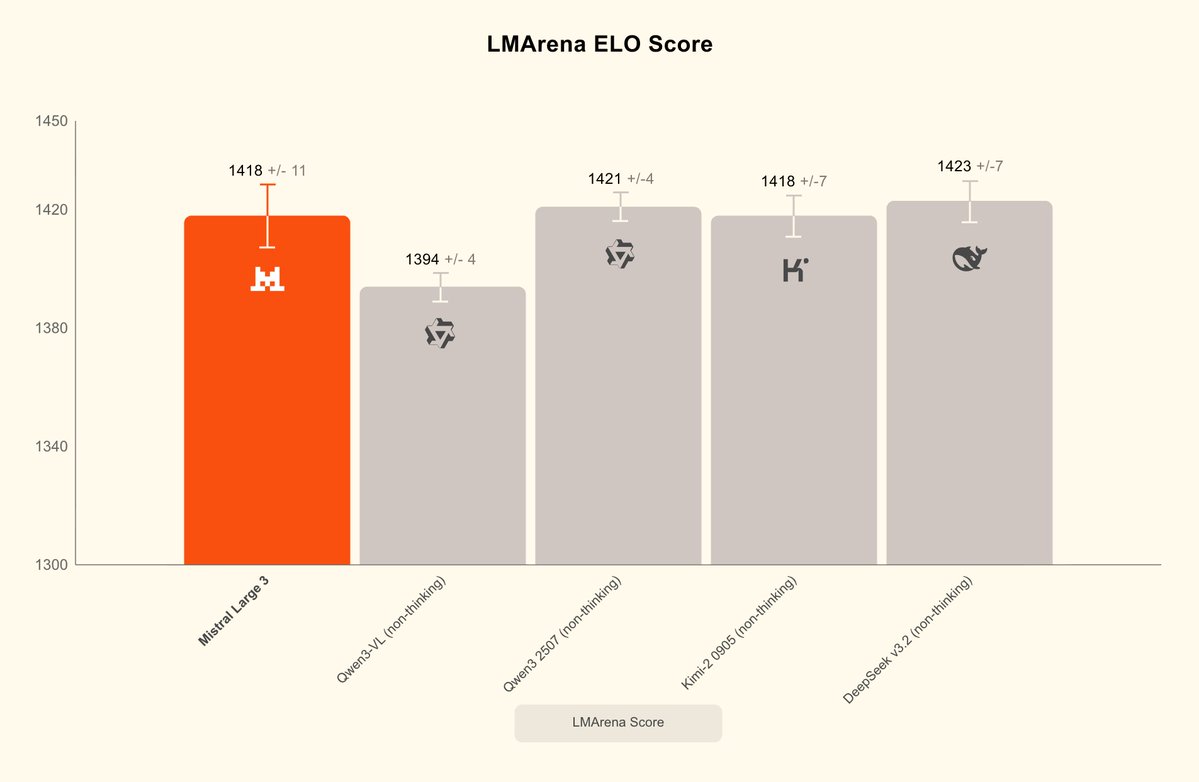

Mistral vient de sortir Mistral 3, ainsi que son MoE surdimensionné le plus puissant : Mistral Large 3, qui excelle dans la compréhension d'images et le dialogue multilingue. Mistral Large 3, nombre total de paramètres 675B, activation 41B, libère simultanément les poids de base et les poids induits ; la version d'inférence sera publiée ultérieurement. Fournit le format de compression NVFP4, permettant une inférence à haute efficacité sur un seul nœud avec 8×A100/H100 ou Blackwell NVL72, et prend en charge TensorRT-LLM, SGLang, la séparation pré-remplissage/décodage, le décodage spéculatif, etc. La série Ministral 3 comprend trois modèles. Les modèles 3B, 8B et 14B offrent chacun trois variantes : base, instruction et raisonnement, et tous prennent en charge l'entrée d'images. Il offre le meilleur rapport performance/prix de sa catégorie, égalant les performances de modèles similaires tout en générant un nombre de jetons nettement inférieur. La version de raisonnement peut atteindre 85 % AIME '25 sur 14B. #Mistral3 #MistralLarge3

Blomistral.ai/news/mistral-3STmAhuggingface.co/collections/mi…FYKgF3J