L'amour vient de France, le modèle Mistral 3 Large est disponible ! Cependant, il semblerait qu'il soit arrivé en retard ? Cette fois, Mistral 3 Large a finalement été mis à jour vers l'architecture MoE, avec un total de 675 milliards de paramètres, 41 milliards de paramètres d'activation et une longueur de contexte de 256 Ko. Ils l'ont testé eux-mêmes et ont constaté que le modèle de base était plus performant que DeepSeek-V3.1. Cependant, j'ai encore quelques doutes car la série Mistral ne m'avait pas particulièrement impressionné lors de mes tests précédents. Par ailleurs, les Ministral 14B, 8B et 3B ont également été commercialisés simultanément. L'équipe officielle les a comparés directement aux modèles Qwen3 présentant des paramètres de taille similaires. Si de nombreux étudiants sont intéressés, j'envisagerai de faire passer un test simple à tout le monde.

Paramètres du modèle / 1

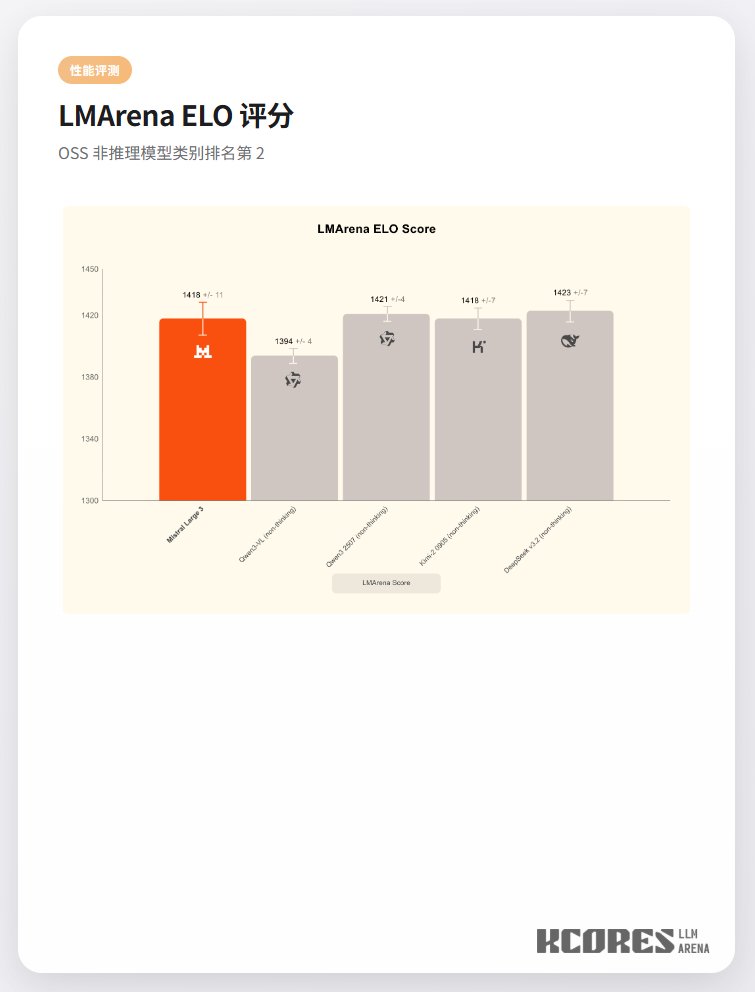

Performances du modèle