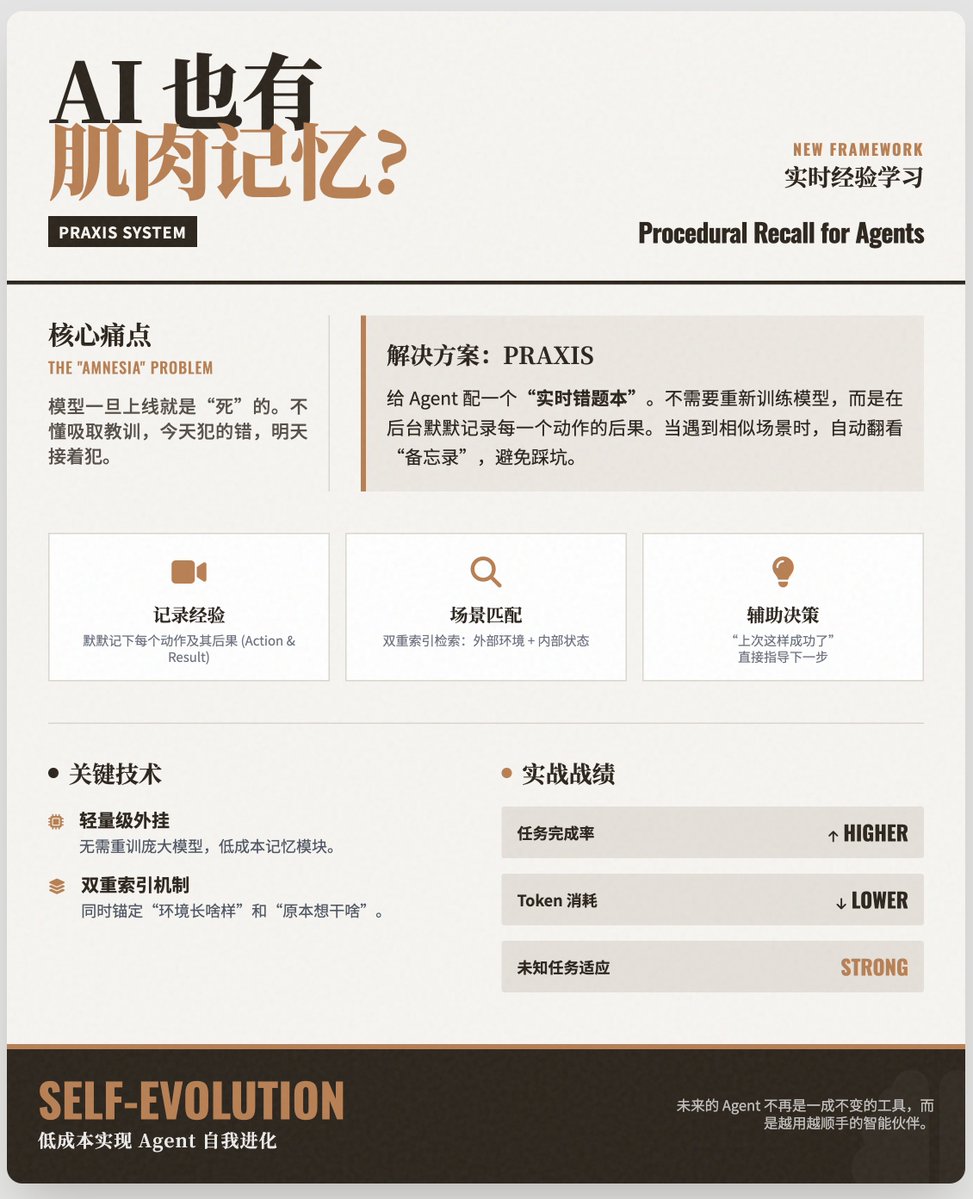

Donner à l'IA une « mémoire musculaire » : comment les agents peuvent-ils apprendre en temps réel et devenir plus intelligents grâce à l'expérience d'« indexation d'état » ? Point faible majeur : l’« amnésie » des agents d’IA Bien que les agents d'IA actuels soient intelligents, ils présentent généralement un défaut fatal : ils ne peuvent pas apprendre après leur déploiement. • Le modèle est « mort » : une fois entraîné et déployé, ses connaissances sont figées. • Absence de leçons tirées des erreurs : si un agent ne parvient pas à fonctionner sur une page Web complexe aujourd’hui, il risque de commettre la même erreur lorsqu’il rencontrera la même page Web demain. • Absence de « mémoire musculaire » : les humains acquièrent des compétences par « essais et erreurs » (connaissances procédurales), tandis que les agents d’IA manquent souvent de ce mécanisme d’accumulation de compétences à partir de l’expérience en temps réel. Solution : Système PRAXIS Pour résoudre ce problème, les auteurs ont proposé un nouveau mécanisme appelé PRAXIS (Procedural Recall for Agents with eXperiences Indexed by State). On peut considérer PRAXIS comme le « journal d'erreurs en temps réel » ou le « mémo d'expérience » d'un agent : • Enregistrement de l'expérience : Lorsque l'agent effectue une tâche, PRAXIS enregistre silencieusement en arrière-plan chacune de ses actions et leurs conséquences. • Correspondance de scènes : Lorsque l'agent rencontre à nouveau une scène similaire (état environnemental + état interne), PRAXIS récupérera rapidement les expériences passées. • Aide à la décision : Elle indique à l’agent : « Hé, cliquer sur ce bouton sur cet écran la dernière fois a réussi (ou échoué) », guidant ainsi directement l’agent vers un meilleur choix. Points techniques clés : Module d’extension léger : PRAXIS ne nécessite pas de réentraînement des grands modèles ; il s’apparente davantage à un module de mémoire externe à faible coût. • Double indexation : elle prend en compte non seulement l'environnement externe (comme l'apparence d'une page web), mais aussi l'état interne de l'agent (comme le forfait actuel), garantissant ainsi la précision de la mise en correspondance des expériences. Résultats expérimentaux : Un succès retentissant pour la tâche de navigation Web. L’équipe de recherche a évalué les résultats sur le banc d’essai REAL Web Browsing Benchmark, et les résultats montrent que : • Taux d'exécution des tâches plus élevé : les agents équipés de PRAXIS peuvent effectuer des tâches complexes sur les pages Web avec une plus grande précision. • Plus rentable : en évitant les détours et en réduisant les tentatives inefficaces, la consommation de jetons et les coûts d'exploitation sont considérablement réduits. • Grande adaptabilité : Pour les tâches inédites, tant que l'environnement est similaire, l'agent peut résoudre le problème par analogie avec son expérience passée. Implications et conclusions pour l'industrie : Cet article propose une voie peu coûteuse permettant aux agents d'IA d'atteindre une « auto-évolution ». • Dites adieu à l’intelligence « ponctuelle » : les agents du futur ne seront plus des outils immuables, mais des assistants qui deviendront plus pratiques et intelligents à mesure qu’ils seront utilisés. • Gestion des environnements dynamiques : notamment dans les scénarios où l’interface change fréquemment, comme la navigation Web et l’utilisation de logiciels, le mécanisme PRAXIS permet à l’agent de s’adapter rapidement à la nouvelle version de l’interface utilisateur, comme un humain, sans avoir à attendre que le fabricant du modèle publie une nouvelle version. papier

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.