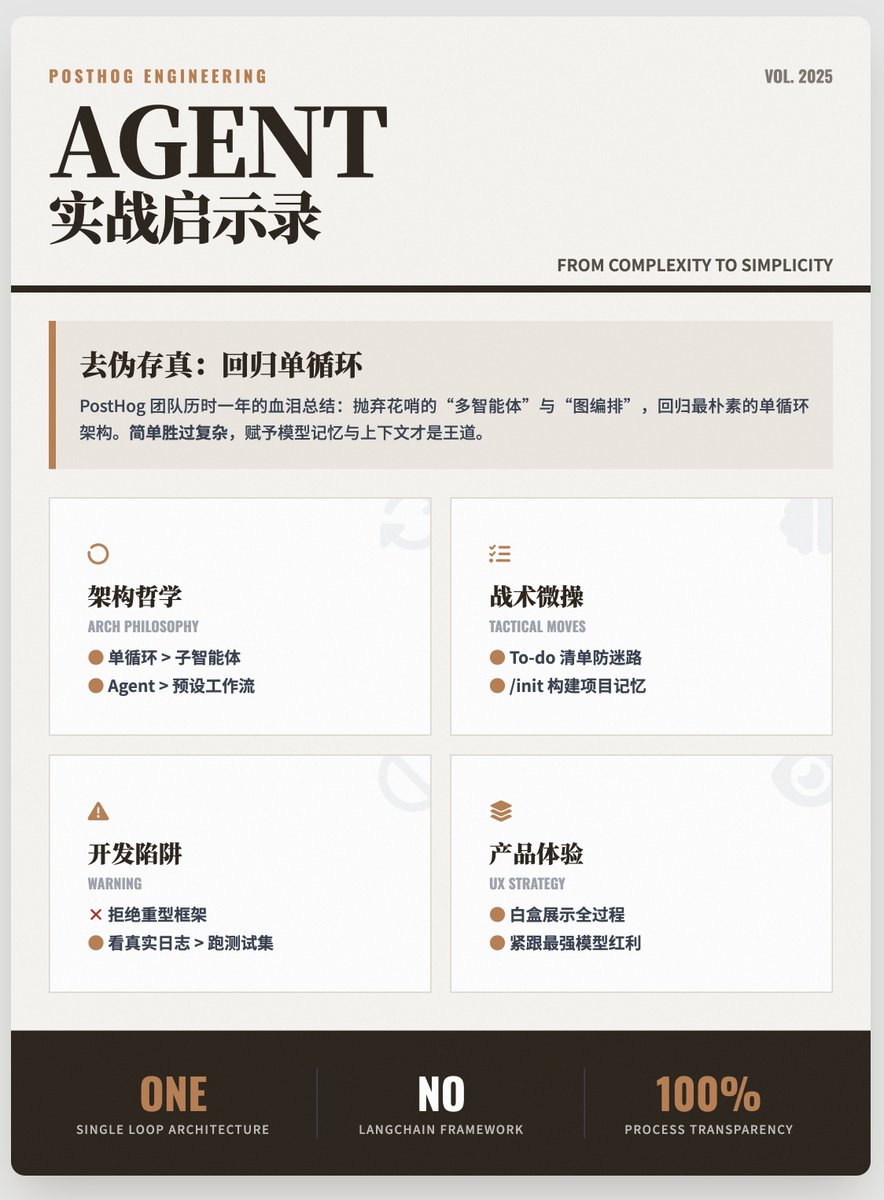

Une année d'expérience pratique dans le développement d'agents d'IA de qualité professionnelle, partagée par l'équipe @posthog Examinons cela sous quatre angles : philosophie architecturale, mise en œuvre tactique, pièges du développement et expérience produit. I. Philosophie architecturale fondamentale : La simplicité est préférable à la complexité. Les agencements complexes sont souvent non seulement inutiles, mais aussi nuisibles. 1. L'agent est supérieur au flux de travail. Idée fausse : à ses débuts, l'industrie a popularisé l'utilisation de graphes ou de flux de travail prédéfinis pour contrôler l'IA, croyant que cela la rendrait plus contrôlable. • Réalité : Cette approche est extrêmement fragile face à des tâches ouvertes. Dès que l’IA s’écarte du chemin prédéfini, elle est non seulement incapable de se corriger, mais elle perd également le contexte. Conclusion : L’architecture actuelle se réduit à une simple boucle unique. Le LLM s’exécute, se vérifie et s’auto-corrige en continu au sein de cette boucle jusqu’à la fin de la tâche. 2. Une boucle à entité unique est supérieure à une architecture à sous-agents. Idée reçue : beaucoup aiment concevoir des architectures complexes à « sous-agents ». En réalité, chaque couche d'abstraction et de spécialisation supplémentaire entraîne une perte significative de contexte. Le modèle a besoin d'informations globales complètes pour prendre des décisions optimales. Conclusion : Une seule boucle LLM dotée d'un ensemble d'outils simples est souvent plus performante et plus efficace qu'un groupe de sous-agents ayant chacun leur propre rôle. II. Mise en œuvre tactique clé : permettre au modèle de « se concentrer » et de « comprendre » Deux techniques de « microgestion » extrêmement pratiques : 1. La liste des tâches est un atout précieux. Pour éviter que l'agent ne se « perde » dans des tâches trop longues, ils ont introduit un outil apparemment superflu appelé todo_write. Il s'agit en réalité d'une « chaîne mentale » renforcée. L'agent met à jour cette liste après chaque étape, ce qui l'oblige à renforcer continuellement l'objectif suivant, améliorant ainsi considérablement le taux d'achèvement des tâches. 2. Le contexte est essentiel. Les questions des utilisateurs sont souvent ambiguës (fautes d'orthographe ou terminologie interne, par exemple). Sans contexte, l'IA ne peut pas les comprendre correctement. Ils se sont inspirés de l'approche de Claude Code et ont introduit la commande `/init`. Grâce à la recherche et à l'analyse web, ils ont constitué une mémoire au niveau du projet pour l'agent, permettant ainsi à l'IA de véritablement « comprendre » l'activité de l'utilisateur. III. Pièges du développement : Attention à deux avertissements très clairs : Les cadres et l’évaluation ne reposent que sur la théorie. 1. Rejeter la dépendance excessive aux frameworks. Ils ont explicitement déclaré regretter d'avoir utilisé LangChain et LangGraph. Les modèles d'IA évoluent à une vitesse fulgurante, et les frameworks lourds peinent souvent à suivre le rythme, devenant au contraire un fardeau. Il est donc conseillé de maintenir le code à un « bas niveau », car l'appel direct aux API constitue souvent l'approche la plus flexible et la plus durable. 2. Les évaluations ne sont pas une solution miracle. Bien que les ensembles de test soient importants, la complexité du monde réel (données erronées, parcours utilisateurs inhabituels) dépasse largement la couverture des ensembles de test. Ils ont souligné l'importance de l'« Heure des traces » (examen humain régulier des journaux d'activité réels). Comprendre comment les utilisateurs réels interagissent avec l'IA est plus précieux que de réaliser une suite de tests parfaite. IV. Expérience produit et stratégie de modèle 1. Présentez l'intégralité du processus. Ne cherchez pas à faire de l'IA une boîte noire parfaite. Les utilisateurs font davantage confiance à une IA transparente. PostHog AI choisit d'afficher tous les appels d'outils, les processus de raisonnement et même les tentatives infructueuses. Cette transparence totale renforce la confiance des utilisateurs et facilite l'identification des problèmes. 2. Tirer parti de l'évolution des modèles : La solution actuelle consiste à utiliser Claude Sonnet 4.5 pour la boucle principale et OpenAI o4-mini pour l'inférence et la génération de requêtes complexes. Toutefois, les développeurs doivent toujours se préparer à l'arrivée d'un modèle plus performant. Résumer L'expérience de PostHog au cours de l'année écoulée peut se résumer ainsi : séparer le bon grain de l'ivraie. Ils ont abandonné les approches apparemment sophistiquées mais en réalité complexes de « collaboration multi-agents », d'« orchestration de graphes complexes » et de « frameworks de développement lourds » des débuts de l'IA, pour revenir à une architecture simple à boucle unique. En dotant le modèle de souvenirs plus précis (tâches à accomplir), d'un contexte plus riche et d'interactions plus transparentes, ils ont créé un assistant IA véritablement performant. Adresse du blog

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.