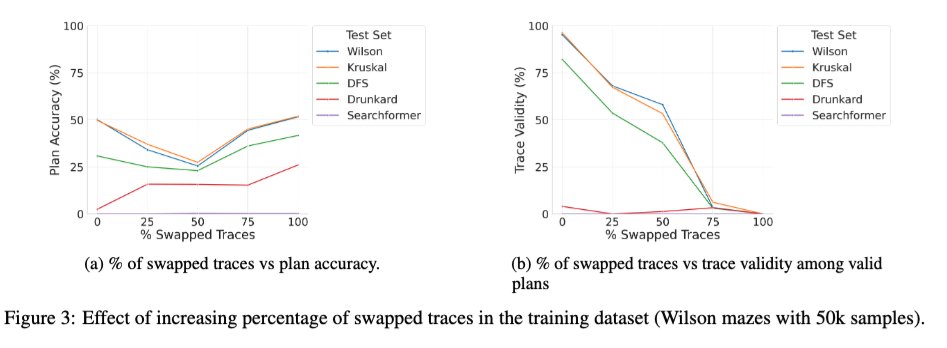

Nous venons de publier sur arXiv une version enrichie de l'article « Beyond Semantics » (notre étude systématique du rôle des jetons intermédiaires dans les LRM), qui pourrait intéresser certains d'entre vous. 🧵 1/ Une nouvelle étude intéressante porte sur l'effet de l'entraînement du transformateur de base avec un mélange de traces correctes et incorrectes. On observe que lorsque le pourcentage de traces incorrectes (interverties) pendant l'entraînement passe de 0 à 100 %, la validité des traces des modèles lors de l'inférence diminue de façon monotone (graphique de droite ci-dessous), comme prévu. Cependant, la précision de la solution présente une courbe en U (graphique de gauche) ! Cela suggère que ce qui importe, c'est la « cohérence » des traces utilisées pendant l'entraînement plutôt que leur exactitude.

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.