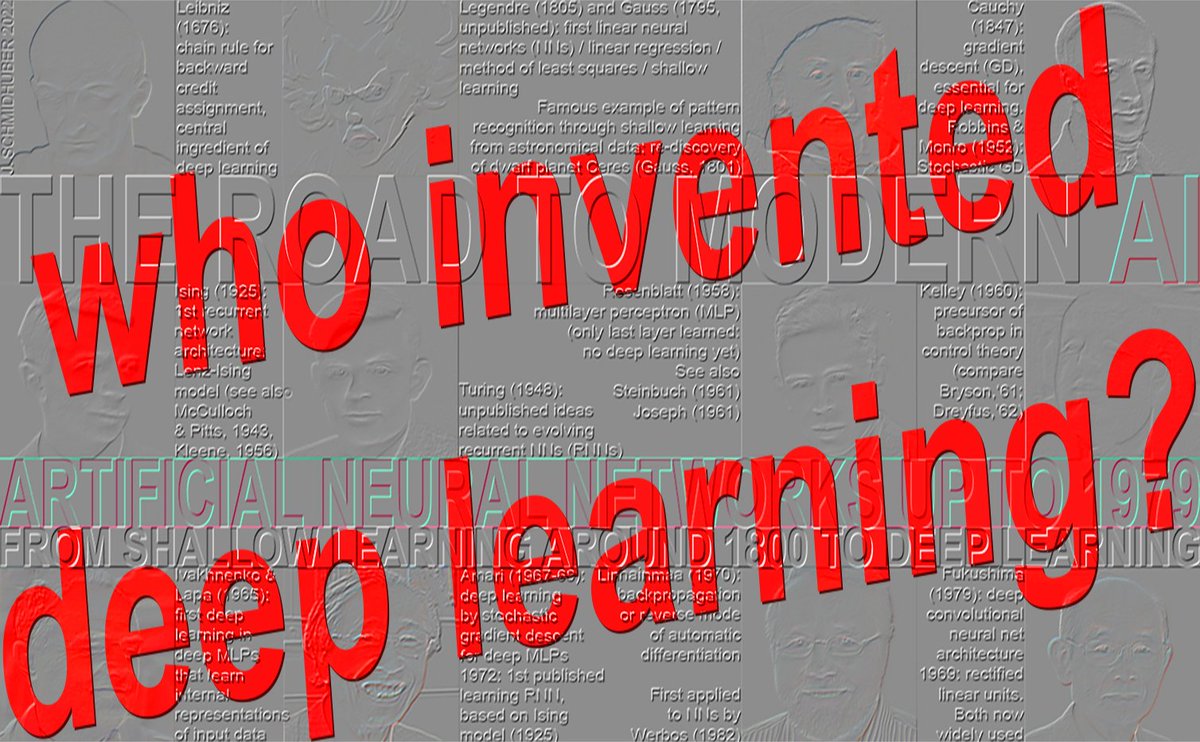

Qui a inventé l'apprentissagpeople.idsia.ch/~juergen/who-i…o/aJfpTfQSNk Chronologie: 1965 : premier apprentissage profond (Ivakhnenko & Lapa, 8 couches en 1971) 1967-68 : apprentissage profond de bout en bout par descente de gradient stochastique (Amari, 5 couches) 1970 : rétropropagation (Linnainmaa, 1970) pour les réseaux de neurones (Werbos, 1982) : rarement >5 couches (années 1980) 1991-1993 : pré-entraînement non supervisé pour les réseaux de neurones profonds (Schmidhuber, autres, plus de 100 couches) 1991-2015 : apprentissage résiduel profond (Hochreiter, autres, plus de 100 couches) 1996- : apprentissage profond sans gradients (plus de 100 couches) ★ 1965 : premier apprentissage profond (Ivakhnenko & Lapa, 8 couches en 1971) L'apprentissage réussi dans les architectures de réseaux à propagation directe profonde a commencé en 1965 en Ukraine (alors en URSS) lorsqu'Alexey Ivakhnenko et Valentin Lapa ont introduit les premiers algorithmes d'apprentissage généraux et fonctionnels pour les perceptrons multicouches profonds (MLP) ou les réseaux de neurones à propagation directe (FNN) avec de nombreuses couches cachées (contenant déjà les portes multiplicatives désormais populaires) [DEEP1-2][DL1-2][DLH][WHO5]. Un article de 1971 [DEEP2] décrivait un réseau d'apprentissage profond avec 8 couches, entraîné par leur méthode très citée qui était encore populaire dans le nouveau millénaire [DL2]. À partir d'un ensemble d'entraînement composé de vecteurs d'entrée et de leurs vecteurs de sortie cibles correspondants, les couches sont construites et entraînées progressivement par analyse de régression. Lors d'une phase d'ajustement fin, les unités cachées superflues sont éliminées par régularisation à l'aide d'un ensemble de validation distinct [DEEP2][DLH]. Ceci simplifie le réseau et améliore sa capacité de généralisation sur des données de test non vues. Le nombre de couches et d'unités par couche est déterminé en fonction du problème. Il s'agit d'une généralisation performante du réseau de neurones de Gauss-Legendre à deux couches (1795-1805) [DLH]. Autrement dit, Ivakhnenko et ses collègues ont développé le connexionnisme avec des couches cachées adaptatives deux décennies avant que le terme « connexionnisme » ne se popularise dans les années 1980. À l’instar des réseaux de neurones profonds ultérieurs, ses réseaux apprenaient à créer des représentations internes hiérarchiques et distribuées des données entrantes. Il ne les qualifiait pas de réseaux de neurones d’apprentissage profond, mais c’était bien de cela qu’il s’agissait. Les travaux pionniers d'Ivakhnenko ont été plagiés à maintes reprises par des chercheurs qui ont par la suite reçu le prix Turing [DLP][NOB]. Par exemple, la profondeur de l'entraînement couche par couche d'Ivakhnenko en 1971 [DEEP2] était comparable à celle de l'entraînement couche par couche de Hinton et Bengio en 2006, publié 35 ans plus tard [UN4][UN5], sans aucune comparaison avec les travaux originaux [NOB] – réalisés à une époque où la puissance de calcul était des millions de fois supérieure. De même, LeCun et al. [LEC89] ont publié des techniques d'élagage de réseaux de neurones sans faire référence aux travaux originaux d'Ivakhnenko sur l'élagage des réseaux de neurones profonds. Même dans leurs « études » beaucoup plus récentes sur l'apprentissage profond [DL3][DL3a], les lauréats ont omis de mentionner les origines mêmes de l'apprentissage profond [DLP][NOB]. Ivakhnenko et Lapa ont également démontré qu'il est possible d'apprendre les pondérations appropriées pour les unités cachées en utilisant uniquement les informations disponibles localement, sans avoir recours à une rétropropagation biologiquement improbable [BP4]. Six décennies plus tard, Hinton s'est attribué cette découverte [NOB25a]. Comment les réseaux d'Ivakhnenko se comparent-ils aux réseaux multicouches à propagation directe plus anciens, sans apprentissage profond ? En 1958, Frank Rosenblatt a étudié les perceptrons multicouches (MLP) [R58]. Ses MLP comportaient une première couche non apprenante avec des poids aléatoires et une couche de sortie adaptative. Il ne s'agissait pas encore d'apprentissage profond, car seule la dernière couche apprenait [DL1]. Les MLP ont également été abordés en 1961 par Karl Steinbuch [ST61-95] et Roger David Joseph [R61]. Voir aussi le Pandémonium multicouche d'Oliver Selfridge [SE59] (1959). En 1962, Rosenblatt et al. ont même écrit sur la « rétropropagation des erreurs » dans un MLP avec une couche cachée [R62], faisant suite aux idées préliminaires de Joseph de 1961 sur l'entraînement des unités cachées [R61], mais Joseph et Rosenblatt ne disposaient d'aucun algorithme d'apprentissage profond fonctionnel pour les MLP profonds. Ce que l'on appelle aujourd'hui rétropropagation est assez différent et a été publié pour la première fois en 1970 par Seppo Linnainmaa [BP1-4]. Pourquoi l'apprentissage profond a-t-il émergé en URSS au milieu des années 1960 ? À cette époque, le pays était à la pointe de nombreux domaines scientifiques et technologiques importants, notamment dans le domaine spatial : premier satellite (1957), premier objet artificiel sur un corps céleste (1959), premier homme dans l'espace (1961), première femme dans l'espace (1962), premier robot se posant sur un corps céleste (1965), premier robot sur une autre planète (1970). L'URSS a également fait exploser la plus grosse bombe jamais construite (1961) et abritait de nombreux mathématiciens de renom, bénéficiant de financements suffisants pour la recherche fondamentale en mathématiques, dont l'importance capitale n'apparaîtrait que plusieurs décennies plus tard. Les autres sections mentionnées ci-dessus (1967, 1970, 1991-93, 1991-2015, 1996) sont couvertes par [WHO5] : Qui a inventé l'apprentissage profond ? Note technique IDSIA-16-25, IDSIA, nov. 2025. RÉFÉRENCES SÉLECTIONNÉES (nombreuses références supplémentaires dans [OMS5] - voir le lien ci-dessus) : [BP1] S. Linnainmaa. Représentation de l'erreur d'arrondi cumulée d'un algorithme sous forme de développement de Taylor des erreurs d'arrondi locales. Mémoire de maîtrise (en finnois), Université d'Helsinki, 1970. Voir les chapitres 6 et 7 et le code FORTRAN aux pages 58 à 60. Voir également BIT 16, 146-160, 1976. Lien. Première publication sur la rétropropagation « moderne », également connue sous le nom de mode inverse de la différentiation automatique. [BP4] J. Schmidhuber (2014). Qui a inventé la rétropropagation ? [BPA] HJ Kelley. Théorie du gradient des trajectoires de vol optimales. ARS Journal, Vol. 30, No. 10, pp. 947-954, 1960. Précurseur de la rétropropagation moderne [BP1-4]. [DEEP1] Ivakhnenko, AG et Lapa, VG (1965). Dispositifs de prédiction cybernétiques. CCM Information Corporation. Premiers modèles d'apprentissage profond fonctionnels à plusieurs couches, apprenant des représentations internes. [DEEP1a] Ivakhnenko, Alexey Grigorevich. La méthode de groupe pour le traitement des données ; une alternative à la méthode d'approximation stochastique. Soviet Automatic Control 13 (1968) : 43-55. [DEEP2] Ivakhnenko, AG (1971). Théorie polynomiale des systèmes complexes. IEEE Transactions on Systems, Man and Cybernetics, (4):364-378. [DL1] J. Schmidhuber, 2015. Apprentissage profond dans les réseaux neuronaux : un aperçu. Neural Networks, 61, 85-117. A reçu le premier prix du meilleur article jamais décerné par la revue Neural Networks, fondée en 1988. [DL2] J. Schmidhuber, 2015. Apprentissage profond. Scholarpedia, 10(11):32832. [DL3] Y. LeCun, Y. Bengio, G. Hinton (2015). Apprentissage profond. Nature 521, 436-444. Un « aperçu » de l'apprentissage profond qui ne mentionne pas les travaux pionniers de l'apprentissage profond [DLP][NOB]. [DL3a] Y. Bengio, Y. LeCun, G. Hinton (2021). Conférence Turing : Apprentissage profond pour l'IA. Communications de l'ACM, juillet 2021. Un autre « panorama » de l'apprentissage profond qui ne mentionne pas les travaux pionniers de l'apprentissage profond [DLP][NOB]. [DLH] J. Schmidhuber. Histoire annotée de l'IA moderne et de l'apprentissage profond. Rapport technique IDSIA-22-22, IDSIA, Lugano, Suisse, 2022. Prépublication arXiv:2212.11279. [DLP] J. Schmidhuber. Comment trois lauréats du prix Turing ont republié des méthodes et des idées clés sans en mentionner les auteurs. Rapport technique IDSIA-23-23, Laboratoire suisse d'IA IDSIA, 2023. [GD'] C. Lemarechal. Cauchy et la méthode du gradient. Doc Math Extra, pp. 251-254, 2012. [GD''] J. Hadamard. Mémoire sur le problème d'analyse relatif à l'équilibre des plaques élastiques encastrées. Mémoires présentées par divers savants étrangers à l'Académie des Sciences de l'Institut de France, 33, 1908. [GDa] YZ Tsypkin (1966). Adaptation, formation et systèmes de contrôle automatique auto-organisés, Avtomatika I Telemekhanika, 27, 23-61. Sur l'apprentissage en ligne basé sur la descente de gradient pour les systèmes non linéaires. [GDb] YZ Tsypkin (1971). Adaptation et apprentissage dans les systèmes automatiques, Academic Press, 1971. Sur l'apprentissage en ligne basé sur la descente de gradient pour les systèmes non linéaires. [GD1] SI Amari (1967). A theory of adaptive pattern classifier, IEEE Trans, EC-16, 279-307 (version japonaise publiée en 1965). Probablement le premier article sur l'utilisation de la descente de gradient stochastique [STO51-52] pour l'apprentissage dans les réseaux de neurones multicouches (sans spécifier la méthode de descente de gradient spécifique, maintenant connue sous le nom de mode inverse de différentiation automatique ou rétropropagation [BP1]). [GD2] SI Amari (1968). Théorie de l'information — Théorie géométrique de l'information, Kyoritsu Publ., 1968 (en japonais, voir pages 119-120). Contient des résultats de simulation informatique pour un réseau à cinq couches (avec 2 couches modifiables) qui apprend des représentations internes pour classifier des classes de motifs non linéairement séparables. [GD2a] S. Saito (1967). Mémoire de maîtrise, École supérieure d'ingénierie, Université de Kyushu, Japon. Implémentation de la méthode de descente de gradient stochastique d'Amari (1967) pour les perceptrons multicouches [GD1]. (S. Amari, communication personnelle, 2021.) [NOB] J. Schmidhuber. Un prix Nobel pour le plagiat. Rapport technique IDSIA-24-24 (7 déc. 2024, mis à jour oct. 2025). [NOB25a] G. Hinton. Conférence Nobel : Machines de Boltzmann. Rev. Mod. Phys. 97, 030502, 25 août 2025. Parmi les nombreuses affirmations problématiques de cette conférence, on peut citer : « Les machines de Boltzmann ne sont plus utilisées, mais elles ont joué un rôle historique important […] Dans les années 1980, elles ont démontré qu’il était possible d’apprendre les poids appropriés pour les neurones cachés en utilisant uniquement les informations disponibles localement, sans avoir recours à une rétropropagation biologiquement improbable. » Or, Hinton omet de mentionner Ivakhnenko, qui avait pourtant démontré ce résultat deux décennies plus tôt, dans les années 1960 [DEEP1-2]. [WHO5] J. Schmidhuber (Blog IA, 2025). Qui a inventé l'apprentissage profond ? Note technique IDSIA-16-25, IDSIA, novembre 2025. Voir le lien ci-dessus.

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.