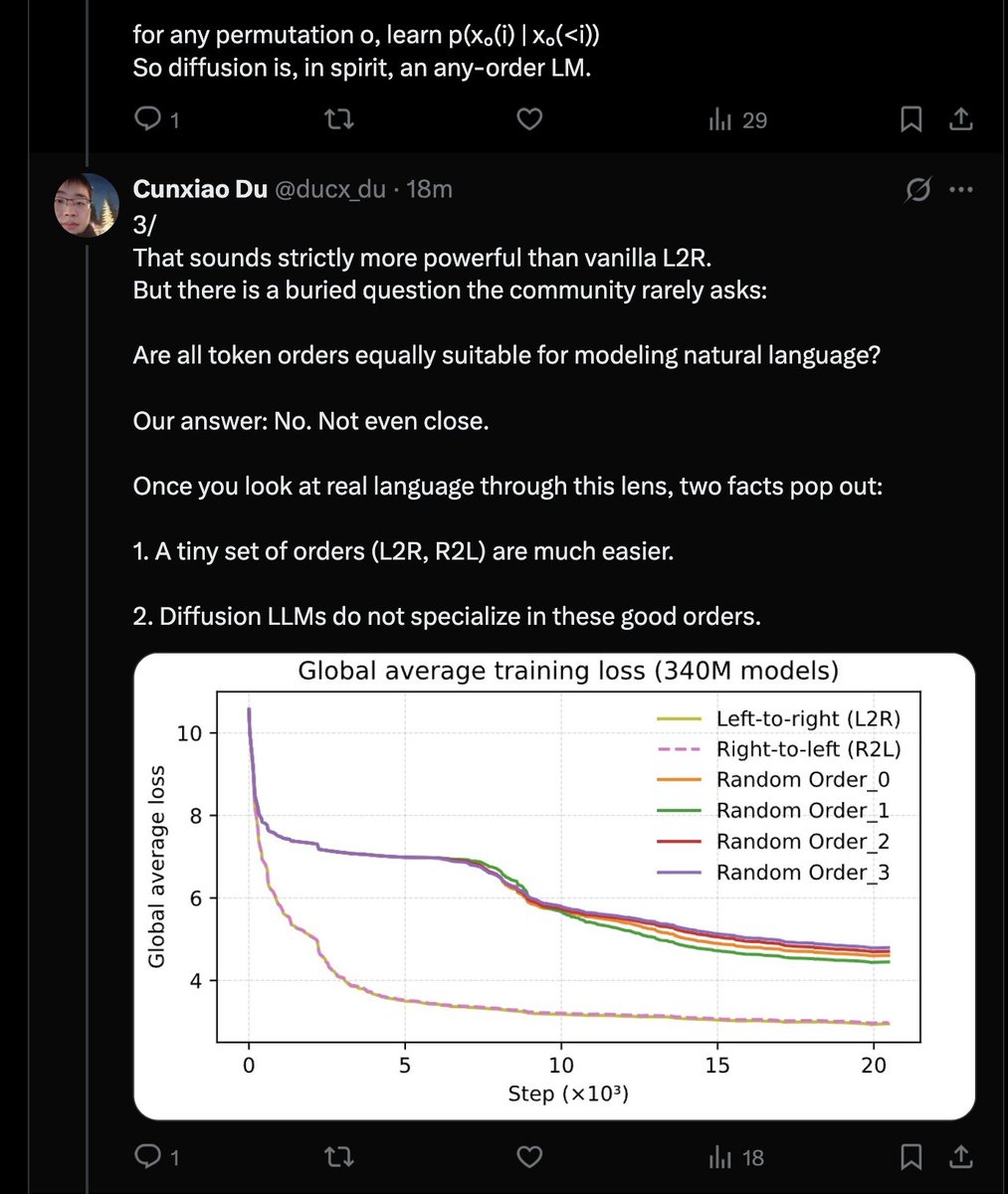

Un récit extrêmement puissant. Les modèles de diffusion, par défaut, n'ont aucun sens car le langage est markovien et les ordres L2R ou R2L sont strictement supérieurs. Il semble que la seule méthode sensée pour entraîner des modèles de langage à diffusion profonde (DLLM) soit l'utilisation de la perte logarithmique.

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.